平均成功率从50%提高到100%。

人工智能最近取得了有目共睹的进展,现在这些进步开始渗透到机器人领域。强大的人工智能技术还可以帮助机器人更好地理解它们所生活的物理世界,并采取更合理的行动。

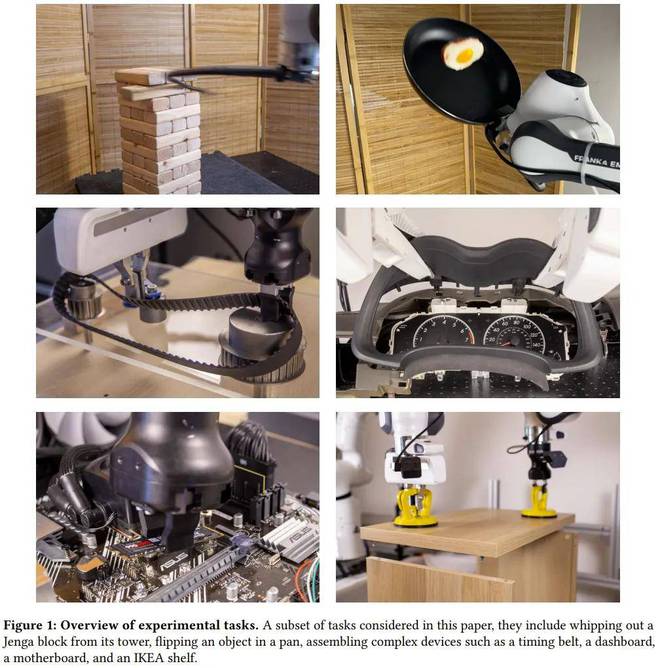

近日,加州大学伯克利分校 BAIR 实验室 Sergey Levine 的研究团队提出了一种强化学习框架 HIL-SERL,可以直接训练现实世界中通用的基于视觉的机器人操作策略。 HIL-SERL 的性能是前所未有的,只需 1-2.5 小时的培训即可实现所有任务 100% 的成功率。要知道,基线方法的平均成功率不到50%。即使有外部干扰,机器人也能取得非常好的性能。

该论文的第一作者是目前在加州大学伯克利分校 BAIR 实验室从事博士后研究的罗建兰的推文。

团队导师谢尔盖·莱文(Sergey Levine)也在推特上宣传了这项研究。他是一位非常著名的人工智能和机器人研究科学家。他是2021年发表相关论文最多的研究员。参见Heart of Machine报告《2021年的ML和NLP》学术统计:谷歌故障排名第一,强化学习专家Sergey Levine位居榜首。

空谈,眼见为实,那就先让机器人煎个鸡蛋吧。

主板上装SSD吗?机器人还可以与人类配对,轻松完成任务。

插入USB并不是什么大问题。看起来比人做这个操作还要顺利。毕竟很多人都要将USB对齐两三遍才能成功插入。

这么好的效果,不禁让人疑惑,这不是遥控器吗?诺诺诺!这些任务都是由机器人独立完成的。这一次,人类的角色不是站在后面发号施令,而是在旁边制造麻烦。

对于一个没有独立思考能力的机器人来说,任务的执行是相当僵化的。一旦目标物体改变位置,它们就会迷失方向。但对于采用HIL-SERL框架的机器人来说,即使你强行拿走它手中的USB线,它仍然可以自动定位并重新完成任务。

机器人是如何变得如此强大的?让我们来看看加州大学伯克利分校的这项研究。

简而言之,他们设计了一个有人类参与的强化学习框架。在此之前,基于强化学习的技术已经给机器人领域带来了一些技术突破,使得机器人能够熟练地处理一些简单的任务。然而,现实世界的环境是非常动态、多变和复杂的。如果能够开发出某种通用的基于视觉的方法,那肯定会帮助机器人掌握更复杂的技能。

这就是该团队的贡献所在,开发了一种基于视觉的强化学习系统,可以让机器人掌握大量不同的机器人技能。

他们将该系统命名为“人机循环样本高效机器人强化学习”(Human-in-the-Loop Sample-Efficient Robotic Reinforcement Learning),简称 HIL-SERL。

为了解决优化稳定性问题,他们采用了预训练的视觉主干网络来实现策略学习。

为了解决样本复杂性问题,他们采用了基于RLPD的样本高效离策略强化学习算法,并结合了人工演示和校正。

此外,为了确保策略训练期间的安全,他们还采用了精心设计的低级控制器。

在训练时,系统会向操作人员询问潜在的修正,然后以脱离策略的方式使用这些修正来更新策略。他们发现,这种人为参与的纠正程序使策略能够从错误中学习并提高性能,特别是对于本研究中考虑的一些难以从头开始学习的任务。

如图 1 所示,该系统可以解决各种任务,包括动态翻转平底锅中的物体、从积木塔中取出积木、在两个机械臂之间传递物体以及使用一个或两个机械臂进行组装。复杂的设备,例如计算机主板、宜家货架、汽车仪表板或正时皮带。

这些任务复杂而精密,具有动态和高维的动作空间。此前有研究人员甚至认为其中一些技能无法通过强化学习来学习,但 BAIR 团队的研究反驳了这一说法。

研究和实验表明,他们的系统可以在相对较短的时间内(1-2.5 小时)实现所有这些任务的近乎完美的成功率。

使用相同数量的人类数据(演示和纠正的次数),他们训练的策略远远优于模仿学习方法——平均成功率超过 101%,周期时间平均快 1.8 倍。

这是一个重要的结果,因为它表明强化学习确实可以利用实际训练时间直接在现实世界中学习大量不同的复杂的基于视觉的操作策略。以前的强化学习方法无法做到这一点。此外,强化学习可以达到超人的水平,远远优于模仿学习和手工设计的控制器。

这是一个超人表演的有趣例子:用鞭子抽出一个方块,同时保持方块塔稳定。显然,这个任务对于大多数人来说是非常困难的,但是这个机器人通过强化学习掌握了这项技能。

人类参与的强化学习系统

系统概述

HIL-SERL系统由三个主要组件组成:参与者进程、学习者进程以及位于学习者进程中的重放缓存。它们都可以以分布式方式运行,如图 2 所示。

参与者进程通过在机器人上执行当前策略并将数据发送回重播缓存来与环境进行交互。

该环境采用模块化设计,允许灵活配置各种设备,包括支持多个摄像头以及集成SpaceMouse等输入设备进行远程操作。

为了评估任务成功,还需要奖励函数,并且该奖励函数是使用人类演示进行离线训练的。

在actor过程中,人类可以使用SpaceMouse从强化学习策略中接管机器人的控制权,从而干预机器人的动作。

该团队使用了两个重播缓存,一个用于存储离线人类演示(演示缓存),另一个用于存储策略数据(RL 缓存)。

learner进程从demo缓存和RL缓存中均匀采样数据,使用RLPD优化策略,并定期将更新的策略发送给actor进程。