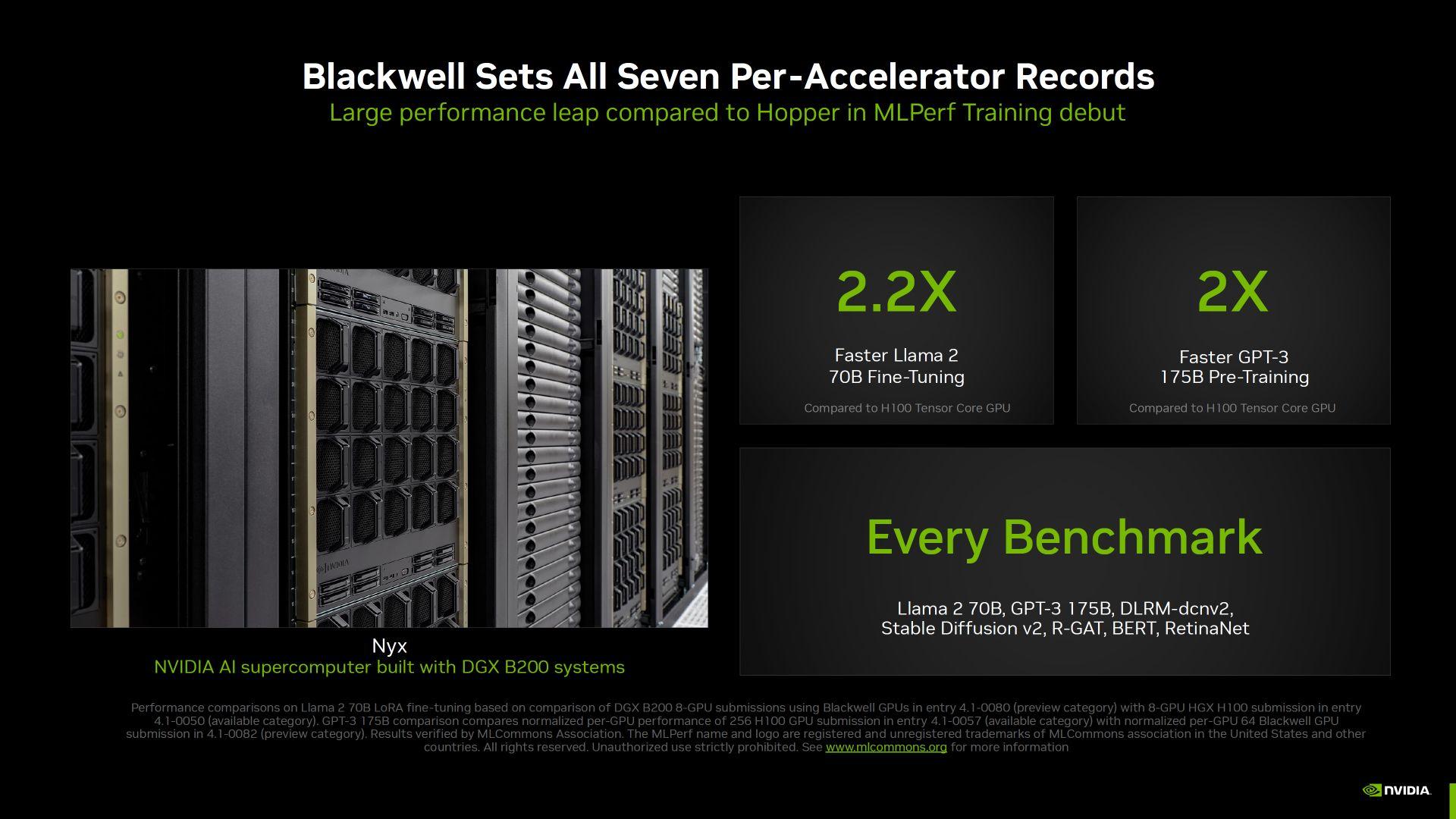

IT之家11月14日消息,科技媒体 WccfTech 昨日(11 月 13 日)发表博文,报道 NVIDIA 首次公布 Blackwell GPU 在 MLPerf v4.1 AI 训练工作负载中的成绩。在训练中,Llama 2 70B(Fine-Tuning)模型比 Hopper 快 2.2 倍。

测试简介

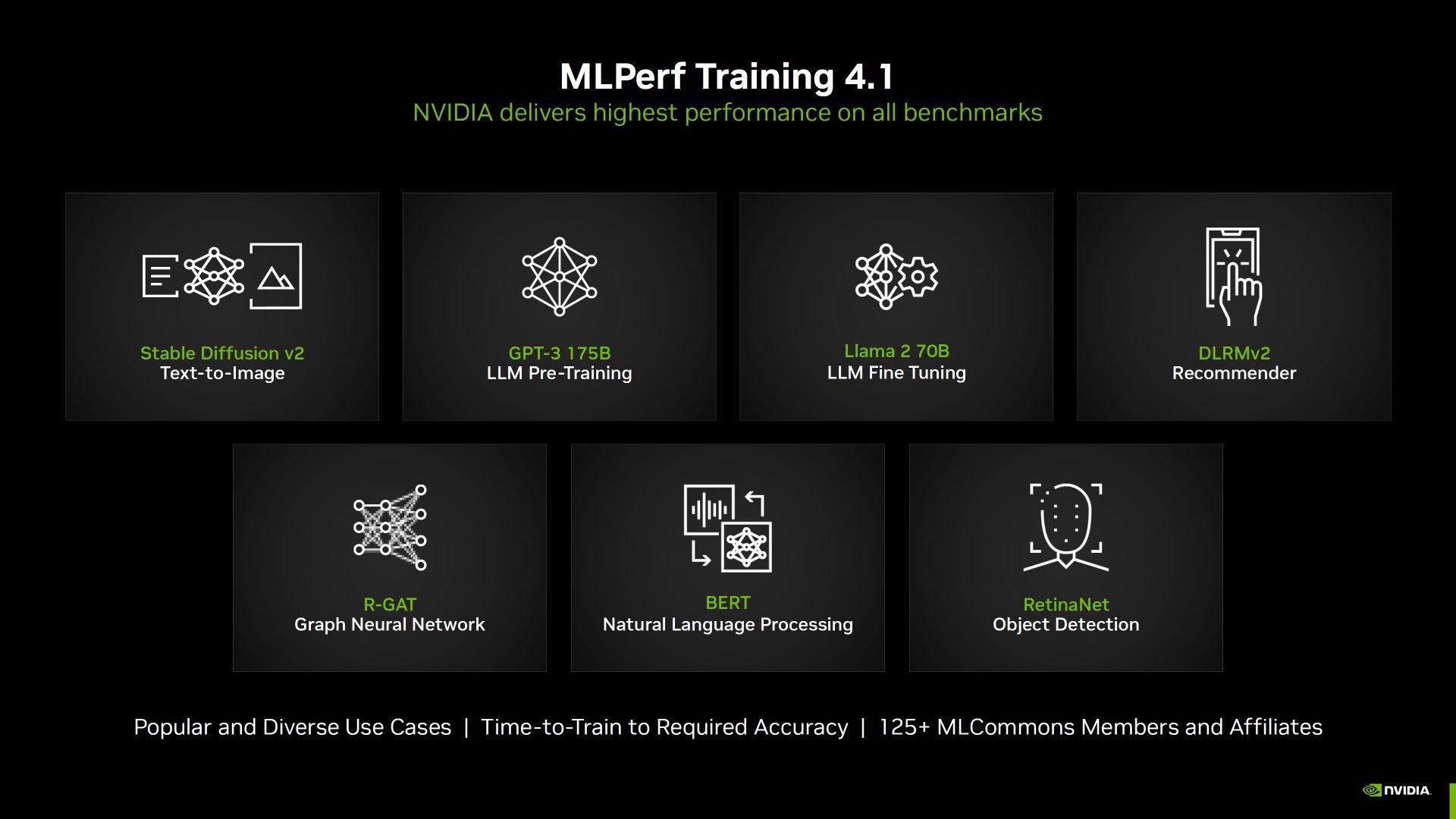

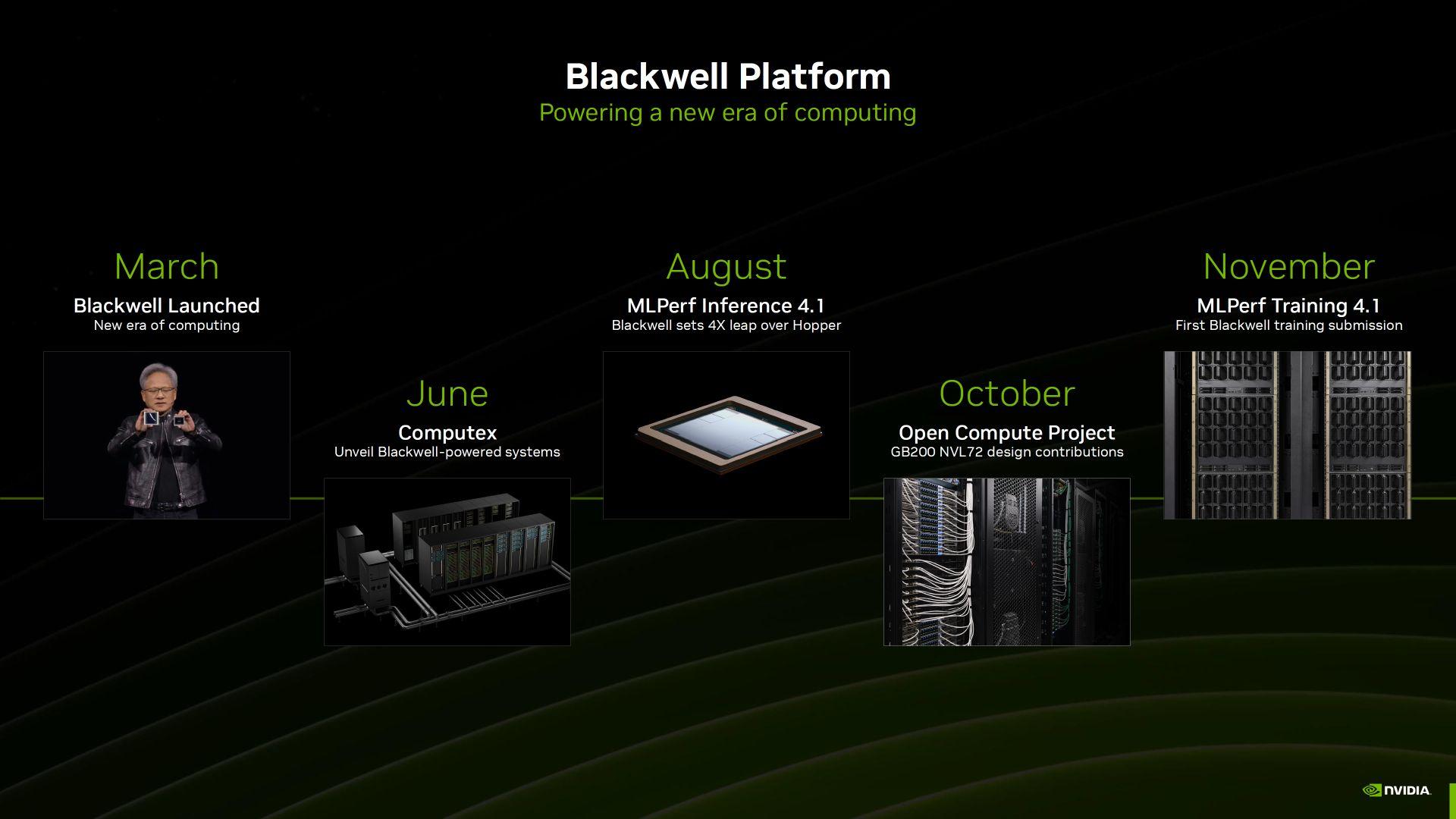

今年8月,NVIDIA首次公布了Blackwell GPU在MLPerf v4.1 AI推理中的基准测试结果,今天又首次公布了该GPU在MLPerf v4.1 AI训练工作负载中的测试结果。

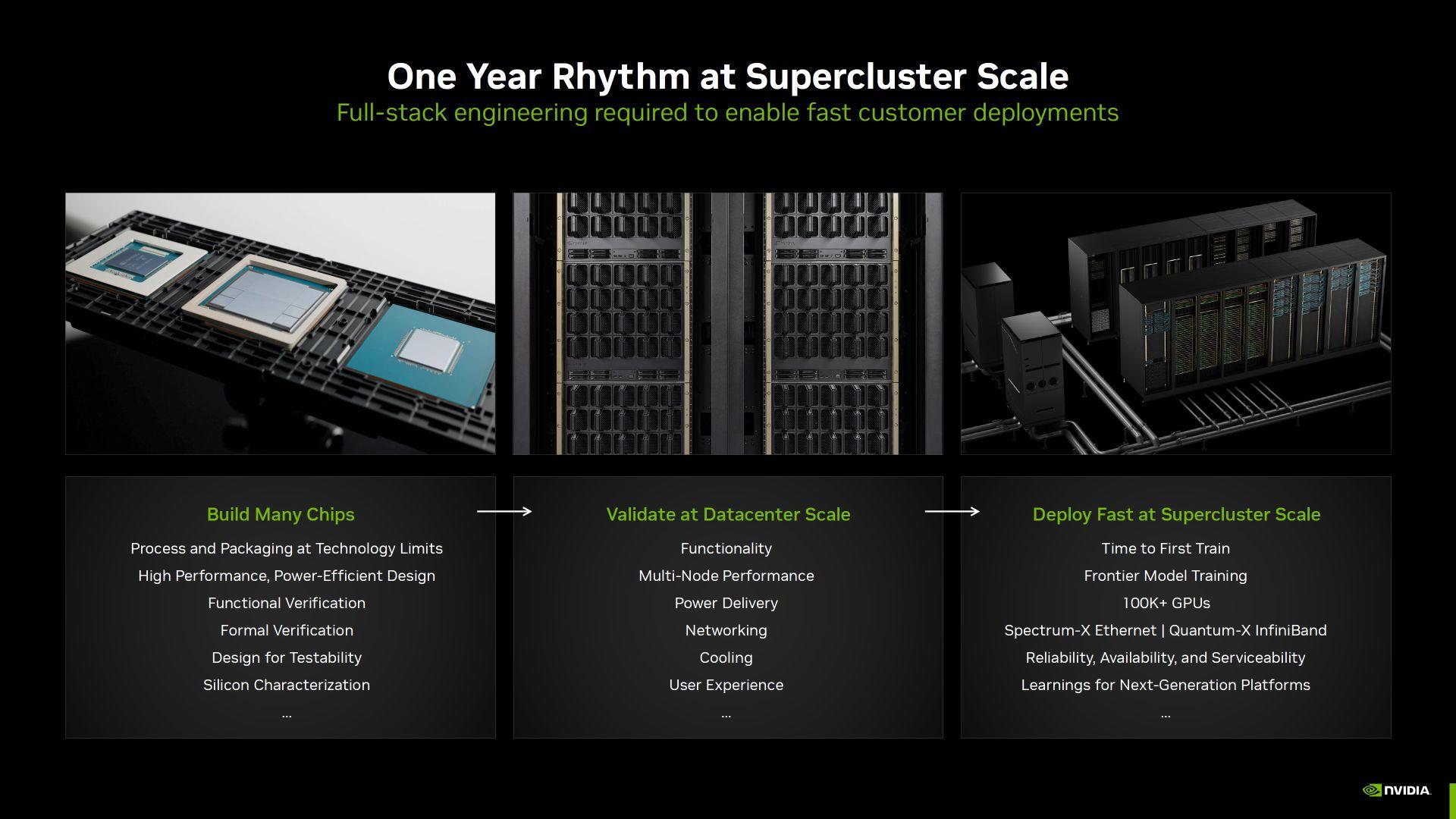

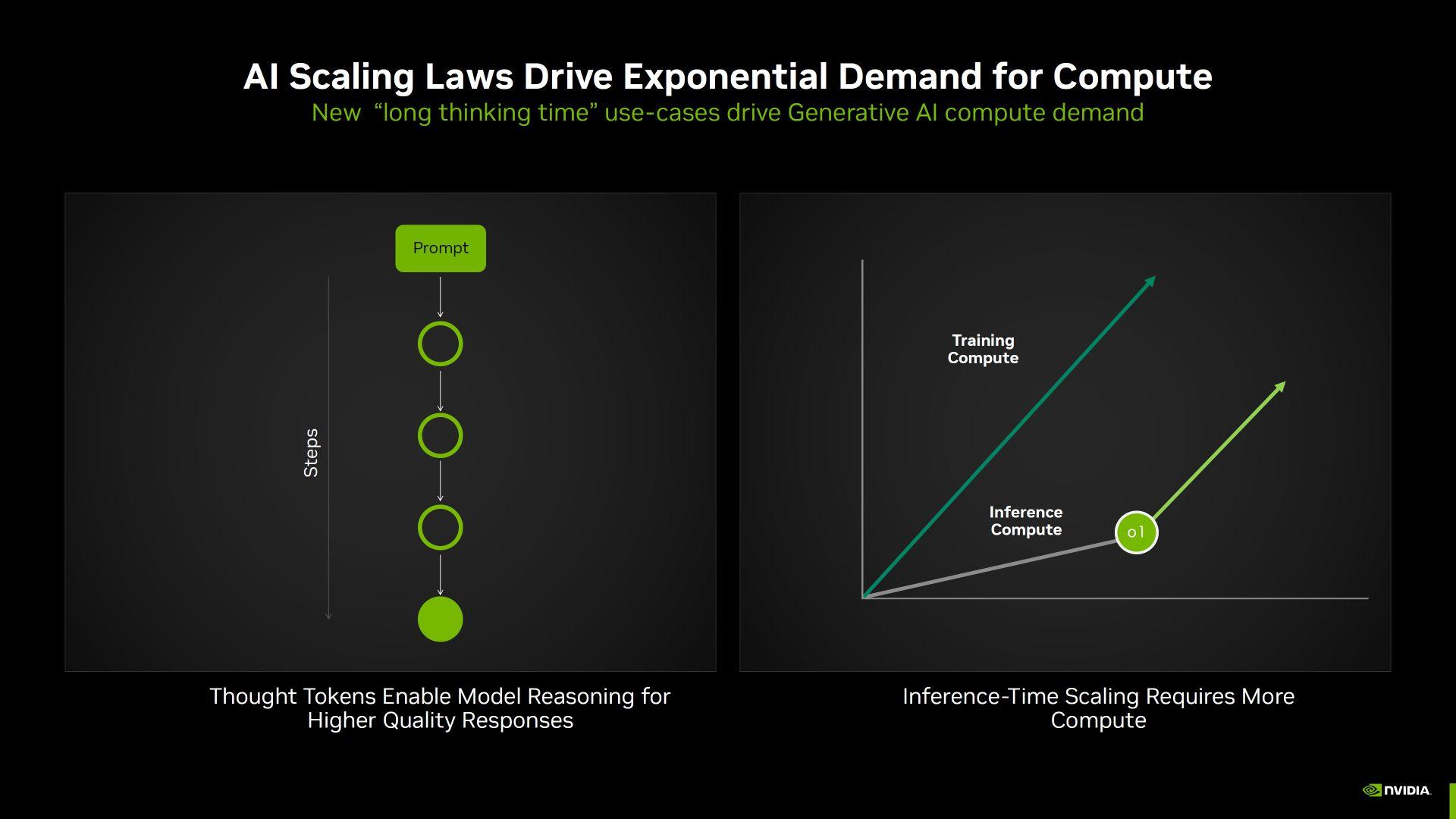

NVIDIA表示,随着新模型的推出,AI领域的计算需求呈指数级增长,因此AI的训练和推理能力需要大幅提升。 IT之家附上本次训练工作量主要使用的模型如下:

这些工作负载的基准为评估AI加速器的训练性能提供了准确的数据支持。

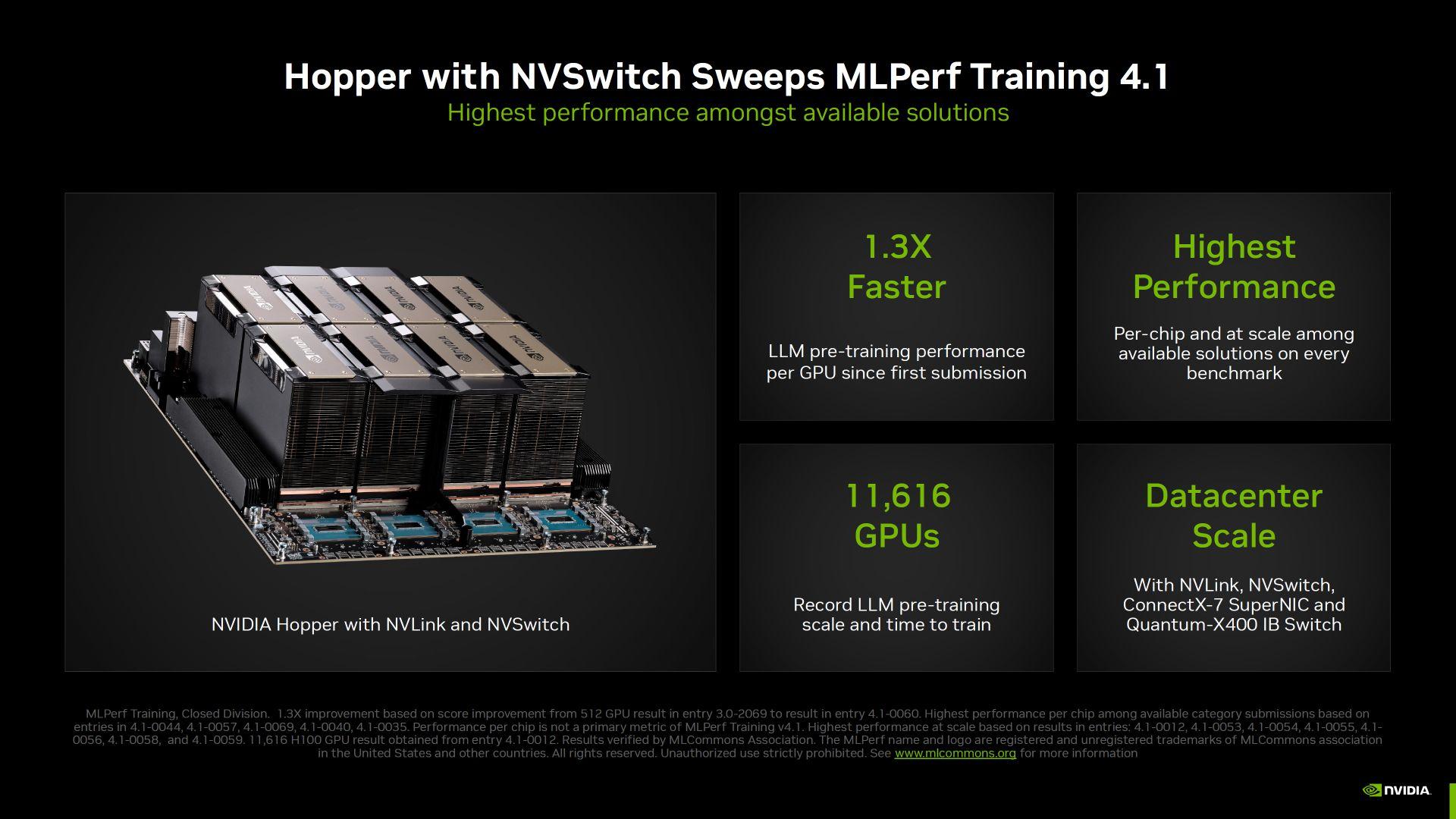

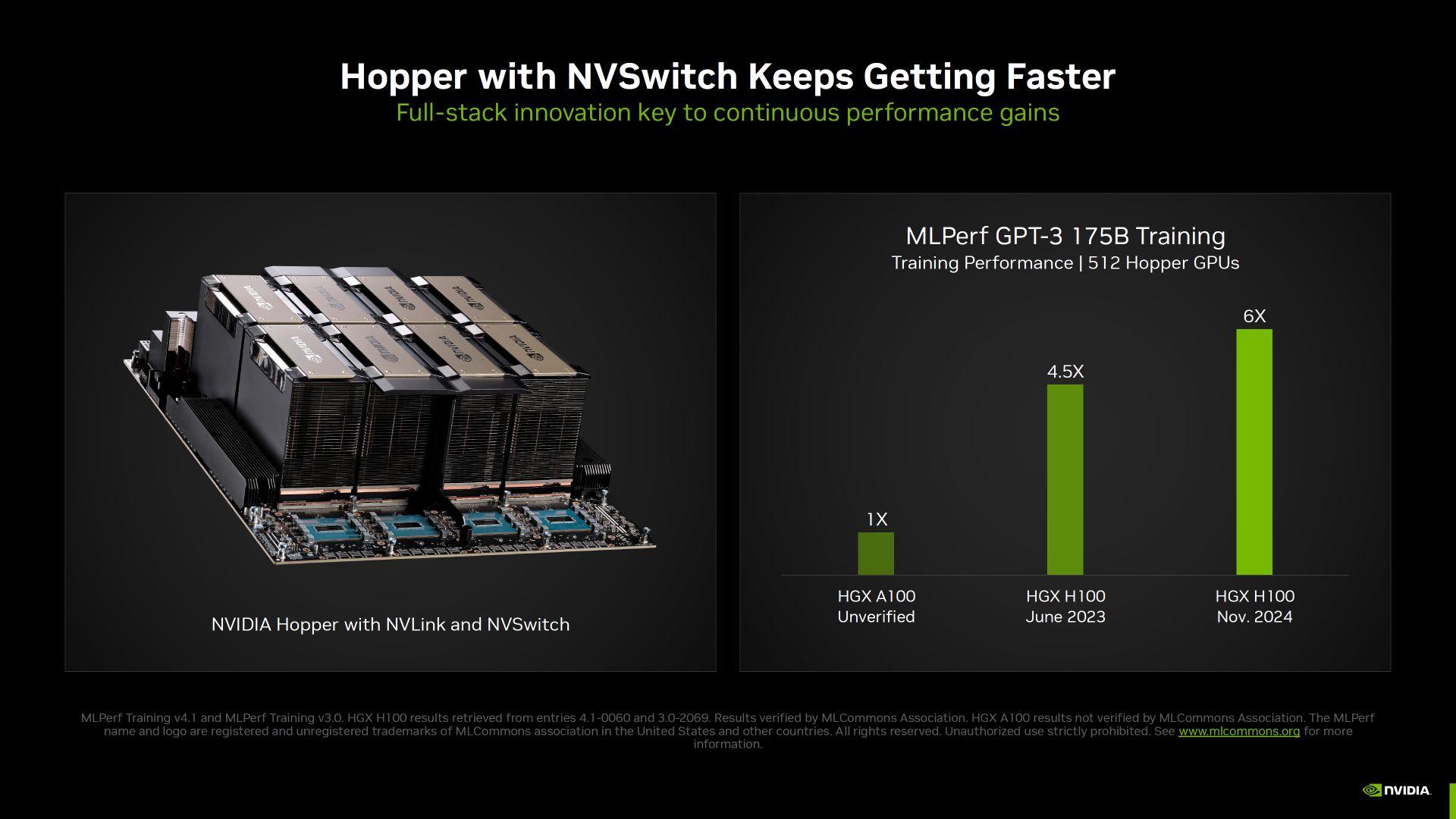

Hopper GPU持续优化

自发布以来,Hopper GPU 性能通过不断的软件优化得到了显着提升。 H100 GPU 的 LLM 预训练性能比首次提交时快 1.3 倍,并且在 GPT-3(175B 训练)中实现了 70% 的性能提升。

NVIDIA 使用 11,616 个 H100 GPU 向 MLPerf 提交了最大规模的提交,进一步展示了其在数据中心级别的强大功能。

布莱克威尔的技术优势

Blackwell GPU 旨在提高每个 GPU 的计算吞吐量,配备了更大、更快的高带宽内存,允许 GPT-3 175B 基准测试在更少的 GPU 上运行,而不会牺牲性能。

根据测试结果,64个Blackwell GPU的测试性能可以达到256个Hopper GPU的水平。