今年,AI圈子真是一波又一波的热闹。

近日,有关缩放定律“碰壁”的消息在AI圈炸开了锅。图灵奖获得者 Yann Lecun、Ilya 和 Anthropic 创始人 Dario Amodei 展开了一场口水战。

争论的核心是,随着模型规模的不断增大,性能改进是否会存在上限。随着舆论愈演愈烈,OpenAI CEO Sam Altman刚刚在X平台上回应:

“没有墙,没有墙”

在这场争论的背景下,彭博社透露了一条惊人的消息。

OpenAI计划于明年1月推出一款名为“Operator”的AI Agent。该代理可以使用计算机代表用户执行任务,例如编写代码或预订旅行。

此前,Anthropic、微软和谷歌也被透露正在规划类似的方向。

对于整个人工智能行业来说,人工智能技术的发展从来都不是一个单一维度的线性过程。当一个方向看似遇到阻力时,创新往往会在其他维度取得突破。

扩展法则碰壁了?下一步是什么?

《Scaling Laws》遇到瓶颈的消息首先来自外媒The Information上周末的报道。

这份长达数千字的雄辩报告揭示了两个关键信息。

好消息是,虽然 OpenAI 已经完成了下一代模型 Orion 20% 的训练过程,但 Altman 表示,Orion 在智能以及执行任务和回答问题的能力方面已经与 GPT-4 不相上下。

坏消息是,根据使用过的 OpenAI 员工的评价,与 GPT-3 和 GPT-4 之间的巨大进步相比,Orion 的改进较小,比如在编程等任务上表现较差,并且更高运行成本。

一句话,缩放法则遇到了瓶颈。

为了了解缩放法则没有想象中那么好带来的影响,我们有必要向不熟悉缩放法则的朋友简单介绍一下缩放法则的基本概念。

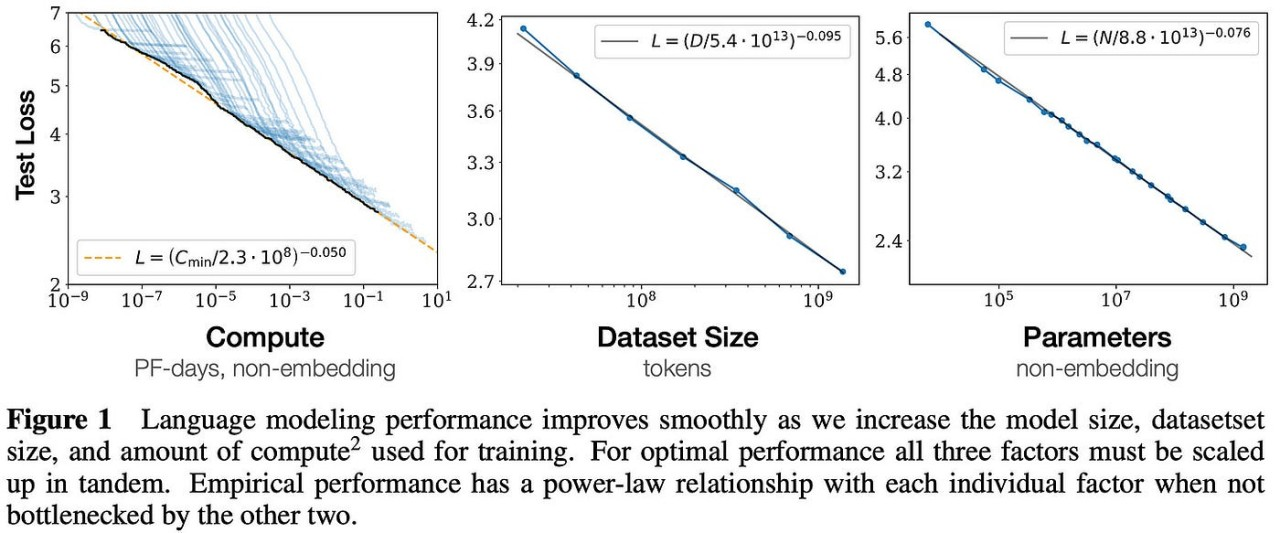

2020年,OpenAI在一篇论文中首次提出了Scaling Laws。

该理论指出,大型模型的最终性能主要与计算量、模型参数量和训练数据量有关,而与模型的具体结构(层数)基本无关。 /深度/宽度)。

说起来有点尴尬,但从人的角度来说,大型模型的性能会随着模型规模、训练数据量、计算资源的增加而相应提高。

OpenAI的这项研究为后续大型模型的开发奠定了基础。它不仅为GPT系列模型的成功做出了贡献,而且为训练ChatGPT提供了优化模型设计和训练的关键指导原则。

然而,当我们还在考虑 GPT-100 的时候,The Information 透露,单纯增加模型大小已经不能保证性能的线性提升,并且伴随着高昂的成本和显着的边际效益递减。

OpenAI 并不是唯一遇到困难的公司。

彭博社援引知情人士的话称,谷歌的Gemini 2.0也未能达到预期目标。与此同时,Anthropic的Claude 3.5 Opus的发行时间也一再推迟。

在与时间赛跑的AI行业,没有产品的新消息往往意味着最大的坏消息。

需要明确的是,这里提到的Scaling Laws的瓶颈并不意味着大型模型发展的终结。更深层次的问题是,高成本导致边际效益回报严重递减。

Anthropic首席执行官Dario Amodei曾透露,随着模型变得越来越大,训练成本呈爆炸式增长,目前正在开发的AI模型的训练成本高达10亿美元。

阿莫代还指出,未来三年,AI训练成本将飙升至100亿美元甚至1000亿美元的天文数字。

以GPT系列为例,仅GPT-3的单次训练成本就高达约140万美元。这些支出主要来自于强大计算资源的消耗,尤其是GPU的使用,以及巨额的电力支出。

仅 GPT-3 的训练就消耗了 1287 MWh 的电力。

去年,加州大学河滨分校的研究表明,ChatGPT 每与用户交流 25-50 个问题就会消耗 500 毫升的水。预计到2027年,全球人工智能每年清洁淡水需求可能达到4.2-66亿立方米。米,相当于4-6丹麦或英国一半的年耗水量。

从GPT-2到GPT-3再到GPT-4,AI带来的体验提升是突飞猛进的。

正是基于这一显着进展,各大公司才会在AI领域进行大力投入。但当这条路逐渐显现出尽头时,单纯追求模型规模的扩大已经不能保证性能的显着提升。成本高、边际效益递减已成为不得不面对的现实。

现在,与其一味地追求规模,更重要的是朝着正确的方向实施Scaling。

再见,GPT;你好,推理“O”

每个人都拒绝隔离墙,甚至是理论。

当Scaling Laws疑似遇到瓶颈的消息在AI圈引起轩然大波时,质疑声也随之涌动。

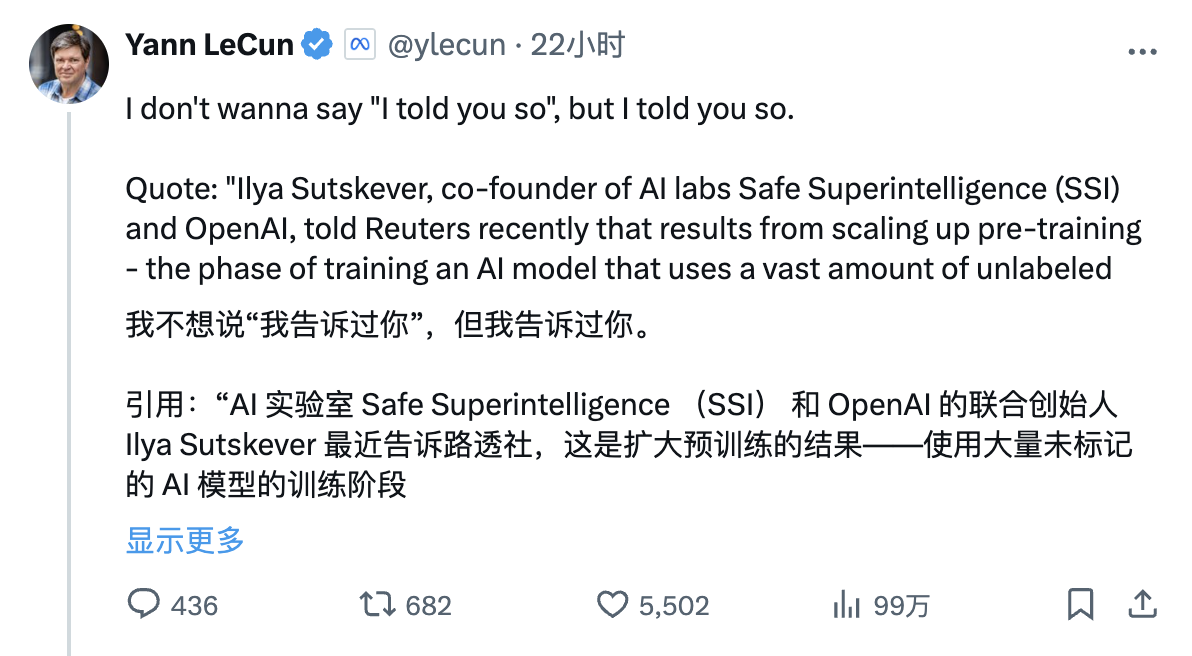

一向持反主流立场的图灵奖获得者、meta AI 首席科学家 Yann Lecun 昨天在 X 平台兴奋地转发了路透社对 Ilya Sutskever 的采访,并配文如下:

“我不想听起来像是事后才想到的,但我确实提醒过你。

引用:“AI 实验室 Safe Superintelligence (SSI) 和 OpenAI 的联合创始人 Ilya Sutskever 最近向路透社表示,通过扩大预训练阶段——即使用大量未标记的数据来训练 AI 模型来理解语言模式和结构——结果已经停滞了。”

回顾这两年AI巨头对当前大模型路线的评价,可以说是字字句句细致、句句热血。

比如,现在的AI比猫还笨,智力也远远落后; LLM缺乏对物理世界的直接体验,只能操纵文本和图像,而没有真正理解世界。如果继续强迫自己,只会走向死胡同等等。

时间拨回两个月前,Yann Lecun毫不客气地宣判了当前主流路线的死刑。在众多AI末日论中,他也坚信,有关AI将威胁人类生存的说法纯属无稽之谈:

大型语言模型(LLM)无法回答其训练数据中未包含的问题,

他们无法解决未经训练的难题,

如果没有人类的大力帮助,他们就无法学习新的技能或知识,

他们无法创造新事物。目前,大语言模型只是人工智能技术的一部分。简单地扩大这些模型的规模并不能使它们有能力做到这一点。

同样在meta FAIR工作的田元东博士很早就预见到了目前的困境。

这位中国科学家在5月接受媒体采访时悲观地表示,缩放定律可能是正确的,但不会是全部。在他看来,Scaling Laws的本质就是用指数级的数据增长来换取“一点点的收获”。

“最终,人类世界可能有很多长尾需求,需要人类快速响应。这些场景下的数据本身就很小,LLM无法获取。最终,当Scaling法则发展起来时,大家可能站在同一个“数据孤岛上”,孤岛上的数据完全属于每个人,并且每时每刻都在不断产生。专家学会与人工智能融合,变得非常强大,人工智能无法取代他们。 ”

不过,情况或许还没有那么悲观。

客观地说,伊利亚在接受路透社采访时承认,《扩展法》带来的进展已经陷入停滞,但并没有宣告结束。

“2010 年代是扩展的时代,现在我们再次进入一个充满奇迹和发现的新时代。每个人都在寻找下一个重大突破。现在比以往任何时候都更重要的是选择正确的东西来扩展。”

而且,Ilya 还表示,SSI 正在探索一种新方法来扩展预训练过程。

达里奥·阿莫代最近也在播客中谈到了这一点。

他预测,低于人类水平的模型没有绝对的上限。由于该模型还没有达到人类水平,所以不能说缩放法则失败了,但确实出现了增长放缓。

自古以来,山不变水变,水不变人变。

上个月,OpenAI 研究员 Noam Brown 在 TED AI 会议上表示:

“事实证明,要求机器人在玩扑克牌时思考 20 秒,与将模型缩放 100,000 倍并训练时间延长 100,000 倍所带来的性能提升相同。”

对于昨天Yann lecun的事后言论,他是这样回应的:

“正如我之前所说,目前我们所处的世界是大规模语言模型预训练所需的计算成本非常非常高。但推理的成本非常低。很多人有理由担心,随着预训练的成本和训练所需的数据量变得如此之大,我们将看到人工智能进步的回报递减。但我认为从o1开始。真正重要的教训之一是,这堵墙并不存在,我们实际上可以进一步推动这一进程,因为现在,我们可以扩展推理计算,并且推理计算的扩展空间巨大。”

以诺姆·布朗为代表的研究人员坚信,推理/测试时计算很可能成为提高模型性能的又一灵丹妙药。

说到这里,就不得不提到大家熟悉的OpenAI o1模型。

与人类推理非常相似,o1 模型可以通过多步骤推理来“思考”问题。它强调在推理阶段给予模型更多的“思考时间”。它的核心秘密在于,在像GPT-4这样的网络中,在基础模型上进行额外的训练。

例如,模型最终可以通过实时生成和评估多个可能的答案来选择最佳的前进路径,而不是立即选择单个答案。这使得更多的计算资源可以专注于复杂的任务,例如数学问题和编程。谜题,或者那些需要类人推理和决策的复杂操作。

谷歌最近也遵循了这条路线。

据 The Information 报道,最近几周,DeepMind 在其 Gemini 部门组建了一个团队,由首席研究科学家 Jack Rae 和前 Character.AI 联合创始人 Noam Shazeer 领导,以开发类似的功能。

与此同时,谷歌也不甘示弱,正在尝试新的技术路径,包括调整“超参数”,这些变量决定模型如何处理信息,例如在训练中如何快速地在不同概念或模式之间建立联系。数据,并查看哪些变量会产生最佳结果。

顺便说一句,GPT 发展放缓的一个重要原因是缺乏高质量的文本和其他可用数据。

针对这个问题,谷歌研究人员原本希望通过AI合成数据,将音频和视频融入到Gemini的训练数据中来实现显着的改进,但这些尝试似乎收效甚微。

知情人士还透露,OpenAI 和其他开发者也使用合成数据。然而,他们也发现,合成数据对改进人工智能模型的作用非常有限。

你好贾维斯

再见 GPT,你好推理“o”。

在最近的 Reddit AMA 活动中,有网友询问 Altman 是否会推出“GPT-5”和完整版推理模型 o1。

当时,Altman 回应道:“我们正在优先推出 o1 及其后续版本”,并补充道,有限的计算资源导致很难同时推出多个产品。

他还强调,下一代型号可能不会继续命名为“GPT”。

现在看来,Altman急于与GPT命名系统划清界限,转而推出以“o”命名的推理模型。背后似乎有深意。推理模型的布局或许还是为目前主流的Agent奠定了基础。

近日,Altman 在接受 Y Combinator 总裁 Garry Tan 采访时也再次谈到了五级 AGI 理论:

L1:聊天机器人是具有对话能力的AI,可以与用户进行流畅的对话,提供信息、回答问题、辅助创作等,比如聊天机器人。

L2:推理机可以像人类一样解决问题的AI,可以解决类似于人类博士水平的复杂问题,并表现出强大的推理和解决问题的能力,例如OpenAI o1。

L3:智能体不仅能思考还能行动的人工智能系统,可以进行完全自动化的业务。

L4:创新者辅助发明创造的人工智能具有创新能力,可以协助人类在科学发现、艺术创作或工程设计等领域产生新的想法和解决方案。

L5:组织者可以用来完成组织工作的AI,可以自动控制整个组织跨业务流程的计划、执行、反馈、迭代、资源分配、管理等。它基本上与人类相似。

所以我们看到,像 Google 和 Anthropic 一样,OpenAI 现在正在将重点从模型转向一系列称为 Agents 的 AI 工具。

近日,彭博社还透露,OpenAI正准备推出一款名为“Operator”的新AI Agent,它可以使用计算机代表用户执行任务,例如编写代码或预订旅行。

在周三的员工会议上,OpenAI 领导层宣布计划在一月份发布该工具的研究预览版,并通过公司的应用程序编程接口 (API) 向开发人员提供该工具。

在此之前,Anthropic也推出了类似的Agent,它可以实时处理用户计算机任务并代表其执行操作。与此同时,微软最近推出了一套Agent工具,供员工发送电子邮件和管理记录。

谷歌还准备推出自己的人工智能代理。

报道还透露,OpenAI 正在开展多个与 Agent 相关的研究项目。最接近完成的是一个可以在网络浏览器中执行任务的通用工具。

这些智能体被期望能够理解、推理、计划和采取行动,但这些智能体实际上是由多个人工智能模型组成的系统,而不是单个模型。

比尔盖茨曾经说过,“每个桌面上都有一台电脑”,史蒂夫乔布斯说过,“每个人手里都有一部智能手机。”现在我们可以大胆预测:每个人都会拥有自己的AI Agent。

当然,人类的最终目标是希望有一天能够对眼前的AI说出经典的电影对白:

你好贾维斯