YOLO(You only Look Once)系列是目标检测领域的主流方法,以其高效和实时性而闻名。然而,现有的YOLO模型在处理跨层特征融合和复杂的高阶特征关系方面存在局限性,无法完全捕获跨位置和尺度的复杂特征相关性。

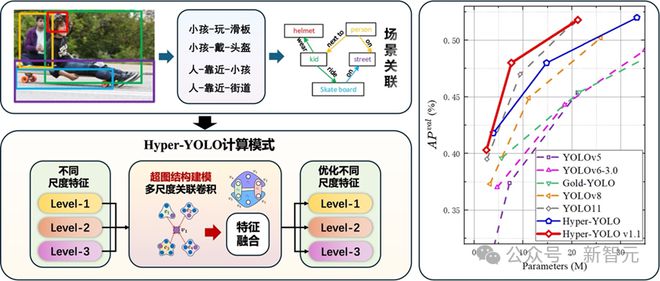

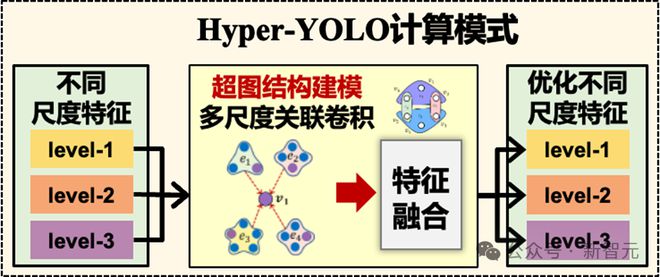

为了解决这个困难,清华大学提出了Hyper-YOLO:一种基于超图计算的目标检测方法。 Hyper-YOLO首次将超图计算集成到目标检测网络中,对特征图中复杂的高阶相关性进行建模,实现高阶信息的跨级别、跨位置传播。

作者名单:冯一凡、黄建刚、杜绍一、应石慧、勇俊海、李一鹏、丁桂光、季蓉蓉、高跃。

论文地址:

Github 存储库:

零代码平台::28501/#/predict

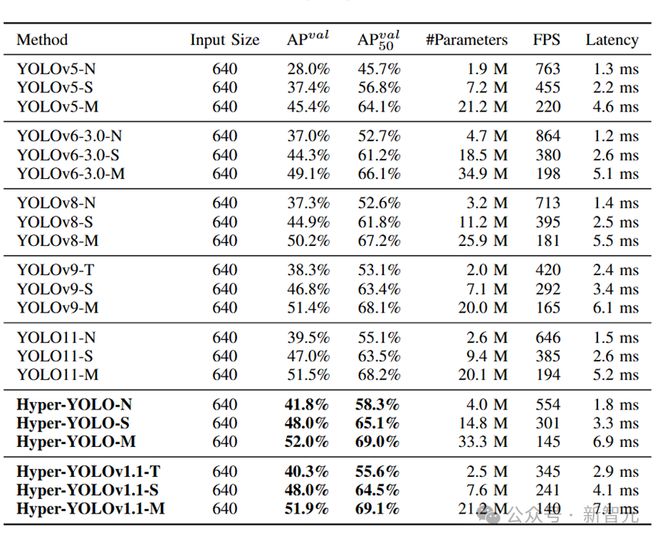

使用超图计算结合YOLO,性能在各种规模的模型中达到顶尖。在COCO数据集上的性能明显优于其他模型,特别是对于中小型目标。改善效果更为显着。其中,与最新的YOLOv9-T和YOLO11-S相比,相同规模的Hyper-YOLO分别实现了2%和1%的平均精度提升。

物体检测的困境

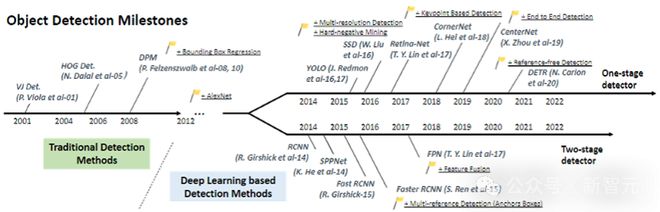

近年来,随着深度学习的快速发展,YOLO(You only Look Once)系列模型以其高效的单阶段检测架构在目标检测领域脱颖而出。 YOLO模型通过将目标检测简化为回归问题,在实现实时检测能力的同时保持高精度,受到了广泛的关注和应用。

然而,随着应用场景的复杂化,现有的YOLO模型在处理跨级特征融合和高阶特征关系时暴露出一定的局限性。

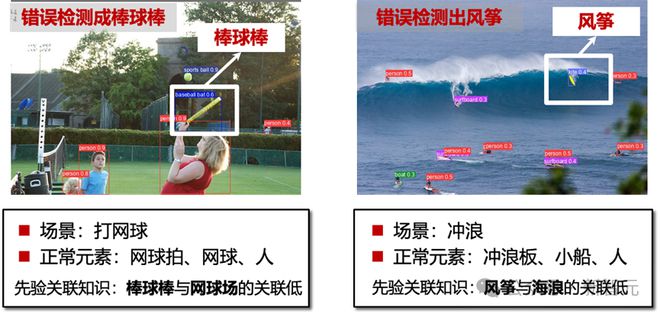

下图展示了几种典型案例(以YOLOv8为例)。在打网球的场景中,现有模型将网球拍误识别为棒球棒;在冲浪场景中,现有模型将冲浪板误识别为风筝。这个错误正是由于现有模型难以捕捉视觉对象之间的复杂关系造成的。

因此,不同目标之间的高阶语义关联推理限制了目标检测的性能。

高阶相关建模方法

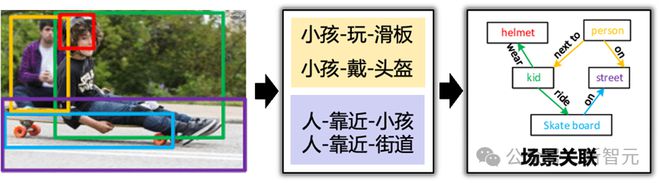

为了解决这些问题,学术界一直在探索更先进的模型设计和优化方法。其中,超图计算作为一种能够捕获多方关系的数学工具,正逐渐应用于包括社交网络、脑网络等复杂数据结构的分析。

超图涵盖了多种相关性,是复杂相关性计算的有效方法。在Hyper-YOLO中,作者首次将超图计算引入目标检测领域,实现视觉高阶语义关联的建模和学习。

模型效应

这项工作在 COCO 数据集上进行了丰富的实验。 Hyper-YOLOv1.1提供了三个规模版本(Tiny、Small、Medium),在对比实验中,它们都明显优于最新的YOLO模型。

其中,Tiny版本的平均精度(mAP)指标较同规模版本YOLOv8、YOLOv9、YOLO11分别提升了3.0%、2.0%、0.8%; Small版本的mAP指数与YOLOv8、YOLOv9、YOLO11的同规模版本进行了比较。版本分别增长3.1%、1.2%、1.0%。此外,对主干网络、内核大小、特征增强策略和超图构建策略的消融实验证明了该方法的先进性。

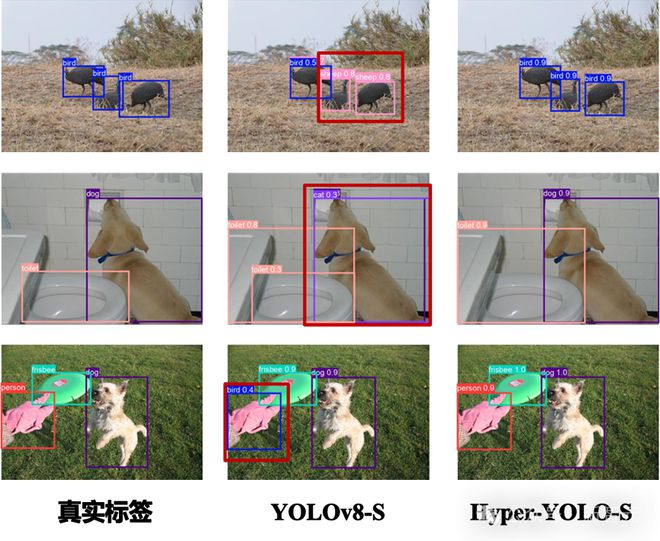

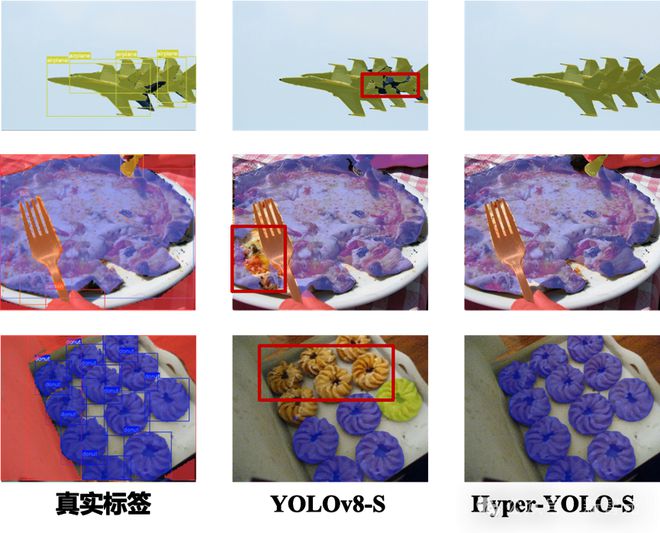

下面两张图分别展示了YOLOv8和Hyper-YOLO在目标检测和实例分割任务下的视觉结果。

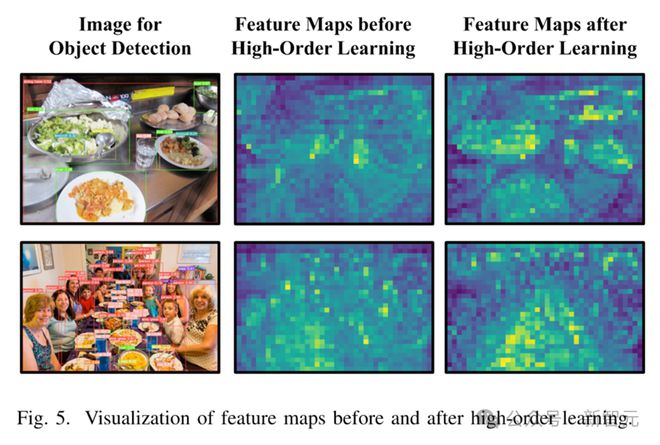

下图展示了使用高阶相关学习增强特征图前后的可视化效果(使用HyperC2Net前后的特征图)。

上述实验结果证明Hyper-YOLO具有目前最先进的检测性能,尤其是能够更准确地理解场景中不同视觉对象的高阶关系。

Hyper-YOLO零代码平台

智能媒体与认知实验室还推出了基于Hyper-YOLO的零代码训练平台。在这个平台上,不需要配置环境、修改配置文件等繁琐的操作。您可以一键上传图片,使用训练好的Hyper-YOLO模型进行推理,也可以上传数据集进行定制训练,直观展示训练过程。 (建议使用PC chrome/Edge浏览器)

项目链接:28501/#/predict

该项目支持定制培训。

训练完成后,您可以对验证数据进行推理和评估,并将检测结果可视化:

方法概述

超图计算

超图是图的广义形式,是一种高效的特征表示学习方法。在超图中,超边可以连接多个顶点,从而表示对象之间的高阶关系。超图神经网络作为超图计算的核心方法,通常包括以下步骤:

1. 从原始数据构建超边

2.从顶点到超边的消息聚合(超边卷积)

3.从超边到顶点的消息分发(节点卷积)

超图神经网络由于其灵活性和丰富的表达能力,广泛应用于社交网络分析、生物信息学、推荐系统等领域,可以更有效地对复杂的多层次数据关联进行建模和分析。

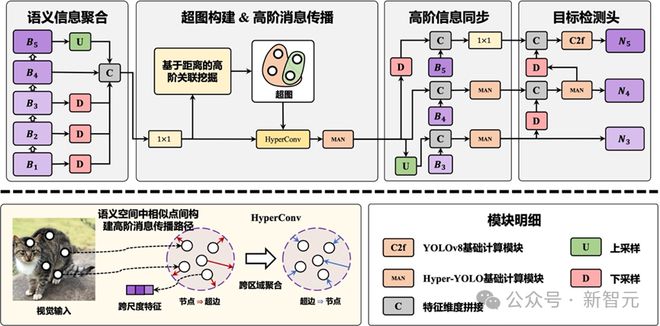

Hyper-YOLO整体架构

Hyper-YOLO继承了典型的YOLO架构。主干网络通过引入混合聚合网络(MANet)从五个特征层获取信息来增强特征提取能力。

颈部网络(Neck)采用基于超图的跨层级、跨位置表示网络(HyperC2Net),通过超图计算融合多尺度特征,实现高阶信息的跨层级、跨位置传播,从而生成适合目标检测的网络。语义特征显着提高了模型的检测性能。

基于超图的跨层跨位置表示网络

在传统的YOLO模型中,颈部是连接主干网络和预测头的部分。它通常采用类似于PANet的结构,承担多尺度特征提取和融合的功能。虽然这类结构可以进行一定的多尺度特征融合,但直接的信息交互仅限于相邻层。

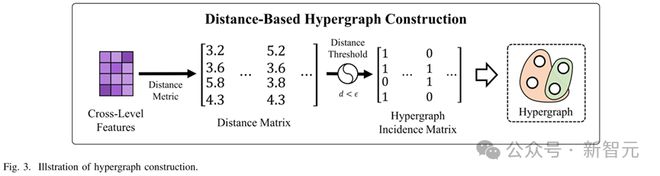

基于超图的跨级别和跨位置表示网络(Hypergraph-based Cross-Level and Cross-Position Representation Network,HyperC2Net)突破了这一瓶颈。主要流程如下:

1.超图构建:HyperC2Net将不同层级的特征图进行拼接,形成跨层级的视觉特征集。然后通过计算特征点之间的距离,构建超图,其中每个超边连接多个顶点,表示多个特征点之间的高阶关系。超图可以表达跨层次和位置的复杂关系,而不是相邻层信息的简单融合。

2. 超图卷积:构造超图后,HyperC2Net 使用超图卷积在特征图上传播消息。这样,不同位置和层次的特征点可以相互传递信息,对特征点之间的高阶相关性进行建模,增强模型识别复杂场景中目标的能力。特别是在跨位置特征交互方面,超图卷积可以捕获比传统卷积操作更广泛、更复杂的特征相关性。

总结

Hyper-YOLO通过引入超图计算方法,突破了传统YOLO模型在多尺度特征融合方面的局限性。超图的高阶关联建模能力使得HyperC2Net能够在跨层级、跨地点的信息传播中表现良好。它不仅实现了特征点之间的高效信息聚合和分发,而且通过跨级消息传递显着提高了目标。检测性能,特别是在复杂场景和多目标检测任务中。

参考:

[1] 冯Y,黄J,杜S,等。 Hyper-YOLO:当视觉目标检测遇上超图计算[J]. arXiv 预印本 arXiv:2408.04804, 2024。

[2] 冯勇,尤华,张志,等。超图神经网络[C]//AAAI人工智能会议论文集。 2019, 33(01): 3558-3565。

[3] 高Y,冯Y,季S,等。 HGNN+:通用超图神经网络[J]. IEEE 模式分析和机器智能汇刊,2022,45(3):3181-3199。