克劳德的替代版本,“能与GPT-4抗衡”,震惊硅谷的“国产之光”……2025年初,AI圈第一爆款就是DeepSeek,它诞生了来自一家量化公司。 DeepSeek能够以十分之一的价格和不足150人的研发团队与硅谷顶级机型竞争,其秘诀是什么?

当全球“AGI信仰”因技术放缓而面临挑战时,“AI六虎”的光芒开始黯淡,沉寂的大模型领域急需一个激动人心的新故事。

作为年初AI圈的第一爆款,DeepSeek的诞生,顶着“国产之光”的新冠,震惊了国内外众多科技巨头。

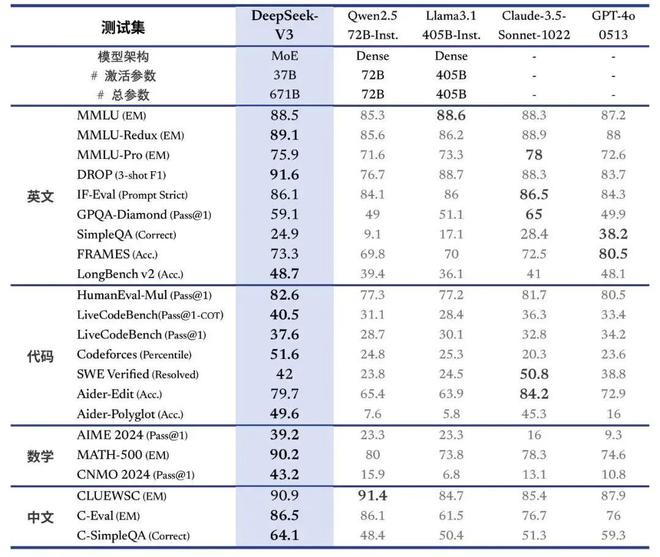

2024年12月,DeepSeek发布了最新的V3开源模型。评测结果不仅超越了Qwen2.5-72B(阿里巴巴自研大模型)、Llama 3.1-405B(meta自研大模型)等顶级开源模型,甚至可以与诸如GPT-4o和Claude 3.5-Sonnet(Anthropic自主开发的大型模型)。

更令人兴奋的是,DeepSeek的故事很大程度上打破了长期困扰国内大型模型的算力芯片限制的瓶颈。

V3模型在2000个NVIDIA H800 GPU(针对中国市场的低端GPU)上进行训练,而硅谷主要制造商的模型训练通常在数十万个更高性能的NVIDIA H100 GPU上运行。

这也让DeepSeek的训练成本大大降低。 SemiAnalysis数据显示,OpenAI GPT-4的训练成本高达6300万美元,而DeepSeek-V3的成本还不到其十分之一。

12月底,雷军开出千万年薪挖走DeepSeek研究员罗富利的消息也让更多人关注这个神秘团队。

据介绍,包括创始人梁文峰在内,DeepSeek仅有139名工程师和研究人员。相比之下,OpenAI 有 1,200 名研究人员,Anthropic 有 500 多名研究人员。

2024年,这家很少做营销、创始团队极其低调的公司,依然处于主流视野之外。第一次引起广泛关注是因为6个月前,DeepSeek首次发起大型机型价格战,被称为“AI行业的拼多多”。

如今,它已不寻求外部融资,其创始人被称为“囤卡大亨”,其团队全部是“清北等名牌大学的年轻人出品”——一系列引人注目的标签,让这个AI创业圈的隐形巨人更上一层楼。舞台前。

这一次,轮到 DeepSeek 讲述摆脱英伟达芯片束缚、实现技术平等的故事。

01.硅谷“出圈”

克劳德的替代版本、“能与GPT-4抗衡”、国内之光……2025年初最大的惊喜当属脱胎于量化公司的DeepSeek。

与大型模特公司的大规模投资,或者Kimi、豆宝等头部玩家仍在利用大量营销来获得C端用户的认可相比,DeepSeek的火爆让故事有了“顶流”。向下”的视角。一种说话方式。

2024年12月底,DeepSeek V3大模型发布后将完全开源。模型计算数据显示,DeepSeek V3虽然在文本生成任务上较弱,但其编码、逻辑推理和数学推理能力却名列前茅。

▲图片来源/DeepSeek官网

V3大模型推出后,DeepSeek还推出了一篇长达53页的论文,概述了模型的关键技术和训练细节。

论文披露:V3 的整个训练过程花费了不到 280 万个 GPU 小时。相比之下,Llama 3 405B 的训练时间为 3080 万 GPU 小时。考虑到V3训练芯片采用的是低端版本的H800 GPU,其训练成本也得到了显着降低。这也动摇了业界“大模型能力与芯片限制强相关”的普遍认知。

OpenAI创始团队成员Andrej Karpathy发帖称赞:DeepSeek-V3的性能比最强模型Llama3还要高,而且资源消耗仅为Llama3的十分之一。 “未来可能不需要超大规模的GPU集群。”

这也为长期受算力限制的创业团队提供了新的解决方案——即使算力有限,仍然可以使用高质量的数据和更好的算法来训练高性能的大型模型。

元科学家田元东感叹:“FP8预训练,MoE,在非常有限的预算下强大的性能,从CoT中提取出来进行引导......哇!这真是伟大的工作!”

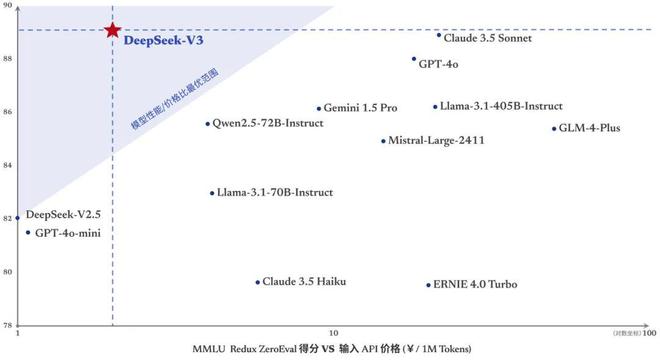

性能更强、速度更快的模型的推出也进一步降低了DeepSeek的API调用定价。近日,官方宣布DeepSeek的代币价格调整为每百万个输入代币0.5元(缓存命中)/2元(缓存未命中),每百万个输出代币8元。

▲图片来源/DeepSeek官网

V3的发布也引发了国内专业开发者社区的热烈讨论。不少AI应用层创业者和从业者称赞:“V3在国内已使用的大型模型中,编码能力最强”。

在应用到业务场景后,有AI从业者认为:“DeepSeek是目前国内唯一可以与4o、Sonnet看齐的LLM(大语言模型)。”

它可以从系统角度让模型变得越来越便宜,也为大型模型在卡量、算力、商业落地等方面日益焦灼的争夺战提供了新的解决方案。

02. 优先考虑有竞争力的学生和学术管理

那么,DeepSeek团队是怎样的人,能够打造出如此低成本、高质量的模型呢?

事实上,早在DeepSeek出世之前,AI行业就对其技术实力评价非常高。仅仅因为公司不融资、创始人很少露面、公司不做C端应用,公众认知度较弱。

从公开信息来看,DeepSeek团队最大的特点就是名校、年轻。一位大型模特领域的猎头告诉《财经天下》,目前所有“C9”院校的高端人才都在争夺。 “DeepSeek更注重宣传,这符合他们家族年轻、好奇的价值观。”

即使是团队领导级别,也大多年龄在35岁以下。猎头表示,DeepSeek管理职位内部晋升的情况很少,聘用的人大多是有经验的人,但也被困在自己的年龄里。 “我们这里推荐的几个领导职位,40岁以上的人并没有什么特别的优势,人们也不愿意看。”

DeepSeek创始人梁文峰在接受36氪采访时透露,招聘标准是:看能力,不看经验。核心技术岗位主要面向应届毕业生和毕业一两年前的人员。

衡量年轻毕业生是否“优秀”的标准不仅包括他们的院校,还包括他们的比赛成绩。 “基本金牌以下就不需要了。”

DeepSeek同样不青睐高级技术人员。例如DeepSeekMath的三位核心作者朱启豪、邵志红、王培毅在博士实习期间完成了相关研究工作。 V3研究员戴大麦于2024年刚刚获得北京大学博士学位。

在管理方面,DeepSeek采用极其扁平化的文化,淡化排名,团队规模保持在150人左右。用粗钱、粗卡、相当扁平化、“学院派”的管理方式留住人才。

梁文峰将这种组织形式描述为“自下而上”和“自然分工”:“每个人都有自己独特的成长经历,都有自己的想法,不需要去推动……当一个想法展现出潜力时,我们也会从上到下分配资源。”

“只招1%的天才,就能做99%中国企业做不到的事情。”面试过 DeepSeek 的应届毕业生评价了其招聘风格。

这种人才选拔和管理模式在某种程度上与OpenAI非常相似。两者都更像是纯粹的研究机构——前期没有融资,没有应用,更没有商业化的考虑。

随着AI大模型市场日趋饱和,DeepSeek成为国内为数不多的仍在招收“AGI信仰”人员的公司之一,因为它不争排名、不制造舆论、重用应届毕业生,专注底层技术优化。人才公司。

事实上,从DeepSeek成立之初,其履历就如同行业中的“异类”。

2023年,DeepSeek的AI产品将正式亮相。这几年,公司内部长期“孵化”产品,外部招揽文科人才。该职位被定位为“精通数据的学生”,提供历史、文化和科学等相关知识的来源。

DeepSeek的母公司是Magic Square Quantitative,由梁文峰于2015年创立,以量化基金起家。作为“80后”,梁文峰在浙江大学读本科和研究生,拥有信息与电子工程系本科和硕士学位。

魔方量化也是领先量化基金中的一个“例外”:大部分量化基金的创始团队都或多或少有海外对冲基金的经验。只有欢芳完全是从本地团队起步,独自成长——这也与 DeepSeek 的用人风格非常相似。

2017年,欢方量化声称实现了全面的基于人工智能的投资策略。 2019年基金管理规模突破100亿,成为国内量化私募“四大巨头”之一。也是国内第一家私募规模突破千亿的量化公司。

当魔方的量化规模稳步上升时,梁文峰开始转移目光。

在业界,汇芳一直以勇于投入硬件来支持其交易系统的实施而闻名。 2017年前后,梁文峰开始涉足AI相关探索,探索孵化AI项目“萤火虫”。 2018年,“萤火虫”超级计算机正式向外界亮相。据称,这台电脑占地几个篮球场,投资超过10亿元。

2021年,梁文峰参与的论文中提到,他们正在部署的萤火2系统“搭载1万颗A100 GPU芯片”,性能接近DGX-A100(人工智能专用超高速GPU)由 NVIDIA 推出)。级计算机),但成本降低一半,能耗降低40%。业界普遍认为1万颗Nvidia A100芯片是自训练大型模型的算力门槛。当时国内拥有1万颗以上GPU的公司还不到5家。

GPU芯片的丰富储备,也为魔方量化的下一步转型提供了基础。

2023年5月,梁文峰实际控制的人工智能研发机构北京“DeepSeek”成立,次年DeepSeek正式上线。从此,欢放量化也开始积极缩减基金规模,不再参与量化基金第一梯队的竞争。

2024年10月,欢放量化向投资者宣布,计划逐步将对冲产品的投资头寸降至零。公司部分避险产品规模已跌破1000万元。到2025年初,公司基金管理规模已不足300亿,已跌出行业前六名。

03. 最喜欢OpenAI的中国公司

从量化基金转型后,能够在短时间内成为领先的AI玩家。 DeepSeek 的“神奇”技术在其 53 页的论文中并不是秘密。

界面新闻报道称,V3模型主要采用了模型压缩、专家并行训练、FP8混合精度训练等一系列创新技术来降低成本。作为一种新兴的低精度训练方法,FP8技术通过减少数据表示所需的位数,显着降低了内存使用和计算要求。目前,Zero One Wish、Google、Inflection AI 等公司已将该技术引入到模型训练和推理中。

另外,在预训练阶段,对性能影响有限,DeepSeek选择了极限压缩。在训练后阶段,他们全力以赴改进模型擅长的领域。

核心人才还带来关键技术创新。 Qubit 报道称,在 2024 年 5 月发布的 DeepSeek-V2 中,其创造性地提出了“新型注意力”,用基于 Transformer 架构的 MLA(多头潜在注意力)取代了传统的多头注意力。功耗,大大减少计算量和推理内存。

其中,高华佐和曾旺鼎在MLA架构上做出了关键创新。目前仅知道高华佐是北京大学物理系的毕业生。这个名字也可以在“大模六小虎”之一的踏星的专利信息中看到。

DeepSeek-V2还涉及到另一个关键成果——GRPO。这是 PPO RL 算法的一种变体,可显着减少训练资源需求。 GRPO技术也体现在开源大模型阿里巴巴Qwen 2.5的技术报告中。

这些技术创新也为目前有些“尴尬”的国产大车型未来发展提供了新的解决问题的途径。

尤其是2024年下半年,长文本市场的竞争在字节的“饱和攻击”下逐渐尘埃落定。 AI圈有一个无奈的共识:在各大厂商的范围内,没有机会做出类似ChatGPT的产品,必须做出差异化。

大模型竞赛也进入了下一个更加艰巨的阶段,变成了一场资源的“战争”,包括资金、人才密度、数据计算能力等。

去年非常火的“大模特六小虎”正在加速寻找垂直场景的商业化机会。近日,MiniMax转战文盛视频,宣布与Sora展开竞争;智浦瞄准代理市场,从经营代理店到邀请PC端代理进行测试;百川智能逐步聚焦医疗市场;零一愿望随后宣布将深耕零售营销业务,不再追求AGI。

DeepSeek的突然袭击很大程度上是由于与大模型公司保持距离,远离融资的兴奋和商业化的压力。

梁文峰的几条评论中,他表示,在DeepSeek创立初期,他在接触投资圈后清楚地意识到,“很多VC对于做研究都有顾虑。他们有退出需求,希望尽快将产品商业化。根据我们的说法,如果你优先考虑研究,那么就很难从风投那里获得融资。”

他还向外界表示“短期内没有融资计划”,并认为目前的问题“不是钱,而是高端芯片(短缺)”。

梁文峰也明确表示,硅谷之所以对DeepSeek感到“惊讶”——“因为这是一家中国公司,以创新贡献者的身份加入他们的游戏。毕竟大多数中国公司习惯于跟随,而不是创新。” ” ”

“中国也必须逐渐成为贡献者,而不是永远搭便车。”梁文峰说道。 “我们已经习惯了摩尔定律从天而降,在国内只要18个月就会有更好的硬件和软件出来。缩放定律也是这样对待的。但事实上,这是一个由西方主导的科技界它是几代人孜孜不倦地创造出来的,只是因为我们以前没有参与过这个过程,所以我们忽略了它的存在。”

梁文峰认为,中国人工智能的发展也需要这样的生态系统。 “很多国产芯片无法发展,因为缺乏配套的技术社区,只有二手资料。中国肯定需要有人站在技术的最前沿。”

(作者|赵小天,编辑|李青)