有很多新的架构想要挑战Transformer,而来自Google的“正统”继承者Titan架构则引起了更多关注。

NVIDIA 将测试时计算称为大型模型的第三个缩放定律。

OpenAI 将其用于推理,Google 这次将其用于内存。

第一作者 Ali Behrouz 说:

Titan 比 Transformers 和现代线性 RNN 更高效,并且可以有效扩展到超过 200 万个上下文窗口,性能优于 GPT4 和 Llama3 等大型模型。

他还解释了这项研究的动机。该团队认为,Transformer 中的注意力机制表现为短期记忆,因此还需要一个能够记住很久以前的信息的神经记忆模块。

新型长期记忆模块

说到内存,你可能会想到LSTM、Transformer等经典模型。它们从不同角度模拟人脑记忆,但仍然存在局限性:

此外,仅仅记住训练数据可能对实际使用没有帮助,因为测试数据可能在分布之外。

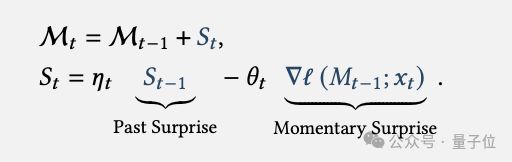

为此,泰坦团队的目标是将过去的信息编码到神经网络的参数中,训练一个在线元模型,该模型学习如何在测试时记住/忘记特定数据。

他们从神经心理学中汲取灵感,设计了一种借鉴人脑原理的神经长期记忆模块:

这种在线元学习范式可以防止模型记住无用的训练数据细节,而是学习如何根据新数据进行自我调整,并具有更好的泛化能力。

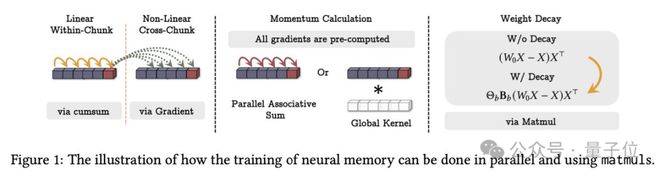

此外,团队还验证了该模块可以并行计算。

如何将这个强大的内存模块集成到深度学习架构中?

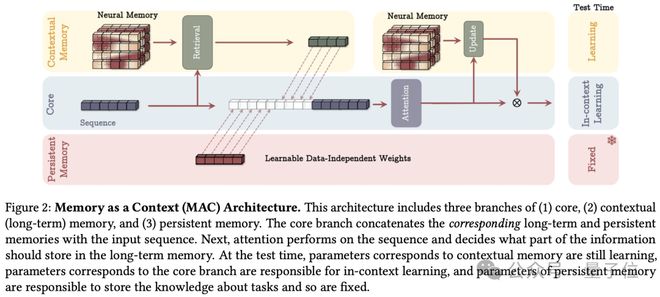

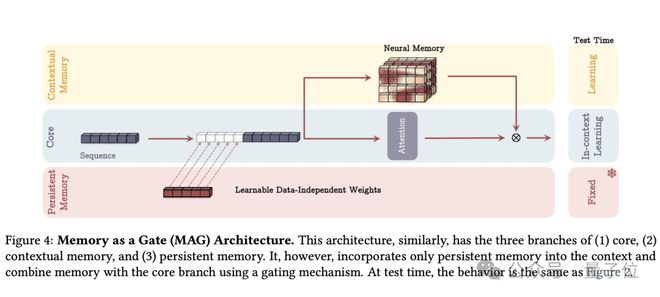

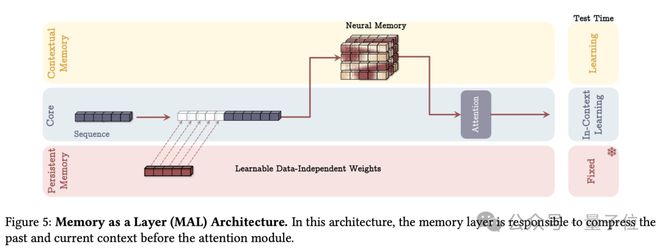

为此,泰坦提出了三种变体:

MAC,内存作为上下文

长期记忆和持久记忆(编码任务知识的不变参数)作为当前输入的上下文,一起输入注意力。

MAG,内存作为门

在记忆模块和滑动窗口注意力的两个分支上进行门控融合。

MAL,内存作为层

记忆模块作为一个独立的层来压缩历史信息,然后输入到attention中。

在实验中,发现每种方法都有自己的优点和缺点。

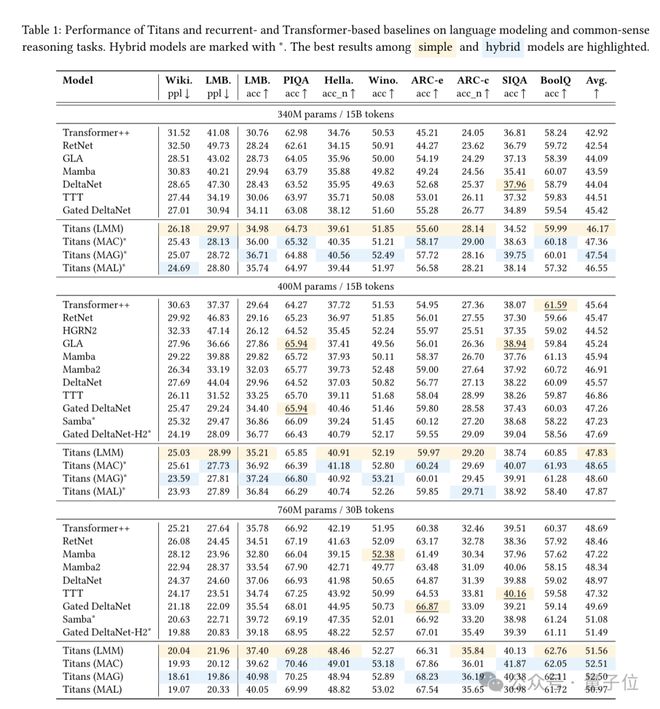

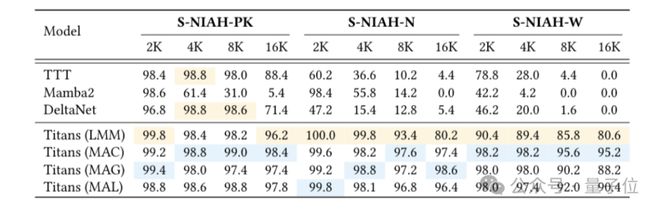

Titans 在语言建模、常识推理、时间序列预测等任务上全面超越 Transformer、Mamba 等各种架构的 SOTA 模型。

并且仅仅依靠长期记忆模块(LMM,Long-term Memory Module)本身,它就在多项任务上击败了基线。

证明即使没有短期记忆(即Attention),这种机制也具有独立学习的能力。

在长文本中寻找细粒度线索的“大海捞针”测试中,序列长度从2k增加到16k,准确率保持在90%左右。

不过,团队认为这些通用测试已经无法体现泰坦在长文本方面的优势。

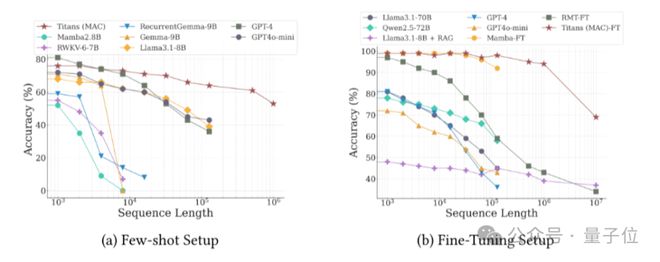

在另一项需要对极长文档中分布的事实进行推理的任务中,Titans 的性能优于 GPT4、Mamba 和 Llama3.1 + RAG 等系统。

此外,Titans 在时间序列预测、DNA 序列建模等特定任务中也取得了良好的表现。

这三位作者来自 Google Research NYC 算法和优化团队,尚未并入 Google DeepMind。

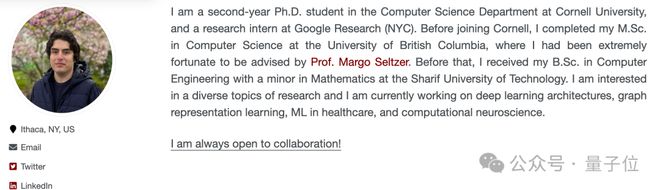

其中之一是康奈尔大学的实习生阿里·贝鲁兹 (Ali Behrouz)。

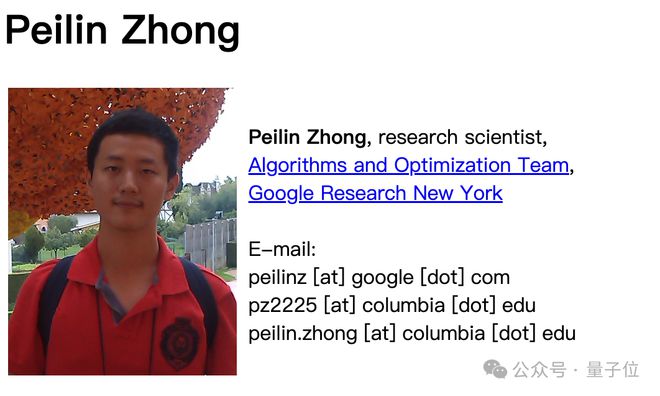

钟培林是清华大学姚班校友,毕业于哥伦比亚大学,获博士学位。他将于 2021 年加入 Google,担任研究科学家。

2016年,钟培林本科期间的第一篇论文被顶级会议STOC 2016接收,这是中国本科生首次在STOC上发表第一篇论文。

团队负责人 Vahab Mirrokni 是 Google Fellow 兼副总裁。

该团队表示,Titians 是在 Pytorch 和 Jax 中实现的,并计划很快提供用于训练和评估模型的代码。

论文地址:

参考链接:

[1]