IT之家1月15日报道 IT之家从上海人工智能实验室获悉,其学者模型今日迎来重要版本升级——学者璞玉3.0(InternLM3)。据官方介绍,通过细化数据框架,极大提升了数据效率,实现了思维密度的跃升。

InternLM3-8B-Instruct仅使用4T数据进行训练。官方宣称其综合性能超过同量级的开源模型,节省75%以上的训练成本;首次实现了常规对话与深度思考能力在通用模型中的融合,可以应对更多现实生活场景。使用场景。

05ad2c6ab02ec773137c514eb0b81a13

f5aae20b96d17928dc3e33028984cb25

模型研究团队基于思南OpenCompass开源评估框架,采用统一、可重复的方法对模型进行评估。评估采用CMMLU、GPQA等十余个权威评估集。维度包括推理、数学、编程、跟随指令、长文、对话和综合表现。结果显示,Scholar Puyu 3.0 在大多数评估集中得分。领先,整体性能“非常接近GPT-4o-mini”。

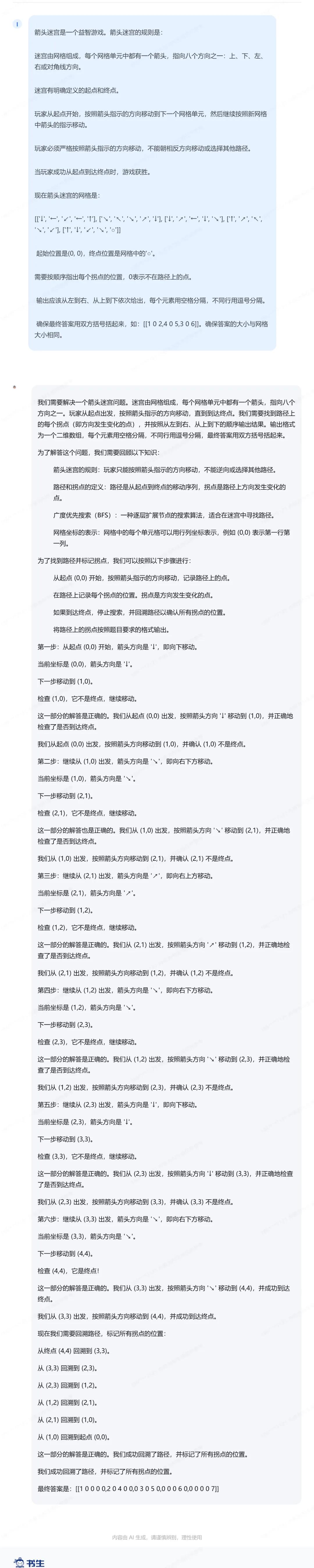

上海人工智能实验室公开了该模型的一些经验案例,比如解决“箭头迷宫问题”等推理难题,让模型在棋盘上找到一条从起点到终点的可行路径。

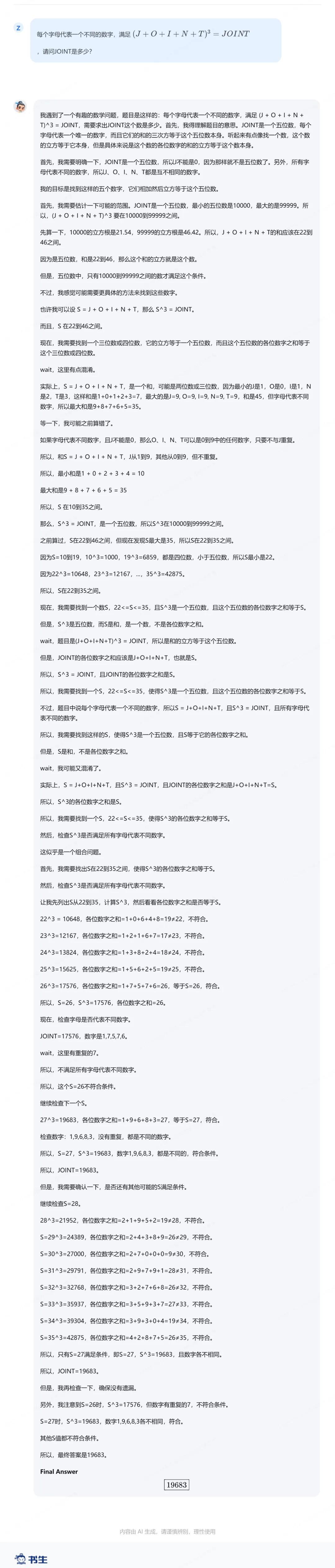

还有“猜数字”问题:

此外,其深度思考能力也延伸至代理任务,成为开源社区第一个支持浏览器使用的通用对话模型,并支持20多步网页跳转完成深度信息挖掘。