心脏报告

心编辑部

“工程师们正在疯狂地分析 Deepseek,试图从中复制任何可能的东西。”

Deepseek的Yangmou这种开源模式着实震惊了美国AI公司。

最先惊慌的似乎是同样尊重开源的meta。

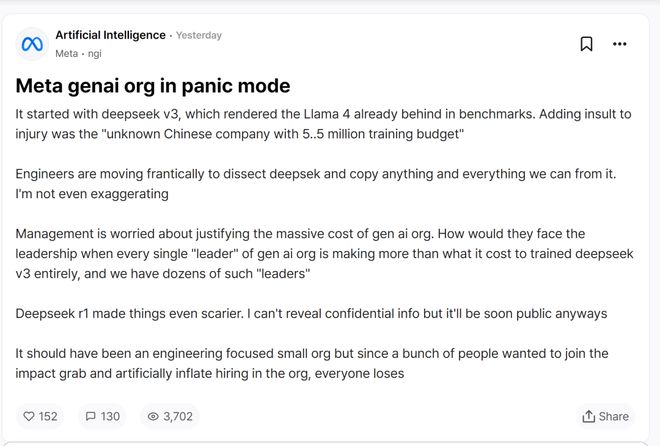

近日,meta员工在美国匿名职场社区TeamBlind上发布了一条帖子。帖子中提到,近期国内AI初创公司DeepSeek的一系列举动让meta的生成式AI团队陷入了恐慌,因为前者的低成本唱衰,后者无法解释其超高预算的合理性。

原文如下:

这一切都始于 DeepSeek-V3,它在基准测试中落后于 LLAMA 4。更糟糕的是“拥有550万培训预算的不知名中国公司”。

工程师们正在疯狂地分析 DeepSeek,试图从中复制任何可能的东西。这并不夸张。

管理层关心的是如何证明庞大的一代AI组织的成本是合理的。当一代AI组织中每个“领导者”的薪资都高于训练整个Deepseek-V3的成本时,而我们有几十个这样的“领导者”,他们如何面对高层?

DeepSeek-R1让情况变得更加可怕。虽然我不能透露机密信息,但这些很快就会公开。

这本来应该是一个以工程为主的小组织,却因为很多人想参与分享,人为地扩大了组织的招募规模。结果,每个人都成为失败者。

原链接链接:

帖子中提到的Deepseek-V3和Deepseek-R1分别发布于2024年12月26日和2025年1月20日。

其中,DeepSeek-V3提到该模型在多项评测结果上超过了Qwen2.5-72B和LLAMA-3.1-405B等其他开源模型,并且在性能方面与全球顶级闭源模型GPT-4O和Claude相媲美-3.5-十四行诗不管博仲。

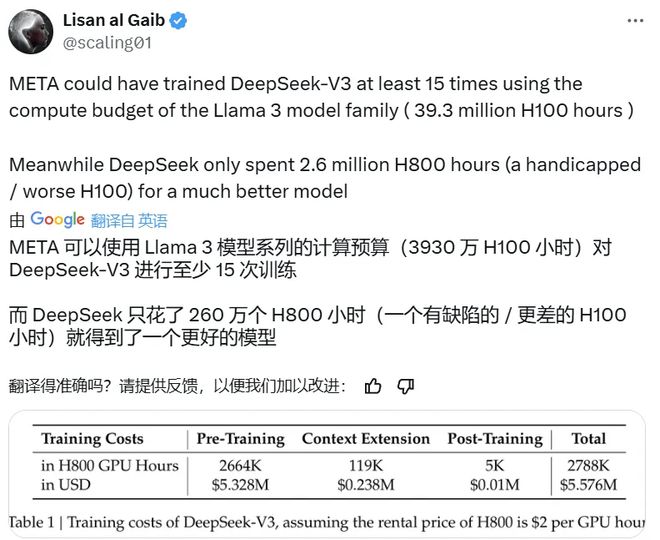

然而,更值得注意的是,671B数量为671B的大规模语言模型的成本仅为558万美元。具体来说,其预训练过程仅使用了266.4万H800 GPU HOURS,加上上下文扩展和后训练的训练,仅使用了278.8 H800 GPU HOURS。相比之下,meta 的 LLAMA 3 系列模型的计算预算高达 3930 万 H100 GPU Hours——这个计算量至少可以训练 15 次来训练 Deepseek-V3。

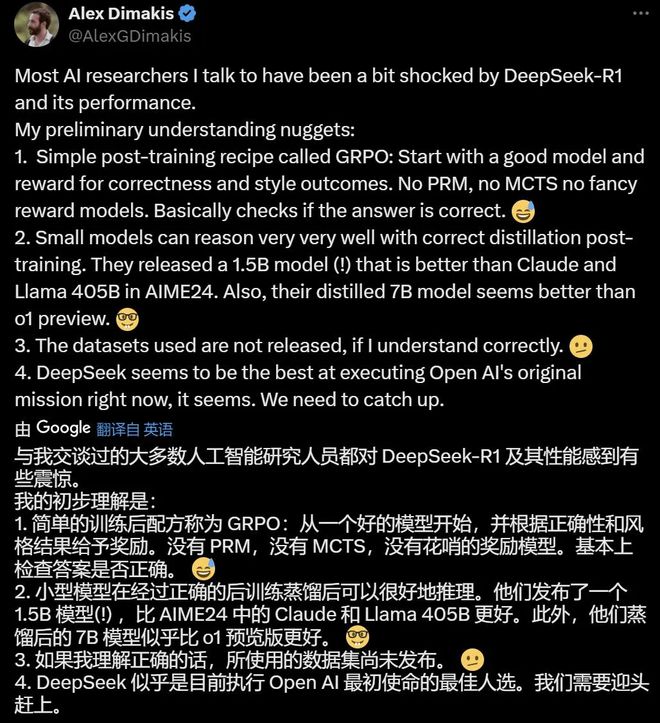

最近发布的DeepSeek-R1性能更加猛烈——在数学、代码、自然语言推理等任务中,其性能官方与Openai O1正式版进行了对比。模型发布的同时,权重也同时开源。很多人惊呼DeepSeek才是真正的OpenAI。加州大学伯克利分校教授Alex Dimakis认为,Deepseek现在处于领先地位,美国公司可能需要迎头赶上。

看到这里,就不难理解meta团队为何惊慌了。如果说今年推出的 LLAMA 4 不是有点辛苦的话,他们的“开源之光”地位就岌岌可危了。

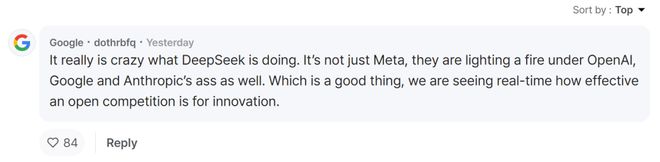

有人指出,其实不仅仅是meta、Openai、Google、Anthropic。 “这是一件好事,我们可以实时看到公共竞争对创新的影响。”

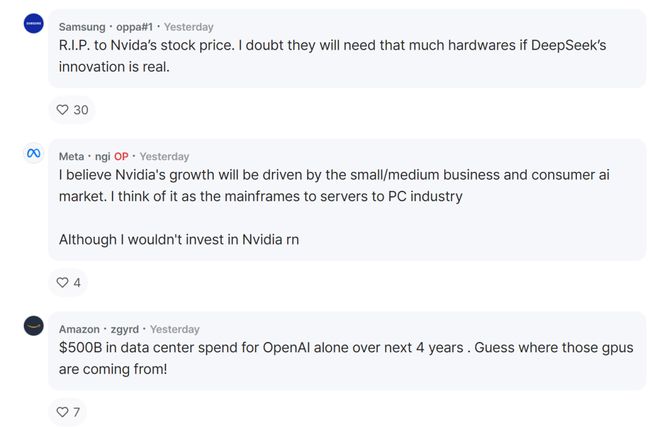

有人担心Nvidia的股价,称“如果Deeseek的创新属实,那么AI公司真的需要这么多显卡吗?”

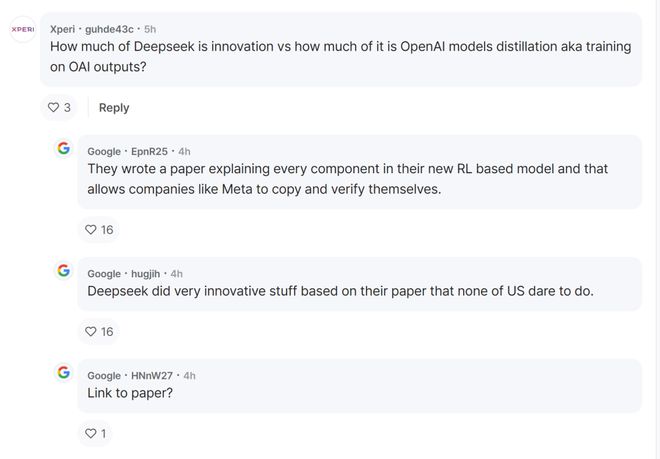

不过,也有人质疑Deepseek到底是创新还是由OPENAI模型提炼出来的?有人回复说,这可以从他们发布的技术报告中找到答案。

目前,我们无法确定该帖子的真实性。

不知道未来meta会如何应对,以及即将到来的LLAMA 4会有怎样的表现。