IT House在1月27日报告说,阿里巴巴·汤蒂·齐旺(Alibaba Tongyi Qianwen)今天宣布,它已正式推出了开源QWEN2.5-1M型号及其相应的推理框架支持。

It House从官方的介绍中学到,Tongyi Qianwen发布了两个新的开源模型,分别是Qwen2.5-7B-Instruct-1M和Qwen2.5-14B-Instruct-1M。 Q首次将开源QWEN模型的上下文扩展到1m长度。

为了更有效地帮助开发人员部署QWEN2.5-1M系列模型,QWEN团队完全开放了基于VLLM的推理框架并集成了稀疏注意方法,该方法在处理1M标记输入时将框架的速度提高了3次。到7次。

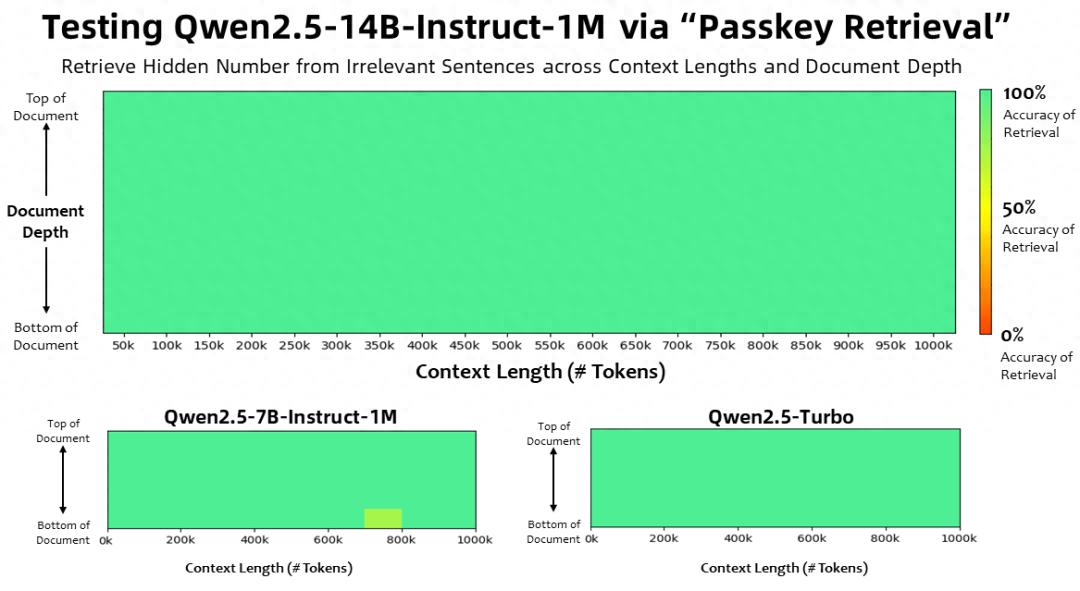

在Passkey检索任务中,上下文长度为100万个令牌,QWEN2.5-1M系列模型可以准确地从1m长度的文档中检索隐藏的信息,只有7B型号造成了一些错误。

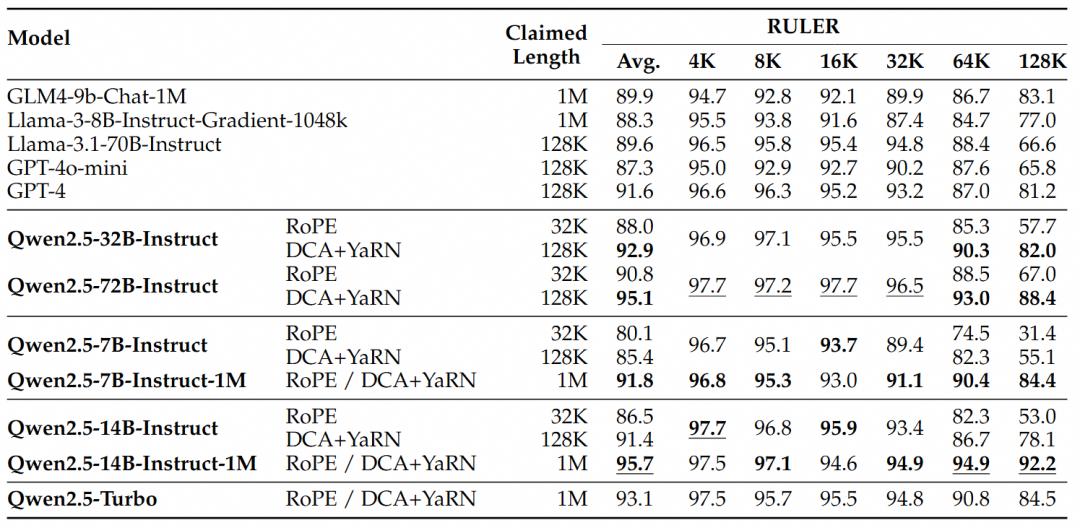

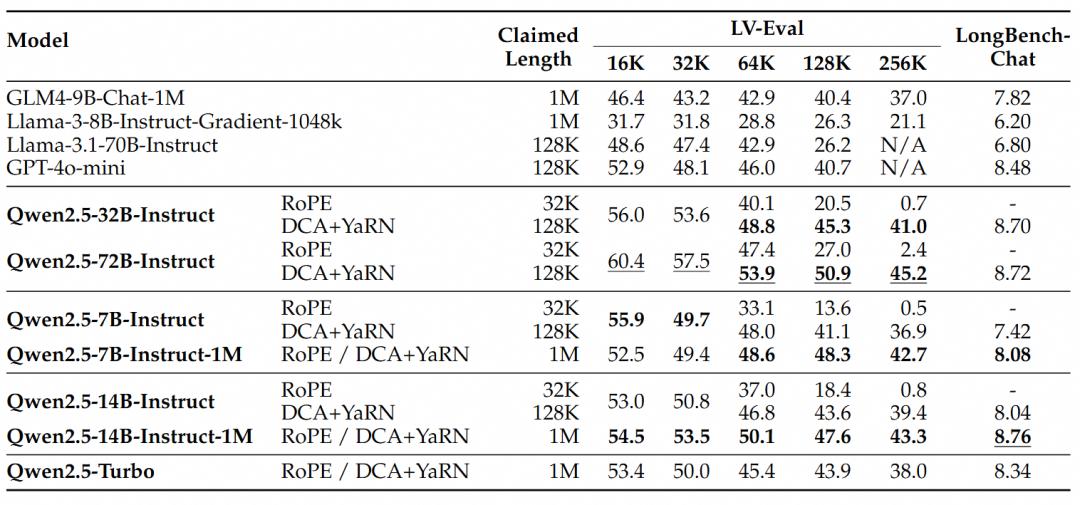

为了了解更复杂的长篇小说理解任务,选择了标尺,LV-eval和Longbenchchat测试集。

从这些结果中,Qwen得出了以下关键结论:

在大多数漫长的上下文任务中,QWEN2.5-1M系列模型的表现明显优于128K版本:QWEN2.5-1M系列模型的表现明显优于前128K版本,尤其是当处理任务的长度超过64K时。

性能优势很明显:QWEN2.5-14B-Instruct-1M模型不仅击败了Qwen2.5-Turbo,而且在多个数据集上稳定超过了GPT-4O-Mini,为长上下文任务提供了开源模型选择。

可以找到:

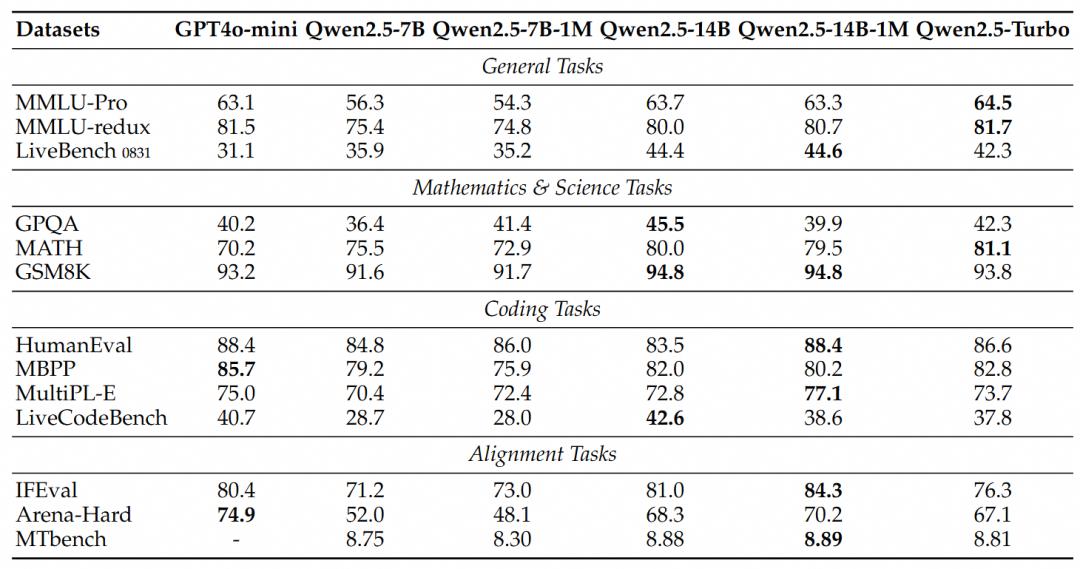

QWEN2.5-7B-INSTRUCT-1M和QWEN2.5-14B-INSTRUCT-1M在短文本任务上的性能等效于其128K版本,以确保不受长序处理能力的添加不受基本功能的影响。

与GPT-4O-MINI,QWEN2.5-14B-INSTRUCT-1M和QWEN2.5-TURBO相比,在短文本任务上具有相似的性能,而上下文长度是GPT-4O-MINI的八倍。