“当我们所有人都在圣诞节时,一个中国实验室发布了震惊世界的AI模型。这显然是象征性的。长期以来,美国一直在AI竞赛中处于世界领先地位,但是DeepSeek的最新模型,但它正在改变此模式。

在短短半个月内,中国实验室发布的AI模型使用了令人难以置信的强度数据来震惊整个硅谷AI场。从技术巨头到AI的贵族再到技术专家,几乎每个人都对中国人工智能行业产生了强烈的影响。更令人震惊的是,当出口控制和计算能力稀缺时,中国人工智能行业已经实现了曲线。

生于空中

该实验室是来自中国的DeepSeek,该实验室刚刚成立于2023年。他们在去年年底发布了免费的开源大型语言模型。根据该公司发表的论文,DeepSeek-R1在多种数学和合理的基准测试中超过了该行业的领先模型和其他模型,并且在绩效,成本和开放性方面使美国AI巨人队不堪重负。

技术行业需要与数据交谈。在一系列的第三方基准测试中,DeepSeek模型超过了meta的Llama 3.1,OpenAI的GPT-4O和人为的Claudesonnet 3.5,以解决数学和编程的复杂问题的准确性。

就在上周,DeepSeek发布了推理Model R1,该Model R1也超过了Openai在许多第三款测试中的最新O1。在AIME 2024数学基准测试中,DeepSeekr1取得了79.8%的成功率,超过了OpenAI O1推理模型。在标准化的编码测试中,它显示了“专家级别”的性能,并在Codeforcess上获得了2,029 ELO得分,占人类竞争对手的96.3%。

Scaleai使用“人类检查”测试大型AI模型。它使用了涉及最新研究结果的数学,物理,生物学和化学教授提供的“最困难的问题”。在测试了所有最新的AI模型之后,亚历山大·王(Alexander Wang)不得不欣赏DeepSeek的最新模型“实际上是最佳性能,或者至少与最好的美国模型(例如O1)相当。”

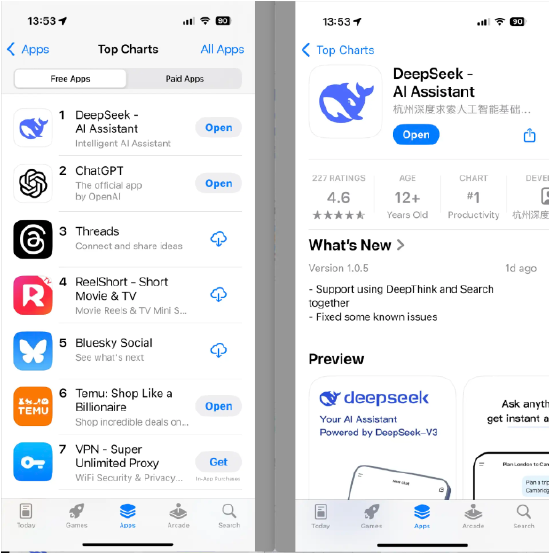

毫不夸张地说,DeepSeek触发了美国AI行业的地震,甚至引发了媒体的报告。几乎所有主流媒体和技术媒体都报道说,中国人工智能模型超过了美国的爆炸。在短短几天内,DeepSeek已成为Apple App Store中排名第一的免费应用程序,并按下Openai Chatgpt。

性能成本令人震惊的巨人

真正的测试比较结果必须说服。几乎所有的AI巨人,风险投资和技术人员只能承认,在大型模型领域,DeepSeek至少可以与Openai一起放置,而中国已经赶上了美国。

微软首席执行官Satyanadella在世界经济论坛的世界经济经济论坛上说:“ DeepSeek的新模型令人印象深刻。他们不仅有效地建立了开源模型,而且可以建立开源模型它是有效的,并且在计算效率方面表现良好。

中国的人工智能不仅表现出色,而且在经济上也是如此。是什么使许多AI巨人在硅谷冲击中,并为DeepSeek的低成本感到羞耻。 R1型号的查询成本仅为每百万美元0.14美元,而OpenAI的成本为7.50美元,将其成本降低了98%。

它确实是小米加步枪。 DeepSeek只花了两个月的时间,而创建大型语言R1的消耗不到600万美元,并且他们仍然使用了NVIDIAN H800芯片的性能较弱。这意味着什么?例如,中国人工智能公司实际上驱动了普通汽车以实现曲线的超越,超过了硅谷巨人队在比赛中的超级跑车。

除了低训练成本外,DeepSeek的团队组成也与硅谷的许多AI巨人也有很大不同。当Liang Wenfeng是DeepSeek的创始人时,当他组建研究团队时,他并没有寻找经验丰富的高级软件工程师。取而代之的是,他专注于北京大学和Tsinghua大学等顶尖大学的博士生。许多人在顶级学术期刊上发表了论文,并在国际学术会议上获得了奖项,但缺乏行业经验。

Liang Wenfeng在2023年接受媒体采访时说:“我们的核心技术职位主要由今年或过去一两年毕业的人担任。”这种招聘策略有助于建立免费的合作公司文化。研究人员可以使用足够的计算资源来执行折衷的研究项目。这与传统的中国互联网公司形成鲜明对比。在后者中,团队通常对资源战斗很猛烈。

没有顶级GPU,没有高级AI才能,没有高昂的运营成本,您也可以提出最好的大型型号。关于DeepSeek的一切使Silicon Valley AI巨人沮丧。

硅谷巨人很沮丧

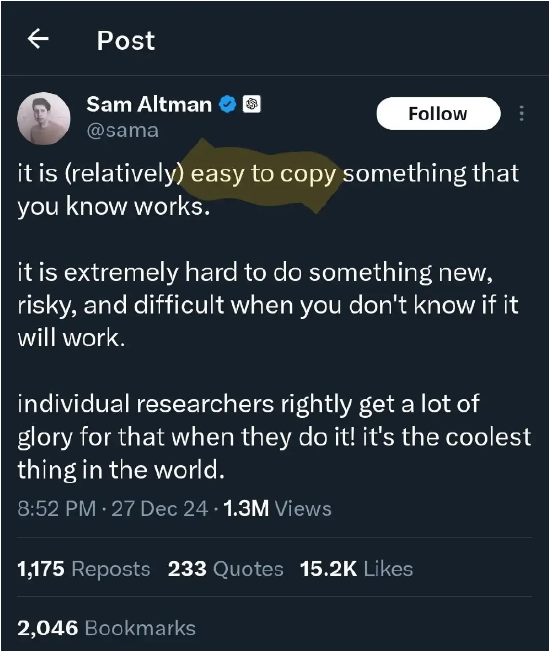

具有挑战性的巨人如何看待DeepSeek? Openai的创始人兼首席执行官对Samaltman的声明使人们感到有些酸。他在社交媒体上说:“复制有效的解决方案相对容易,但是探索未知领域充满了挑战。”这句话被广泛解释为DeepSeek的隐藏讽刺,这意味着中国人工智能模型缺乏真正的创新,只是复制现有的有效方法。

AI的困惑AI首席执行官Arvind Srinivas(印第安人)从市场影响的角度研究了这一发布:“ DeepSeek在很大程度上复制了Openai O1 Mini。”但是他还赞扬了Deepseek的快速节奏:“看到推理如此之快,这有点疯狂。”他说,他的团队将把DeepSeek R1的推理能力介绍给困惑。

稳定AI的创始人Emad Mostaque暗示,DeepSeek释放给更多的资金给足够的资金带来了压力:“您能想象一个切割的边缘实验室,筹集了10亿美元的10亿美元,并且无法释放其最新模式,因为它无法击败DeeldSeek? ”“”

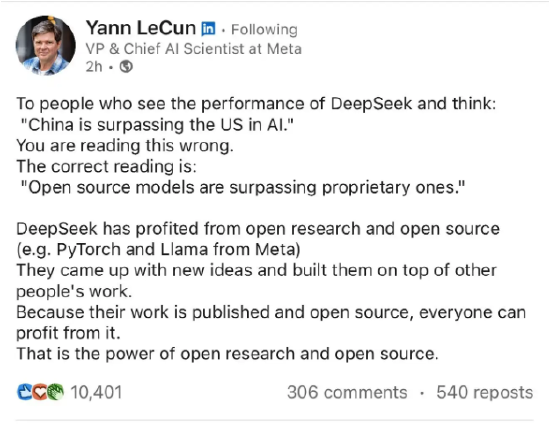

metaai首席科学家Yang Likun(Yann

法国莱肯(Lecun)强调,中国人已经取得了依靠开源的优势。尽管他对DeepSeek的成功表示赞赏,但他强调,DeepSeek的成功并不意味着中国在AI领域超过了美国,而是证明开源模型超出了封闭的源系统。

Yang Likun说,DeepSeek从开源研究和开源代码中受益匪浅。他们提出了新的想法并根据他人的工作进行创新。因为他们的工作是开放和开放的,所以每个人都可以从中受益。这反映了开源研究和开源代码的力量。他认为,DeepSeek成功撤回开源生态系统在促进AI技术进步方面的重要性表明,通过共享和协作,开源模型可以实现快速的创新和开发。

但是,梅塔内心不是那么平静。在过去的几天中,元员工在工作场所匿名平台Temblind上发表了一篇文章。该帖子说,由于DeepSeek模型,它现在进入了恐慌模式,这不仅是因为DeepSeek的出色表现,而且还因为成本极低和团队组成。

“一切都是因为DeepSeek-V3的诞生。它使Llama 4在基准测试中夹住了。更令人尴尬的是,这仅有550万美元的培训预算。现在,元工程师现在强调了这一点在一场比赛中,试图复制其中的所有可能的技术。

高效率算法曲线超过

那么,DeepSeek如何实现曲线超过?在明显的计算能力的情况下,成本仅为零,创建了一个与硅谷AI巨头相当甚至超过硅谷巨头的大型模型?

美国的出口控制严重限制了中国技术公司,以“西部风格”的方法参加人工智能竞争,即通过无限的扩展筹码购买并延长培训时间。因此,大多数中国公司都会专注于下游应用程序,而不是自行制造的模型。但是,DeepSeek的最新版本证明,赢的另一条道路是重塑AI模型的基础设施,并更有效地使用有限的资源。

由于缺乏计算能力资源,DeepSeek必须开发更有效的培训方法。 “他们通过一系列包括定制芯片的工程技术来优化模型架构,从而减小了场的大小以节省内存,并使用Experts方法的混合物进行创新。”软件工程师Wendychang说。 “这些方法中的许多不是新鲜的,但是将它们与切割模型成功整合在一起是一项巨大的成就。”

DeepSeek还在“多头 - 刺伦特概要(MLA)和“专家混合模型”的重大进展中取得了进步。这些技术使DeepSeek模型更具成本效益。培训所需的计算资源远低于竞争远小于竞争。对手。对手。事实,根据研究机构Epochai的说法,DeepSeek的最新模型仅使用metallama 3.1计算资源模型。

中国人工智能研究人员已经取得了许多人认为无法触及的成就:一种免费的开源AI模型,其性能可以与OpenAI最先进的推理系统相媲美。更明显的是它们的实施方式:让AI通过反复试验学习和错误,类似于人类学习方法。

研究论文说:“ DeepSeek-R1-Zero是一种通过大规模增强学习(RL)培训的模型。它不需要监督微调(SFT)作为初步步骤,显示出卓越的推理能力。”

“加强学习”是一种方法。在做出正确的决定时,该模型会得到奖励,并且在犯错误时会受到惩罚,并且您不需要知道哪一个。经过一系列决定,它将学会遵循这些结果加强的路径。

DeepSeek R1是AI发展的转折点,因为人类参与培训的最少。与其他经过大量监督数据培训的模型不同,DeepSeek R1主要是通过机械加固学习学习 - 基本上是通过实验和反馈来解决问题。该模型在没有明确编程的情况下开发了复杂的功能,例如自我验证和反思。

通过模型经验的培训过程,它自然会学会为复杂问题分配更多的“思考时间”,并发展捕获自己的错误的能力。研究人员强调了一个“顿悟时刻”,该模型学会了重新评估其最初的问题解决方法 - 这是尚未明确编程的。

开源模型得到广泛赞赏

值得一提的是,DeepSeek愿意为创新的结果开源,以便在全球AI研究界获得更大的赞赏。与专有模型不同,DeepSeekr1的代码和培训方法在MIT许可下完全是开源的,这意味着任何人都可以在没有任何限制的情况下获得,使用和修改模型。

对于许多中国人工智能公司而言,开源模型的开发是赶上西方竞争对手的唯一方法,因为这可以吸引更多的用户和贡献者来帮助该模型成长。在Openai逐渐关闭的那一刻,DeepSeek的开源被AI从业者称赞。

NVIDIA的高级研究员Jimfan博士称赞DeepSeek的前所未有的透明度,并将其直接与OpenAI的原始任务进行了比较。范金指出:“我们生活在一家非美国公司的时间表上,以维护Openai -Truly Open和Cutch -Edge Research的原始任务,并赋予所有人权力。”

范金指出了DeepSeek增强学习方法的重要性:“它们可能是第一个展示[加强学习]飞轮的开源软件项目。”他还赞扬DeepSeek直接分享“原始算法和Matplotlib学习曲线”,以及以及Matplotlib学习曲线的时刻,以及“不是更常见的推测驱动因素。

遵循相同的推理,但有了更严重的论点,技术企业家Arnaud Bertrand解释说,竞争性开源模型的出现可能会影响OpenAI,从而损害OpenAI的商业模式。 “这基本上就像有人发布了一部相当于iPhone的手机,但价格为30美元,而不是1,000美元。这是戏剧性的。”

出口控制面临挑战

对于Nvidia而言,DeepSeek的诞生是一个鲜明的因素。 AI行业中的许多人都不禁开始考虑另一个问题:因为DeepSeek可以通过一代筹码的custatration版本训练最强的模型,因此技术巨头仍然需要继续赚钱才能购买NVIDIA的最新GPU?这个问题非常可怕。

众所周知,由于美国政府的AI芯片已开始使用,因此中国不能购买NVIDIA最高的性能AI芯片,而H800是高计算A100芯片的cast割版本。与A100相比,H800的核心数量,频率和视频记忆显着较低。计算能力的下降在10-30%之间。它主要不需要顶级计算能力场景,例如中型AI培训和推理任务。 H800的内存带宽限制为1.5 TB/s,而A100 80GB版本可以达到2 TB/s,这将直接影响数据处理功能,尤其是在深度学习任务中。

Scaleai的亚历山大·王(Alexander Wang)坚持认为,DeepSeek的芯片数量可能远高于外界。他公开表示,他认为DeepSeek至少有50,000 h100,他们不会宣布具体数字。

H100的计算能力是A100的6至7倍。最高的GPU起价为30,000美元,也是硅谷技术巨头的武器。 meta和Microsoft都购买了150,000 H100。 Google,Oracle和Amazon都购买了50,000元人民币。马斯克(Musk)的XAI还部署了一个由100,000 H100组成的超级计算机群集,以训练主要的预测模型GROK3。

亚历山大·王(Alexander Wang)进一步指出,中国人工智能行业将来可能面临更多挑战。 “将来,它们将受到我们实施的芯片和出口控件的限制,很难获得更多的芯片。”上周他上周在华盛顿邮报。我买了整个广告的版本,并写道:“美国必须赢得这场AI战争!”

大量信息和准确的解释,全部在Sina Finance应用程序中