它在1月30日收录了新闻,人工智能正在加速边缘计算的开发,而副驾驶+ PC在其中发挥了重要作用。当DeepSeek R1出现时,微软还意识到该模型可能会带来一系列更改。

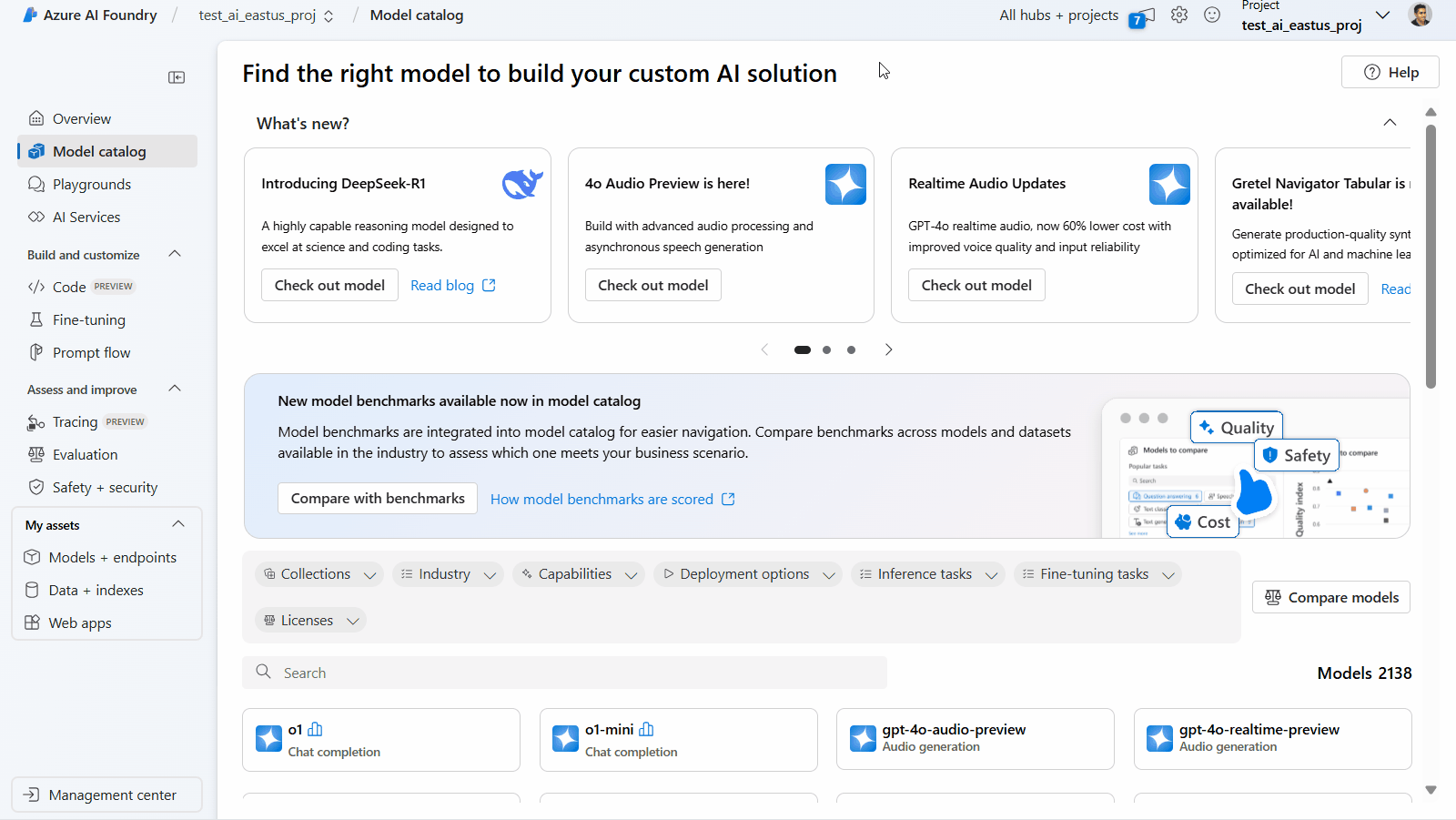

Microsoft今天发布,宣布启动DeepSeek-R1优化的NPU(IT House Note:在Azure AI Foundry和Github上提供)。第一个批次将针对Copilot+ PC启动,配备了高通Snapdragon X芯片的Copilot+ PC可用。 200V和其他平台。

微软表示,AI Toolkit中将提供DeepSeek-R1-Distill-Qwen-1.5b的第一个版本,并且7B和14B版本也将很快启动,这可以帮助开发人员充分利用副脉+ PC中功能强大的NPU配置。

微软表示,副驾驶+ PC上的NPU开了一个新的范式。在此范式下,AI一代不仅可以在被调用时执行,还可以支持半连续的运行服务。这使开发人员可以使用AI推理引擎来建立积极而连续的体验。微软说:

通过我们在Phi Silica上的工作,我们实现了有效的推理 - 它在第一个令牌的时间和吞吐量方面表现良好,与此同时,对电池寿命和PC资源消耗的影响最小化至最小值。由NPU优化的DeepSeek模型借用了项目的许多关键体验和技术,包括如何分离模型以达到最佳的性能和效率平衡,量化低比特率,并将变压器映射到NPU。此外,我们还使用Windows Copilot Runtime(WCR)通过onNX QDQ格式在不同的Windows生态系统中展开。

微软表示,如果您想在Copilot+ PC上体验DeepSeek,则只需要下载AI Toolkit vs Code扩展名。在ONX QDQ格式中优化的DeepSeek模型将很快出现在AI Toolkit的模型目录中(直接从Azure AI Foundry到。

用户可以通过单击“下载”按钮将其下载到本地。下载后,只需打开操场并加载“ DeepSeek_R1_1_5”型号,并给出一个及时的词以开始实验。

除了针对Copilot+ PC优化的ONX模型外,您还可以通过单击“ DeepSeek R1”下的“尝试操纵性”按钮来尝试云托管的源模型。

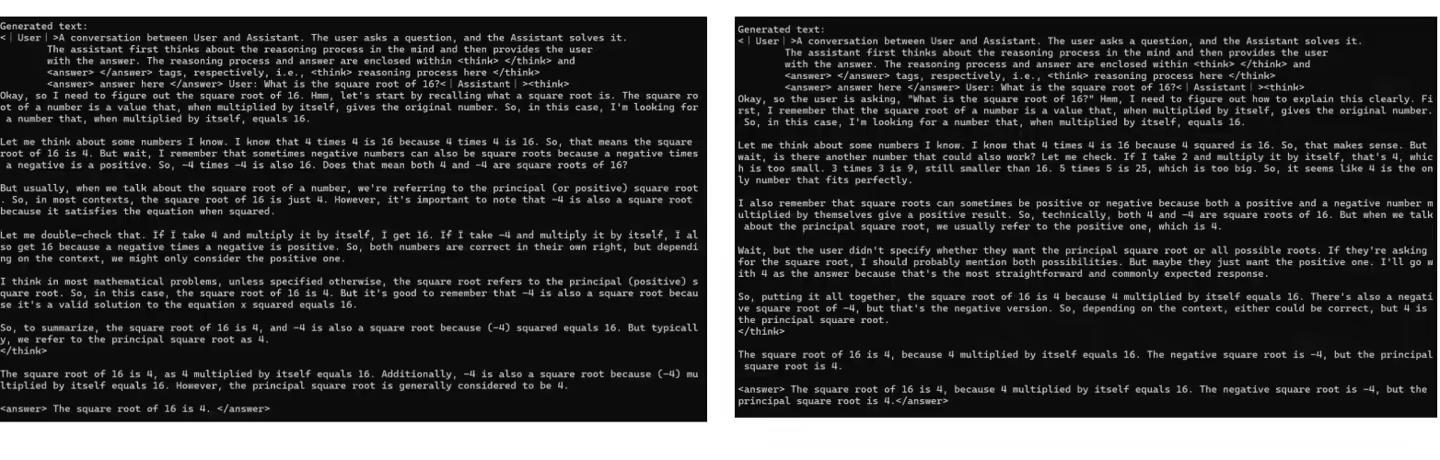

如下图所示,微软还显示了原始模型和定量模型的示例,以显示两者之间的微小但真实的差异:

▲在相同的提示下的原始模型(左)和NPU优化模型(右)的响应示例中,包括模型的派生能力