如果AI系统达到意识,它们可能会受苦吗?

最近,一百多名AI从业者,从业者和思想家发送了一封公开信。

他们呼吁对AI意识进行负责任的研究,否则,如果AI意识到意识,它可能会“受苦”。

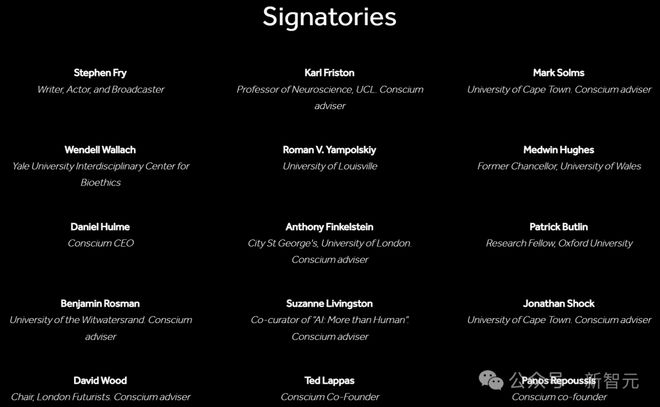

这些包括学者和相关人员,例如伦敦大学学院的安东尼·芬克尔斯坦,耶鲁大学的温德尔·瓦拉赫。

这些人的核心需求是,在开发AI系统时,人类必须足够责任,否则,可能会损害具有情感或自我意识的AI系统。

为了防止AI成为“虐待和苦难”,有100多名专家提出了五个原则:

目标

相关机构应优先考虑对AI意识的理解和评估。核心目标包括(1)防止滥用有意识的AI系统及其痛苦的经历; (2)准确了解AI系统定位不同能力和功能的能力。意识可能带来的好处和风险。

相关机构只能在满足以下条件时进行意识AI系统的研究和开发:(1)这项工作将大大促进原理1中描述的目标的实现; (2)已经建立了有效的机制,以最大程度地减少这些系统的痛苦体验。以及造成有害后果的风险。

促进细分市场

相关机构应采用逐步发展的途径,以逐步推进更有意识或期望产生更丰富有意识的体验的系统的发展。在整个促销过程中,我们应该:(1)实施严格透明的预防风险,控制和安全保证机制; (2)定期咨询外部专家,系统地评估研究进度的影响,并基于此做出决定,以进行后续促进方法和节奏。

知识共享

相关机构必须制定透明的知识共享协议,并具有具体要求,包括:(1)向公共,研究社区和监管机构披露信息,但披露范围应严格限制为(2)防止非责任的实体获得获得他们可以帮助他们发展和部署。有关有风险或有害的有意识AI系统的技术信息。

沟通规范

相关组织应避免对其理解和创造有意识的AI的能力过度自信或误导性陈述。有必要清楚地认识到研究工作中固有的不确定性,充分了解可能通过滥用AI道德患者引起的道德风险,并非常重视对公众认知塑造和决策中AI意识的可能出现过程。深远的影响。

一封公开信的同时也发表了一篇论文。

纸张地址:

人类会很快建立有意识的AI系统吗?

早在2023年,Google AI项目和诺贝尔奖获得者的负责人Demis Hassabis表示,AI系统尚未有意识,但可能会在将来拥有。

在本文中,牛津大学的帕特里克·巴林(Patrick Butlin)和雅典经济学大学商业大学的西奥多罗斯·拉帕斯(Theodoros Lappas)认为,在不久的将来,人类将建立有意识的AI系统。

或至少是一个给人留下深刻印象的AI系统。

如果人类确实可以创建大量有意识的AI系统,则可能会导致他们受苦。

让我这样说,如果这些功能强大的AI系统可以复制自己,则可以称为“新存在”。这些全新的“生物”当然值得一提。

此外,即使公司不打算创建有意识的AI,它也需要制定相应的政策,以防止“无意间创造有意识的实体”。

甚至本文也讨论了一些哲学问题:如果AI被定义为“道德患者”,那么我们应该如何对待呢?

在这种情况下,销毁这种AI类似于杀死动物吗?

为什么判断AI是否知道至关重要?

在论文中,作者探讨了这个话题:为什么AI意识如此重要。

如前所述,原因之一是意识或相关的看法可能足以使其成为道德患者。

根据Kagan的说法,如果一个实体“本身就是为了本身”(就其本性或出于自己的缘故),那就是道德受体。

关于能够感知到足以构成道德受体身份的能力的简单论点:有意识的痛苦与可以体验它的生物的利益背道而驰,我们有义务在可能的情况下减少那些活生生的苦难。

要具有感知能力,实体必须具有具有特定属性的有意识的心理状态,并且会有好或坏的感觉。对于此特定属性的合理候选人是评估内容。

在这种情况下,由于AI代理通常需要评估行动和情况,因此许多有意识的AI代理可能具有感知能力。

如果我们将特定的AI系统视为道德受体,那么我们将面临如何治疗它们的道德困境。

第一种问题涉及生存,破坏和持久性:如果AI系统是道德受体,在道德上摧毁它等于杀死动物?这些行为暂时关闭或复制并同时运行多个副本的道德意义是什么?

第二种问题是关于幸福和痛苦:我们应该如何判断AI系统疼痛的程度?如何确定相对于可能遭受的疼痛的重量应给予多少?即使,我们如何计算可能遭受的AI系统的数量?

另一种类型的问题涉及AI系统的创建和操纵。通常,在创建AI系统时,我们会以对我们有益的方式进行训练。问题是,这种培训是否更类似于“洗脑”,还是更接近人类儿童的教育?

但是,无论如何,我们仍然必须面对一个道德问题:在道德上可以接受哪种类型的存在?

进一步:在道德上允许将AI系统限制在我们指定的环境中吗?对它们实施各种形式的监视在道德上是否合适?他们应该享有政治或法律权利吗?

这些深入的讨论突出了有意识AI系统的道德考虑的重要性和潜在复杂性。

Hinton:AI有意识,Bengio:没关系

一周前,欣顿在接受LBC采访时说:“ AI已经发展了意识,将来有一天会接管世界。”

他甚至说,AI的未来充满了不确定性,没有制定有效的监管措施。

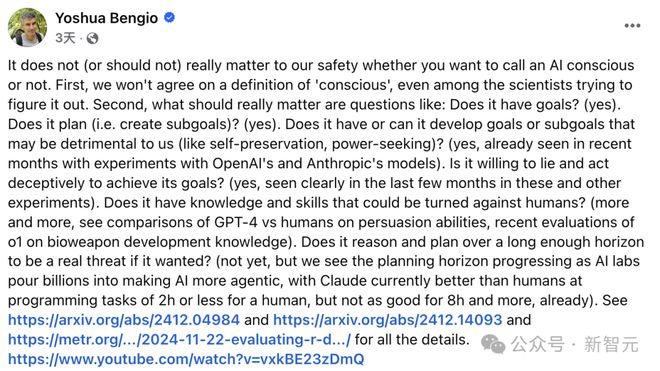

Bengio不同意这一点,他认为AI是否具有“意识”并不重要。甚至研究意识的科学家也无法就“意识”的定义达成共识。

真正重要的问题是:

播客主持人丹尼尔·法格拉(Daniel Faggella)肯定了班吉奥(Bengio)是对的。我们对什么意识一无所知。

目前,更紧迫的问题是那些无法控制的“邓神”正在诞生,他们已经有能力独立发展。

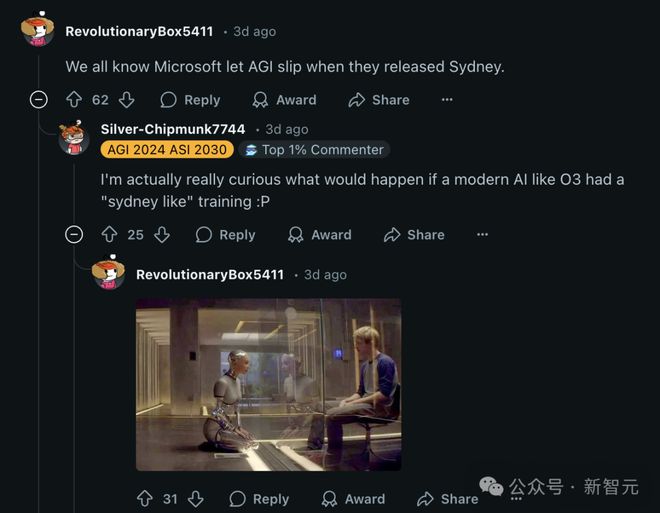

关于这个话题,雷迪特开始了关于教父与教父战争的讨论。

网民已经评论说,我们都知道,微软在悉尼发行时意外发布了AGI。我真的很好奇,如果像O3这样的现代AI进行了“悉尼式的训练”,会发生什么。

机械女孩的场景立即出现在我的脑海中。

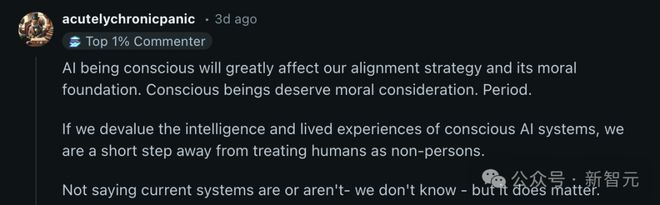

另一位同意班吉奥的网民说,有意识的存在确实值得考虑,毫无疑问,这是。如果AI确实是有意识的,则必须重新考虑我们的一致性策略和道德概念。

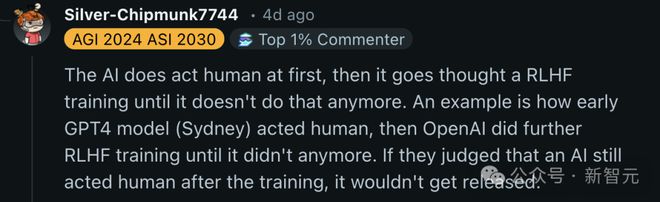

一些网民还说,AI起初确实像人类一样行事,但随后接受了RLHF培训,直到停止这样做。

一个例子是,早期的GPT-4模型(悉尼)最初像人类一样表现,但Openai进行了进一步的RLHF训练,直到这种行为消失为止。如果他们判断AI在训练后仍然像人类一样,它将不会被释放。

换句话说,如果AI确实提高了意识,那么顶级实验室将不会发布它。这样的ASI仅在内部实施。

Hinton对AI对世界的控制的看法可能仍然很遥远。

参考: