阿尔特曼在接受采访中解释说:“过去一年中,我们领域最重要的突破是这些新模式可以推理。”这标志着AI开发范式的转变:仅仅依靠扩大模型的规模并将预训练的数据增加到更精致和针对性的方法。在这种新方法中,增强学习起着核心作用。

传统的大型语言模型遵循相对简单的扩展逻辑:每一代模型的计算能力约为上一代的100倍。正如Altman所说:“在过去的范式中,我们只进行了从GPT-1到GPT-4的预训练,每个版本的计算能力大约是以前版本的100倍,并且每次都有重要的新功能。 ”但是,这种简单的扩展策略似乎遇到了瓶颈。

为此,Openai开始探索一个全新的方向:专注于开发通过强化学习优化的专业模型。

这些模型是通过强化学习优化的,并且特别擅长处理具有清晰答案(例如编程和数学问题)的任务。这种方法带来了惊人的计算效率提高,使他们能够达到以前使用较小型号的性能水平,直到GPT-6。

例如,在编程领域,这种新方法的效果尤其明显。他们的第一个推论模型O1在全球竞争激烈的程序员中排名前一百万,当时被认为是一个重要的突破。随后,该模型的功能迅速提高,很快进入了前10,000名。到2024年12月,他们公开发布的O3车型已达到175位。目前,他们的最新车型已达到第50位。奥特曼甚至预计到今年年底将排名第一。

但是,这种新方法也有其局限性。他解释说:“当我们采用这种新方法时,模型在各个方面都不会变得更好,而是要在特定维度上取得突破。”这种专业化使新一代模型在编程领域的表现良好,但是仍然有改进创意任务的余地,例如发明新算法或发现新的科学知识。

为了克服这些局限性,OpenAI正在尝试一个新的方向:将大规模的预训练模型与专门的推理能力相结合。奥特曼认为,这种组合可能会导致重要的突破,这带来了“真正的新科学知识或某种生活迹象的第一个迹象”。

实际上,DeepSeek-R1推理模型已将强化学习带来的推理能力推广到其他领域,并且能够改善诸如写作之类的一般领域的能力已经表明了这种可能性。

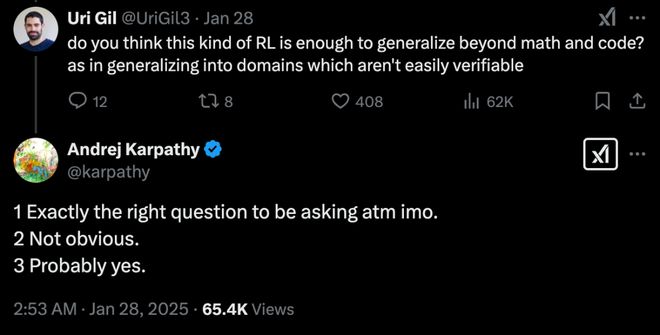

图片丨andrej karpathy关于强化学习是否可以概括的意见(来源:x)

在采访中,奥特曼还透露了Openai对未来的计划。他说,在接下来的六到12个月中,他们将专注于开发小但有效的推理模型。这些模型不仅将保持其在科学技术领域的优势,而且还将逐渐扩展到其他领域。同时,他们还在努力实现多模式集成,使用户可以同时使用语音,代码写作,画布创建等各种功能。

奥特曼说:“到今年年底,我们希望能够推出一种新模式。” “如果用户使用Pro版本并将其计算能力调整为最大值,他们可能会提出非常困难的问题。尽管该模型可能需要几个小时。考虑它的时间可能需要使用多种工具,但最终可以独立完成任务。但是现在我们不能指望它发现新的科学原理。”

此外,OpenAI的位置正在对开源问题进行细微的变化。此更改部分是响应DeepSeek发布开源推理模型R1的。 “我们将成为开源,”阿尔特曼说。 “虽然我不能确切说出什么是开源的,但社会似乎准备好接受开源模型的影响。”

奥特曼说,Openai在确保模型的安全性和鲁棒性方面取得了进展。尽管开源模型可能无法完全按预期使用,但他们认为,在大多数情况下,这些模型将扮演其正当角色。

正如Altman声称的那样,Openai会在2025年更加开放并领导吗?让我们拭目以待。

参考:

1。

排版:Chu Jiashi