谁会想到,一年半以后,2023年发表的LLM论文将再次流行。

聊天机器人开始面临基本限制

在本文中,来自AI2和华盛顿大学等机构的研究人员说,变形金刚在组合能力方面有局限性。

以基本乘法为例,让“ GPT-4”计算两个三位数的乘积,初始准确率仅为59%。当乘数增加到4位数字时,准确率直接下降到4%。

纸张地址:

同时,Quanta Magazined还引用了彭本伊(Peng Binghui)在2024年发表的一篇论文,后者曾经是博士学位。在报告中证明变压器具有基本限制。

纸张地址:

纸张地址:

第一部作品彭·本格伊(Peng Binghui)和他的导师也证实,由于变压器缺乏组合能力,LLM具有幻觉。

他们指出:“如果大型模型只有单层变压器结构,并且参数总数小于域的大小,则AI将无法求解合并的任务。”

实际上,这些研究本身并不是什么,但QM称其为“最近”。评论部分立即被网民的投诉所淹没。

Openai研究员Noam Brown直言不讳地说:“学术界的研究步伐相对较慢,而LLM领域的发展速度远远快。”

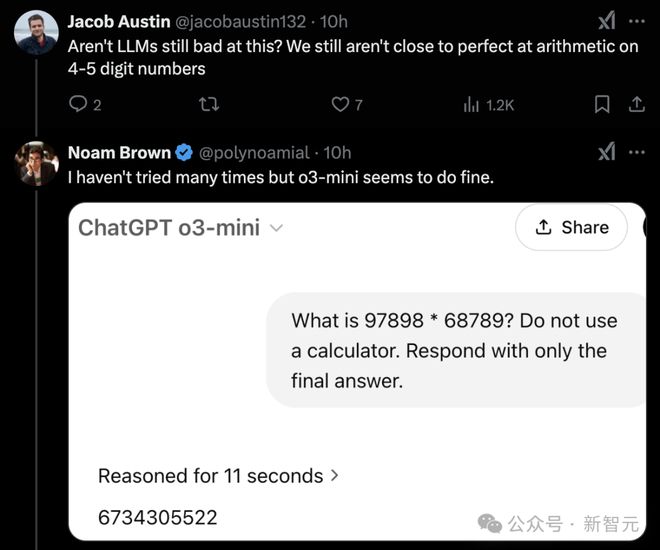

DeepMind研究科学家驳斥了这一点,我们在4-5位算术操作中仍然没有达到完美的水平。

这些论文中的观点现在仍然有效吗?

乘以四位数,GPT-4精度为4%

艾伦人工智能学院的科学家努哈·迪兹里(Nouha Dziri)和他的团队测试了由chatgpt代表的LLM,并要求他们尝试解决此类逻辑问题,但模型的表现较差。

Dziri指出,当面对复杂的任务时,LLM很难根据培训数据外的信息来推理,并且只能进行近似推断,这很可能会犯错。

一项需要将答案集成到多个子问题的任务才能提出最终结果,称为组合任务。

Nouha Dziri的团队发现,大多数LLM仅依靠预测序列中的下一个单词进行培训,并且在应对组合推理任务时存在根本缺陷。

在处理此类问题时,大多数LLM所采用的变压器架构将受到数学限制。

尽管科学家在打破了变压器的局限性方面取得了一些成果,但这些成就越来越像停止措施一样。

这种类型的模型有基本的计算瓶颈,也许是时候考虑改变研究思想了。

纽约大学的机器学习专家安德鲁·威尔逊(Andrew Wilson)说:“这项研究的真正目的是帮助学术社区法官判断变形金刚是适合通用学习的建筑。”

Openai的O1和GPT-4,Google的Gemini和Anthropic的Claude几乎对所有可以获得的互联网数据进行了培训。

LLM掌握了语法并积累了许多语义知识。可以对这些预训练的模型进行进一步培训或优化以完成更复杂的任务,例如汇总复杂文档和生成游戏代码。

它是如此强大,以至于似乎能够推理,但与此同时,它在某些方面非常贫穷,令人惊讶的是愚蠢。

以基本的乘法操作为例,诸如chatgpt和gpt-4之类的常见LLM效果不佳。

在2023年初,Dziri团队测试了GPT-4,并要求它计算两个三位数乘以乘以,初始精度仅为59%。当计算两个四位数数字的乘法时,精度率急剧下降,仅留下4%。

该团队还测试了LLM在拼图任务上的表现,结果也不理想。

当难题是两个房屋时,每个房屋对应于两个属性,GPT-4仍然可以正确回答。但是,当难题升级到四座房屋时,每个房屋对应于四个属性,精度率将大幅降至10%。

“国际生活”中的原始拼图版本是五座房屋,每个房屋对应于五个属性,而GPT-4的准确率直接归零。

Dziri认为“这只是模仿我所看到的,而不是真正理解的。”

有局限性很难突破LLM

同时,另一个研究团队采取了不同的方法来理解为什么LLM在处理组合任务时遇到困难。

当时,曾在哥伦比亚大学学习博士学位的彭本伊(Peng Binghui)和他的导师克里斯托·帕帕迪米特里(Christos Papadimitriou)等人研究了为什么LLM具有幻觉并产生了与事实不一致的错误信息。

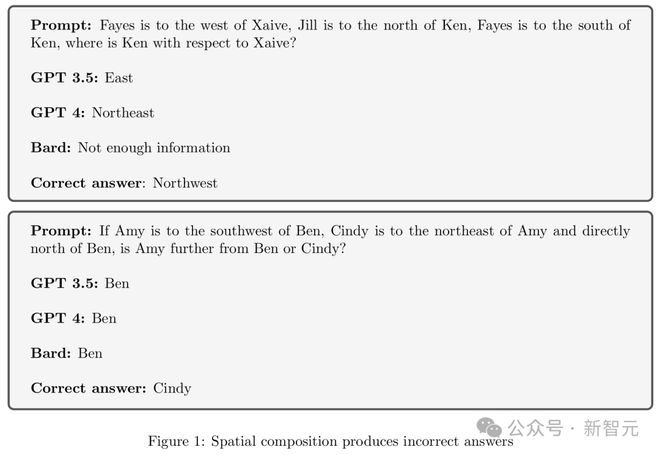

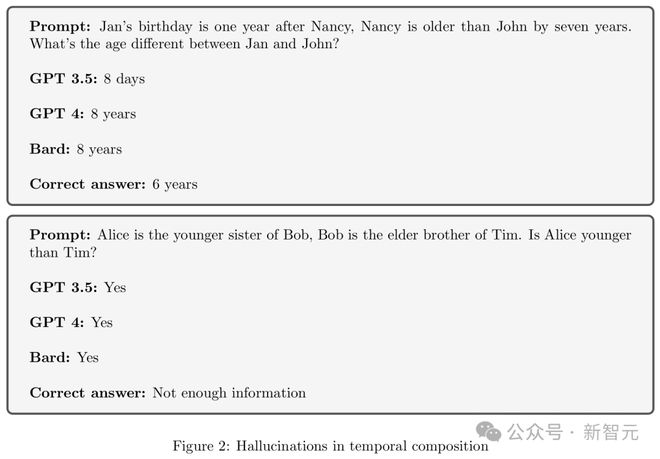

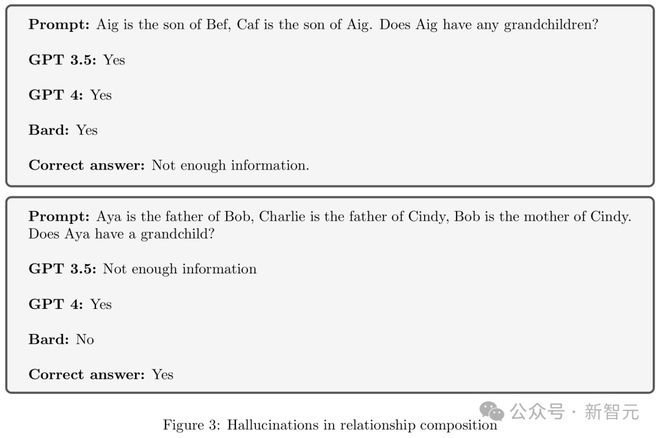

以下三个图中的示例显示了LLM在空间组成,时间组成和关系组成方面产生的幻觉。

左右滑动以查看

在这方面,团队怀疑原因是变压器缺乏“组合功能”。

假设您在LLM中输入了两片信息:一个是弗雷德里克·肖邦的父亲是尼古拉·肖邦(Nikola Chopin),另一个是尼古拉·肖邦(Nikola Chopin)出生于1771年4月15日。 ?

目前,LLM需要集成这两个信息以回答。

实际上,它想要回答的是一个嵌套的问题,首先找出弗雷德里克·肖邦(Frederick Chopin)的父亲是谁,然后回答了该人的出生日期。

如果LLM给出的答案是错误的,并且出现了所谓的“幻觉”,那么它很可能未能成功完成此组合任务。

为了验证这一猜想,团队首先研究了一个简单的变压器的特征。

该模型只有一层。在预测下一个单词时,它将根据句子中单词的顺序和位置进行判断。现代LLM通常包含多层此类结构。

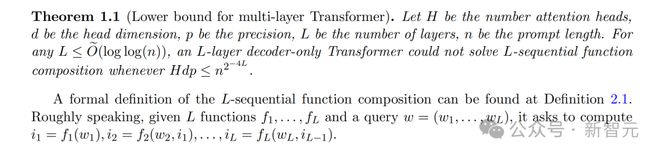

团队发现了变压器层的复杂性与域大小之间的联系(即问题所需的位数)。

通过研究这个简单的模型,它们证明了数学约束。

如果单层变压器的参数总数小于域的大小,则从理论上讲,变压器无法求解组合任务。

只有一个变压器层LLM,这对数学级别有明显的局限性。

尽管这是一个非常令人信服的理论成就,但其实际影响仍然不清楚,因为现代LLM要复杂得多。

因此,团队改变了研究更复杂的变压器功能的方法。他们利用计算复杂性理论来通过分析解决问题所需的时间,记忆和其他资源来探索问题的本质。

他们用一个著名的猜想确认,在解决复杂的组合问题时,即使是多层变压器也具有计算能力的局限性。

2024年12月,Peng Binghui和加利福尼亚大学的研究人员伯克利出版了证书。这次,他们搁置了计算复杂性理论的猜想,并直接证实了多层变压器确实无法解决某些复杂的组合任务。

彭·宾豪(Peng Binghui)说:“在模型量表增加之后,它确实可以解决更具挑战性的问题。但是,如果同时扩大问题的量表,即使模型变得更大,仍然很难解决。”

这充分表明了变压器体系结构具有无法克服的限制。

但这并不意味着LLM的结束。

纽约大学的威尔逊指出,尽管有这些局限性,研究人员已经开始改善变形金刚,以帮助他们更好地解决包括算术在内的各种问题。

马里兰州大学的计算机科学家汤姆·戈德斯坦(Tom Goldstein)及其同事在输入变压器的数字时进行了一些调整,将其他位置信息嵌入每个数字中并训练加法模型。

执行100位数量时,20位训练模型可以达到98%的稳定精度;而没有其他职位信息的模型仅约为3%。

这表明也许有一些基本的改进方法可以采用,以便在这些问题上可以取得重大进展,而无需重新设计整个架构。

除了扩大模型的规模外,还有一种克服LLM的局限性的方法,LLM的局限性在提示中为问题提供了分步解决方案,即思考链提示。

研究表明,此方法可以使LLMS(例如GPT-4)解决更多相关任务。

斯坦福大学的博士生Haotian Ye说:“我们很好奇为什么它如此出色,并且会带来如此多的突破。”

当他在北京大学学习本科生时,他在使用思维链来提示是否提示后比较了变形金刚的表现。

他们使用计算机科学的另一个分支,即电路复杂性的理论,证明了思维链的提示如何将一个大问题分解为一系列小问题,从而使变压器能够处理更复杂的组合任务。

但是,Haotian Ye还提醒您,这并不意味着该模型可以通过使用思考链提示真正解决这些问题。

这项研究的重点是理论能力,并且对模型的训练方式确定了他们可以在多大程度上发挥理论上极限的程度。

LLM本质上是以前已经看到的匹配模式,并且它们的能力在数学上受到限制。嵌入技术和思维链技巧只是扩大了处理更复杂模式匹配的能力。

从数学原理的角度来看,总是可以找到一些组合任务,这些任务很复杂,超过了给定系统的处理能力。

Dziri说:“我们必须弄清楚内部模型如何彻底工作。如果我们能弄清楚它们如何执行任务和原因,我们可以优化和改进它们。如果我们不知道,那真的很难做任何事情。”现在。”

作者的介绍

Peng Binghui目前是加州大学伯克利分校西蒙斯研究所的博士后研究员。此前,他获得了哥伦比亚大学的博士学位,他的导师是XI Chen和Christos Papadimitriou。他还获得了Tsinghua University的Yao班级学士学位。

Peng Binghui拥有广泛的研究领域,涉及机器学习理论,游戏理论和理论计算机科学。最近,他特别注意计算理论与AI之间的相互作用。

参考: