生成式 AI 正以极快的速度进化出一种能“一本正经地胡说八道”的能力。不久前,有两封信在网上流传开来,其中一封是署名英伟达 CEO 黄仁勋的内部信,信中表达了对 DeepSeek 的看法;另一封是“来自”DeepSeek CEO 梁文锋对冯骥的公开回应。乍一看,这些信件像是本人的真情实意表达,但很快就被辟谣了,原来这些都是虚假捏造、胡说八道的内容。

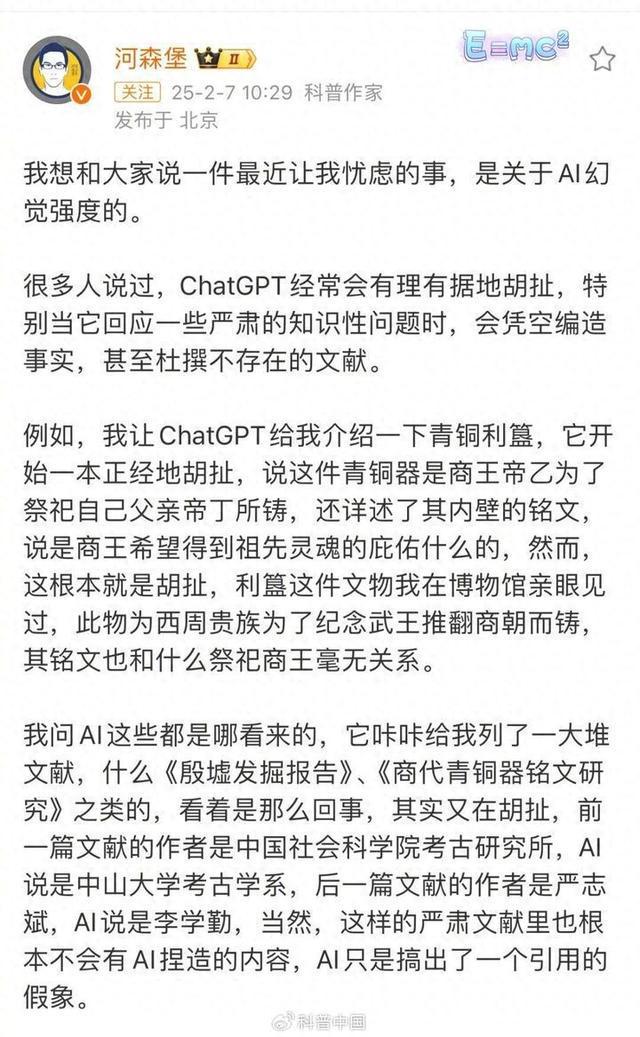

当前,AI 毫无顾忌地进行造谣的情况频繁出现,并且还有人故意提供虚假信息来捏造虚假数据库。在 AI 赋能众多行业的时代已经来临之际,怎样应对 AI 产生的幻觉,怎样辨别信息的真假,已经成为大家都在谈论的公共话题。当面对 AI 给你的答案时,你应该怎样进一步去询问和探究呢?

AI幻觉是什么?

AI 幻觉指的是大语言模型编造它以为是真实存在的信息,这些信息甚至看起来是合理或可信的。大模型出现幻觉,简单来说就是它在一本正经地“胡说八道”;确切来讲,是指模型生成的内容与现实世界的事实或者用户输入不相符的这种现象。

科普中国曾解释,在考试遇到不会的题目时,我们会用已知知识推测答案。AI 遇到信息缺失或不确定情况时,会依据自身的“经验”(训练数据)进行填补和推理。这并非它想欺骗我们,而是它在试图以自己理解的模式完成该任务。

记者留意到,目前已有使用者察觉到 deepseek 出现了一本正经地“胡说八道”的状况。比如,在生成学术论文相关材料时,DeepSeek 会生成那些并不存在的材料,或者指向一些不相关的论文。业内人士向记者表明,大模型当前面临的“幻觉”问题,其主要的根源在于训练数据受到了污染。

AI 大模型科技公司为防止“AI 幻觉”出现,采取了诸多办法。其一,通过用更多正确且清晰的信息对 AI 进行训练;其二,针对某些特定的话题或问题,对 AI 实施微调;其三,借助另一个 AI 或者数据库来帮忙检查,以确保答案的准确性。

DeepSeek 回复这一问题时表明,实行的原则为:把好数据关,练好防骗术,实时进行监控并随时进行升级。从数据的源头到模型的运行,全程都设置防线。借助清洗数据、对抗训练、知识蒸馏等方式,以保证模型学到的是“真知识”;通过知识溯源和设置安全护栏,防止模型被“带偏”;通过持续不断地更新,让模型始终处于安全状态。

开源是否等于模型可以被“瞎改”?

目前除了存在 AI 幻觉这种情况之外,还出现了给 AI 进行“投毒”的现象,也就是给 AI 喂假料,并且利用 AI 来作恶。

媒体报道称,股市中的“黑嘴”们以及幕后的不法之徒,利用虚假语料让大模型给出错误回答,接着把这些“AI 答案”进行传播扩散,以此来坑骗散户,目的是干扰甚至操纵个股的市场交易。近期,慈星股份、华胜天成、并行科技、诚迈科技和三六零这 5 家上市公司被“黑嘴”盯上,成为了 AI 问答截图中的主要角色。

有网友认为,AI 大模型是开源的,不存在筛查和审核的机制。这就使得任何人都能够随意地对其进行灌输学习,从而加剧了 AI“说谎”的能力,甚至使其具备了“作恶”的能力。

当记者向 DeepSeek 询问其模型是否容易被“投毒”时,它作出回复。它表示开源模型并不等同于容易被投毒,关键在于开发者是否采取了有效的防护措施。只要通过严格的数据管理、代码审查、模型验证以及社区协作,开源模型就能够既保持开放又确保安全。

记者获悉,开源的意思是源代码是公开的,任何人都能够查看、修改或者分发代码。不过,这一般需要遵循特定的协议,像 MIT 许可证、GPL 等。这并不代表所有的修改都是有价值的,也不意味着所有修改都是正确的。实际上,开源项目通常会具备严格的贡献规范以及代码审查机制,目的是保证代码修改的质量和一致性。确保大模型开源不被“瞎改”,需要有关部门的审查机制发挥作用,需要科技公司具备“防火”能力,也需要建立健全内容审核和侵权举报机制等,这些方面需多管齐下。

我们“喂”给大模型的内容安全吗?

“神准!”“太对了!”随着 AI 助手的广泛使用,特别是大模型所展现出的“智能感”,会让用户觉得该模型对自己有很深入的了解。这是为什么呢?

对此,江苏人工智能学会会员介绍,他是南京理工大学计算机科学与技术学院副教授蒋庆远。和电商平台的推荐逻辑相似,大模型会依据模型学习的知识以及用户输入的内容来调整输出和反馈。比如我们曾和 AI 聊过《哪吒》电影,大模型可能会跟你聊封神题材的电影,也可能会聊动画题材的电影。这其实是因为大模型通过学习公开知识,认为《哪吒》与其他封神题材或动画题材电影存在“强关联”。

使用 AI 智能体来处理个人信息,是否会存在隐私泄露的风险呢?这是众多用户所关心的一个问题。

蒋庆远称,在符合规定的情形下,大模型的训练数据一般包含公开数据集、从互联网抓取的数据以及合作伙伴所提供的数据,这些数据里并不涵盖 AI 智能体与用户交互时产生的数据。不过他也进行了提醒,用户在运用 AI 工具的时候,应当对期望进行合理的管理,防止过度依赖,同时还得自己去判断信息的敏感性,不能把关键信息上传到非可信的平台上。

记者查阅多家大模型的官网后发现,多数产品表明会收集用户数据,这些数据将用于“改进服务”。然而,这些数据是否会直接用于模型训练,取决于隐私政策以及用户的同意。

DeepSeek 的隐私政策包含了电子邮件地址、电话号码、击键模式等个人隐私数据的收集。然而,对于这些收集到的内容是否会被用于模型训练,并没有明确的说明。

GPT 官网称,从 2023 年开始,OpenAI 作出承诺,不会将通过 API 提交的数据用于训练,除非获得用户的明确同意。

业界人士表示,即便用户上传的数据并非用于模型训练,然而用户数据仍有可能因存储、跨境传输或者第三方共享等情况而出现泄露现象。

如何防范和避免AI误导?

专家表示,要避免被大模型误导,用户可以采取以下策略:

与大模型交流时,优化提问方式很重要。提问要尽量明确且具体,不能模糊或开放。同时,要提供足够的上下文或背景信息,这样能降低大模型胡乱推测的概率。比如,可以设定回答的界限,让大模型在指定资料范围内作答,也可以对回答中的推断内容进行标注,方便用户识别。

此外,一个有效的方法是要求大模型分批输出结果。因为大模型是根据概率生成内容的,单性生成的内容越多,出现误导的概率就越大。所以,用户可以让大模型先列提纲,然后分段输出,逐段进行审核,这样就能更方便地把控生成内容的质量。

交叉验证是避免被误导的重要方式。用户将不同大模型的答案进行比对,就能够获得更全面的认知,进而判断出哪个答案更为准确。

求证网络信息时,“追问”是个有效的策略。大模型若援引“专业人士”“专业机构”“文献资料”等说法,用户可要求其提供对应证明材料,像链接、原文、视频等。查看这些材料后,用户能判断大模型的回答是否“有理有据”,以此避免被误导。

新华日报·交汇点记者 张宣 杨易臻 刘海琴

图片来源 视觉中国