2 月 11 日,中国科大苏州高等研究院医学影像智能与机器人研究中心的 DDL 实验室宣布了一个消息。2 月 23 日,IT 之家得知了此消息。该团队在大规模图神经网络(GNN)训练系统方面的研究论文被国际知名学术会议 ACM International Conference on Management of Data(SIGMOD)2025 录用。

图神经网络(GNN)的主流训练框架,例如 DGL 和 PyG,它们借助 GPU 的并行处理能力,从图数据当中提取出结构信息,在推荐系统领域展现出卓越性能,在自然语言处理领域展现出卓越性能,在计算化学领域展现出卓越性能,在生物信息学领域展现出卓越性能。

GPU 在 GNN 训练中具有强大的计算优势。然而,它的显存容量是有限的,难以容纳庞大的图数据。正因如此,现有 GNN 系统在大规模图数据上的扩展性方面面临着挑战。

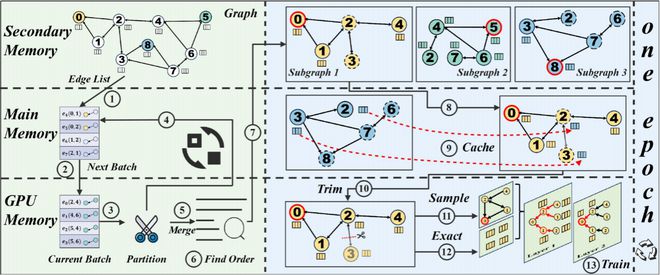

对此,DDL 实验室团队提出了一种新的框架,即 Capsule,它是一种核外(Out-of-Core)的 GNN 训练框架,为大规模图神经网络训练提供了高效的解决方案。

该系统与现有的核外 GNN 框架不一样。它利用图划分和图裁剪策略,把训练子图结构及其特征都完全放置到 GPU 显存里。这样就消除了在反向传播过程中 CPU 与 GPU 之间的 I/O 开销。进而使系统性能得到了显著提升。

Capsule 设计了基于最短哈密顿回路的子图加载方式,并且采用了流水线并行策略,以此进一步优化了性能。同时,Capsule 具有即插即用的特性,能够将其无缝集成到主流开源 GNN 训练框架当中。在大规模真实图数据集上,Capsule 与现有的最好系统相比,在内存使用仅为 22.24%的情况下,能够带来最高 12.02 倍的性能提升,并且还提供了关于训练所得嵌入方差的理论上界。

这一成果具有重要意义,它标志着我国在图计算系统领域取得了突破。此突破为一些场景提供了全新解决方案,这些场景包括社交网络分析以及生物医学图谱构建等,并且这些场景都需要处理超大规模的图数据。

IT之家附论文链接: