3 月 9 日消息来自快科技。从超算互联网官微得知,本周超算互联网平台上线了阿里巴巴开源推理模型 QwQ - 32B 的 API 接口服务。现在用户能够获得免费的 100 万 Tokens。

了解到,平台依托国产深算智能加速卡以及全国一体化算力网,能够让海量用户方便地调用 QwQ-32B、DeepSeek-R1 等国产开源大模型的接口服务。

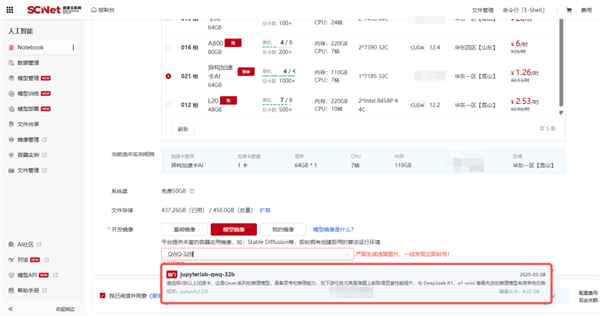

超算互联网QwQ-32B API接口服务页面

超算互联网QwQ-32B模型镜像创建页面

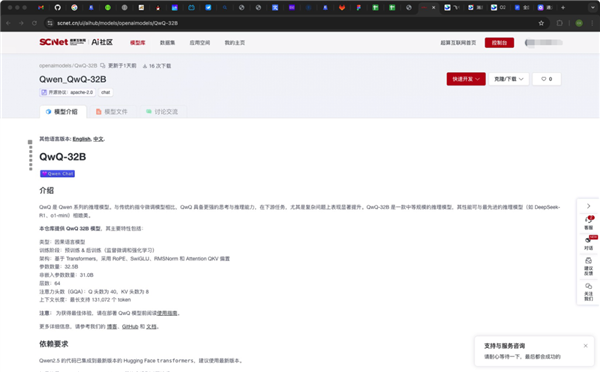

超算互联网AI社区QwQ-32B模型快速开发页面

用户无需进行本地下载操作,只需点击一键,便可启动Notebook功能。通过此功能,用户能够在平台上迅速开发QwQ-32B模型,也可以引入专有数据,进而实现私有化部署。

阿里 Qwen 团队最新发布了 QwQ-32B 推理模型,它是基于 Qwen2.5-32B 并通过强化学习构建而成的。

官方公示的基准评测结果显示,在测试数学能力的 AIME24 评测集上,QwQ - 32B 的表现与 DeepSeek - R1 相当。同时,在评估代码能力的 LiveCodeBench 中,QwQ - 32B 也表现出色,远胜于 o1 - mini 及相同尺寸的 R1 蒸馏模型。

QwQ-32B API调用服务具体步骤如下:

用户在超算互联网商城的首页进行搜索,搜索的内容是 QwQ - 32B。接着,用户点击“QwQ - 32B 接口服务”这一商品。购买完成之后,用户再点击“去使用”。

点击“去使用”,就会进入 API 接口信息页面。

按需选择访问形式,有以下三种:可使用 Postman、Apifox 等 http 工具进行访问;能使用 python 代码进行访问;还可以在终端页面直接进行访问。

目前,超算互联网提供了 QwQ-32B 模型的 API 接口服务。近期,它还上线了 DeepSeek-R1 全家桶,以及最高 671B 满血版的 API 部署与 AI Web 应用服务。

QwQ-32B API接口服务:点此进入

模型快速开发:点此进入

3 月 6 日,阿里巴巴通义千问推出了最新开源模型 QwQ - 32B 并正式发布。该模型的尺寸比 DeepSeek 要小,然而其性能却能够与全球最强的开源推理模型相媲美。

据了解,千问 QwQ-32B 通过大规模的强化学习,在数学方面实现了质的飞跃,在代码方面也实现了质的飞跃,并且在通用能力上也实现了质的飞跃。整体性能能够与 DeepSeek-R1 相媲美。

千问 QwQ - 32B 在保持强劲性能的同时,还将部署使用成本大幅降低了,并且在消费级显卡上也能够实现本地部署。

目前,阿里采用了宽松的 Apache2.0 协议。阿里将千问 QwQ-32B 模型向全球开源。所有人都能够免费下载该模型。所有人都可以将该模型用于商用。