智东西于 3 月 18 日在圣何塞进行报道。在拓展 AI 基础设施领域这件事情上,英伟达已经达到了一个新的高度。

英伟达 GTC 大会是一年一度的“AI 界春晚”,本周盛大开幕。今日,英伟达针对 AI 时代发布了两款新品。一款新品聚焦于网络领域,推出了光电一体化封装的网络交换机,为规模更大的 AI 工厂做好了铺垫。另一款新品聚焦于企业存储,构建了 AI 数据平台,其目的是提升 AI 智能体工作流程的性能和准确性。

英伟达把超大规模新型数据中心称作 AI 工厂。AI 工厂的规模在持续增大,AI 网络基础设施需要进行迭代升级,而把硅光直接集成到交换机里是一个有效的策略。

数据是 AI 时代的原材料。英伟达与全球领先的存储企业展开合作,致力于打造新型企业基础设施,以满足在混合数据中心部署和扩展 AI 智能体的需求,从而能够更高效地挖掘存储在企业系统中的数据价值。

一、光交换机最快今年上市,将AI工厂扩展至数百万GPU

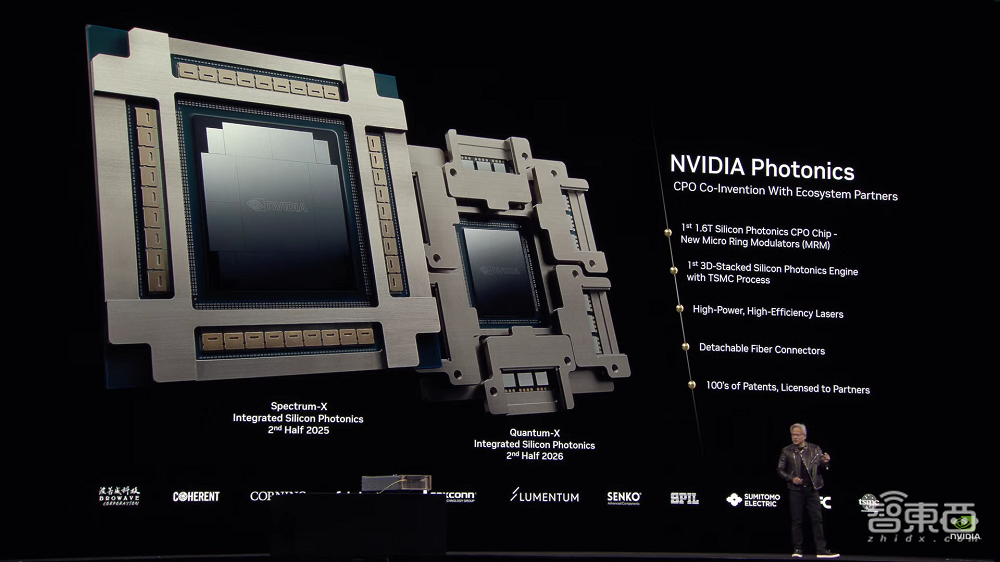

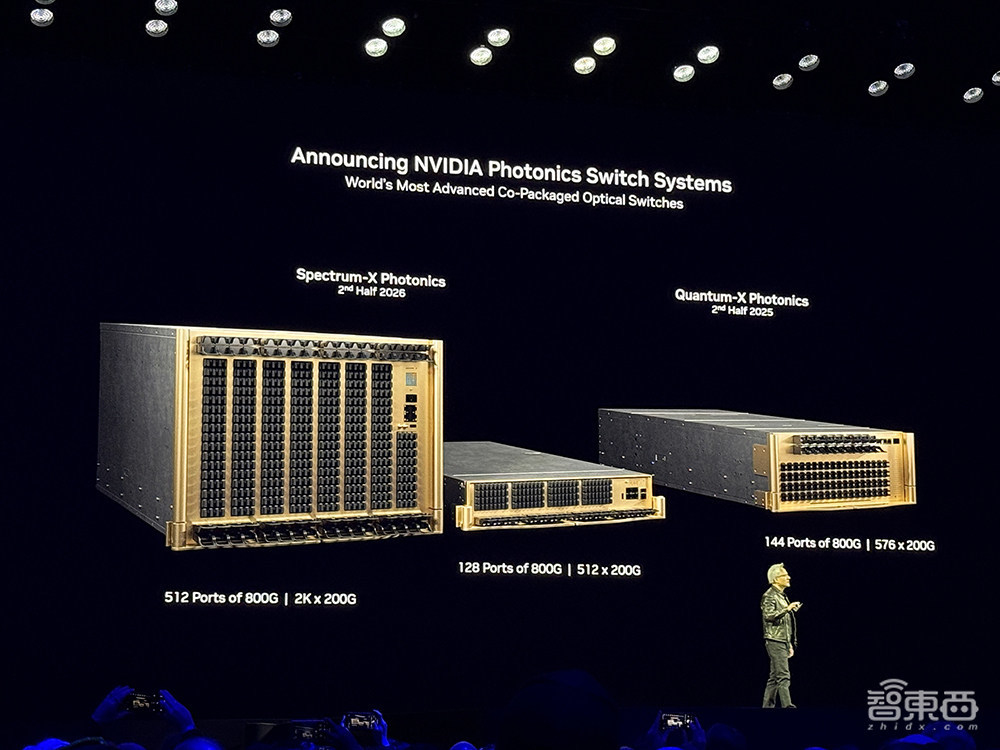

英伟达今日宣布推出两项产品,分别是光电一体化封装网络交换机 NVIDIA Spectrum-X Photonics 和 Quantum-X。这使得 AI 工厂能够跨区域连接数百万 GPU 级别。并且,这还能大幅降低能耗和运营成本。

英伟达硅光交换机每端口为 1.6Tb/s,它创新地将光器件进行了集成。激光器的数量减少到了原来的 1/4。与传统方法相比较,其能源效率提升至 3.5 倍。信号完整性提升至 63 倍。大规模组网的可靠性提升至 10 倍。部署速度提升至 1.3 倍。

NVIDIA Quantum-X Photonics InfiniBand 交换机有望在今秋上市,而领先的基础设施与系统供应商将于 2026 年推出 Spectrum-X Photonics 以太网交换机。

Spectrum-X 以太网网络平台与传统以太网相比,能够为多租户提供性能,还能为超大规模 AI 工厂提供性能,并且能提供 1.6 倍的带宽密度。

以及一种配置是有 2048 个 200Gb/s 端口,总吞吐量可达 400Tb/s。

其 AI 计算网的扩展性是上一代产品的 5 倍。

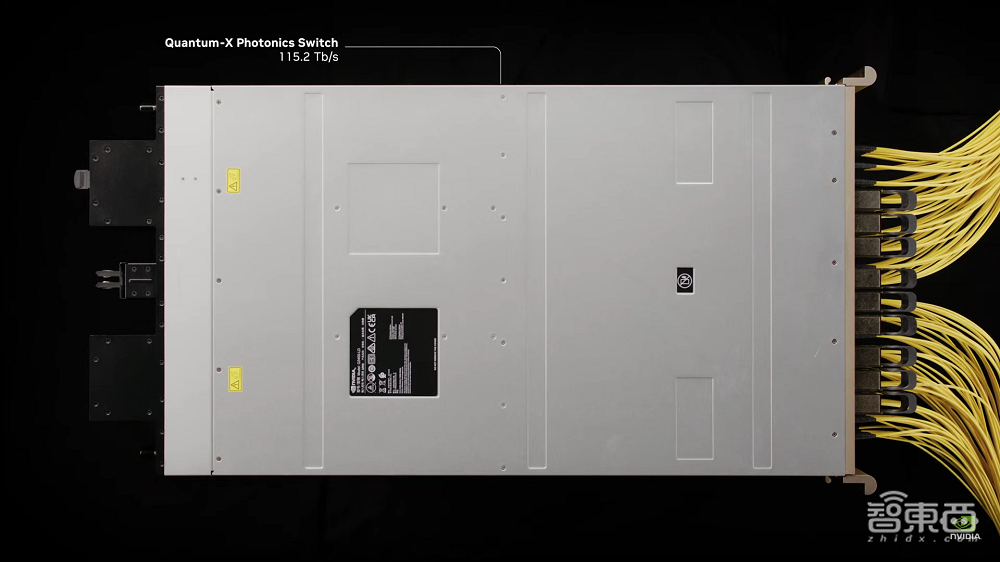

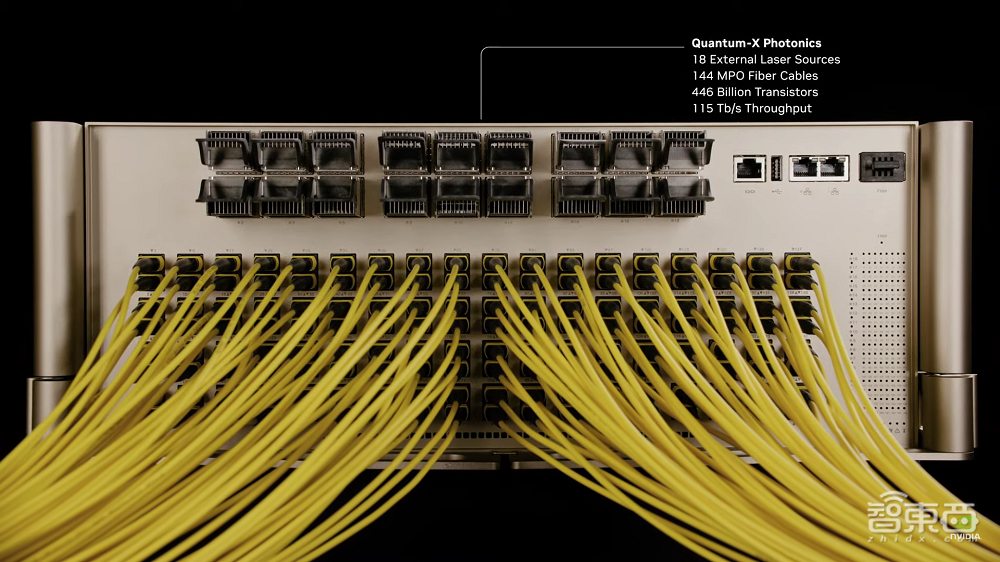

英伟达创始人兼 CEO 黄仁勋在 GTC 主题演讲期间播放的视频里,Quantum - X 光交换机的带宽达到了 115.2Tb/s。

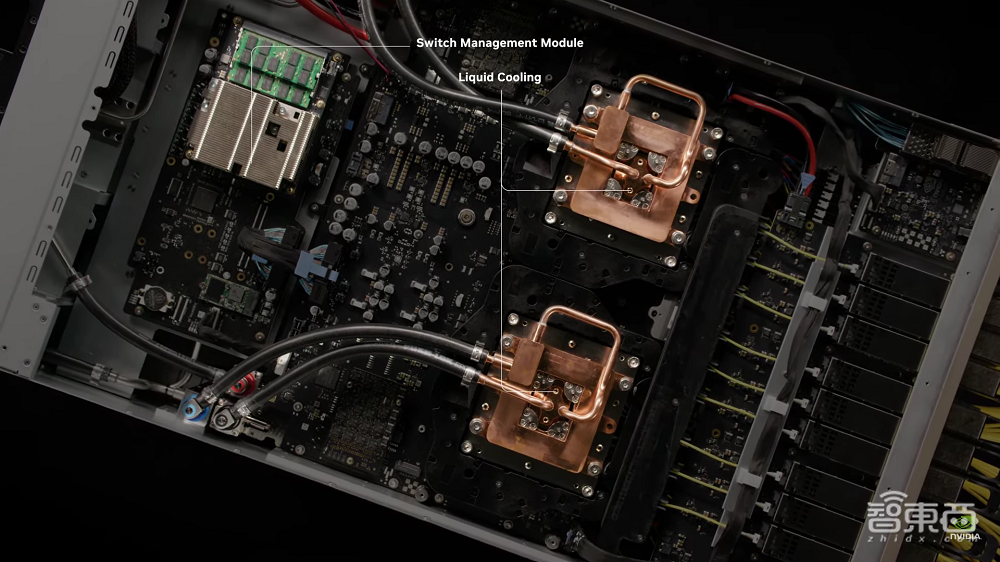

内置有交换机管理模块,采用液冷散热。

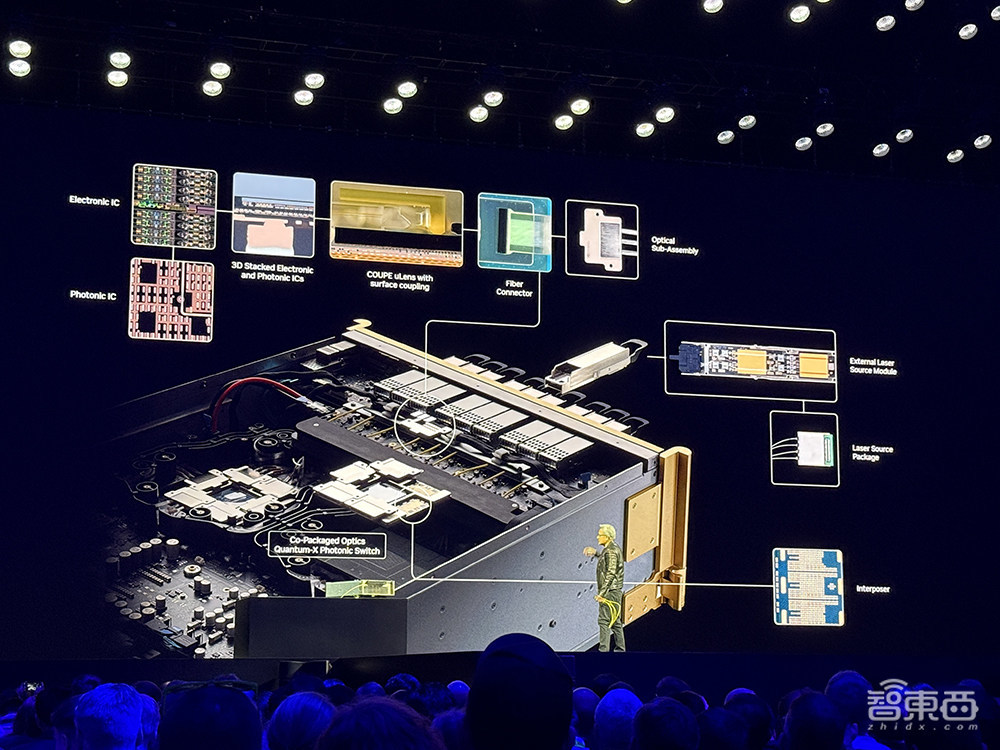

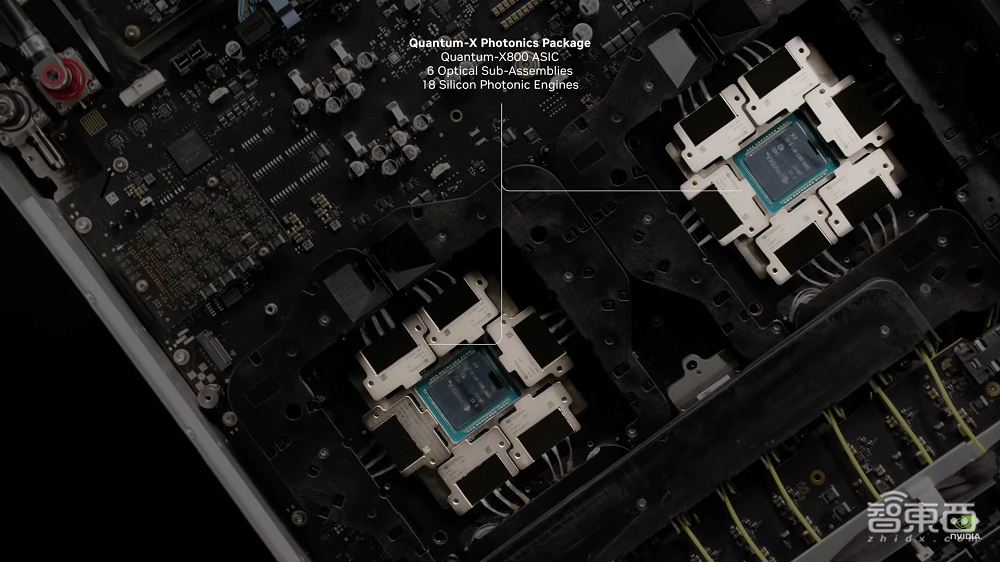

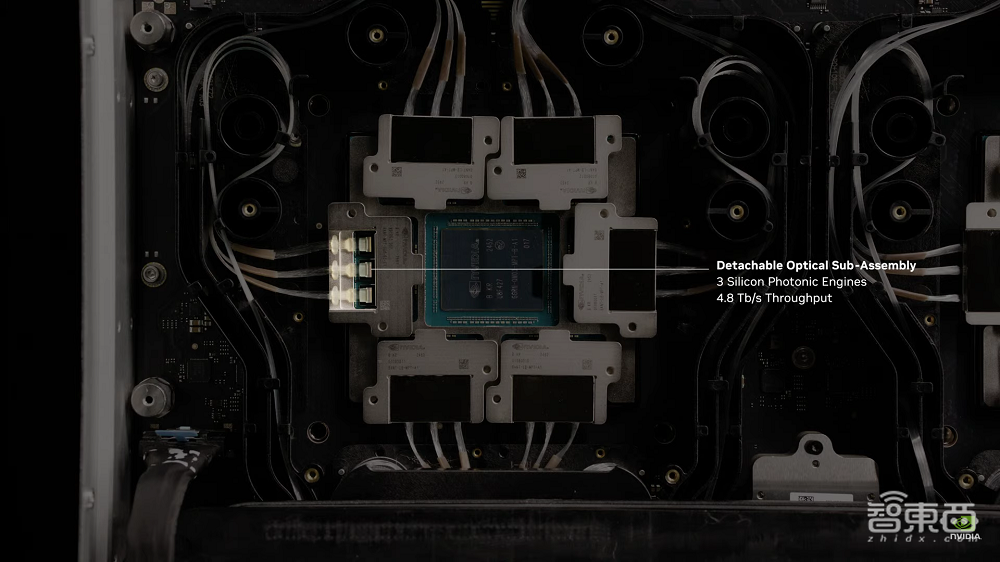

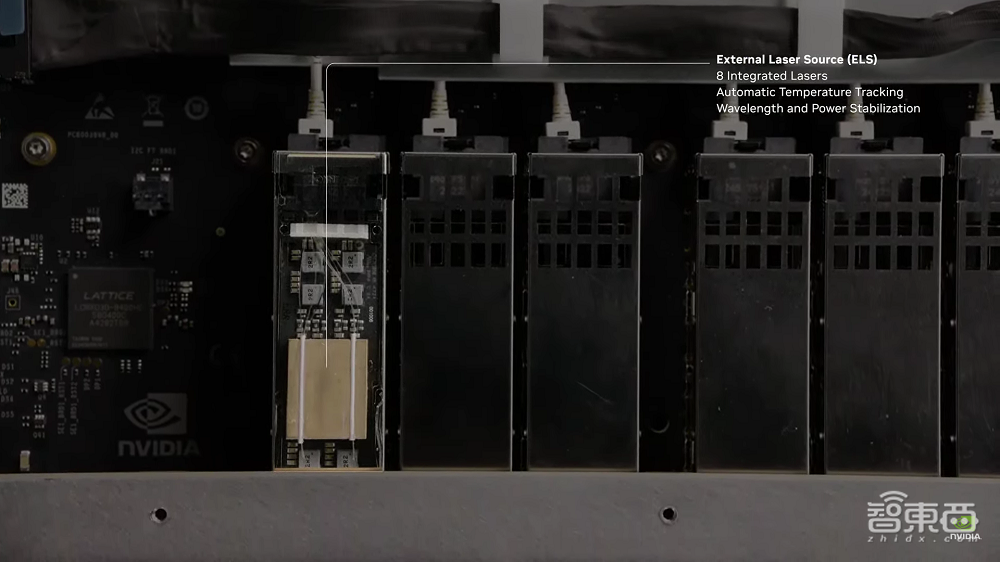

量子 - X 光学封装中包含量子 - X800 ASIC 芯片,还有 6 个光学子组件以及 18 个硅光引擎。

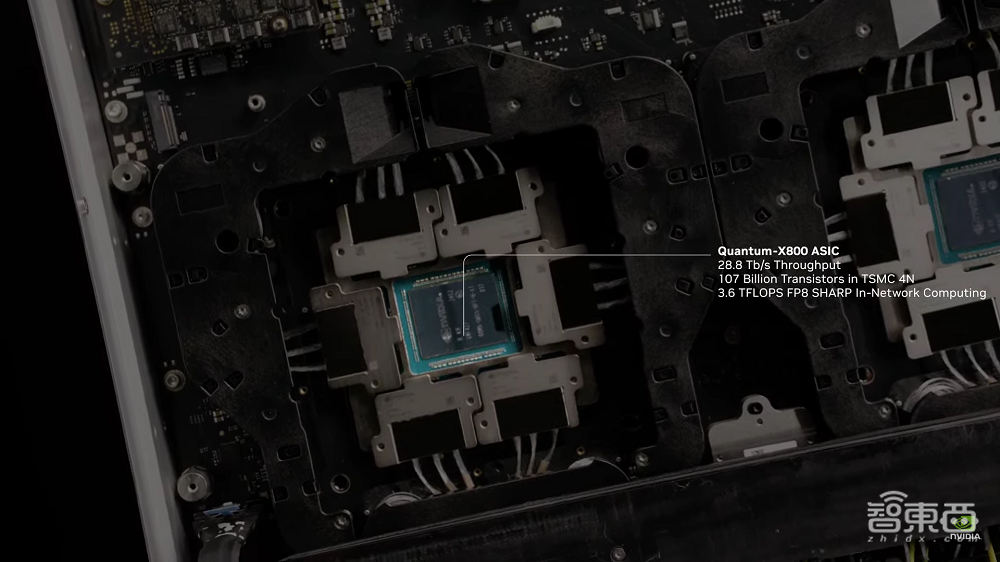

量子-X800 ASIC 的总吞吐量能够达到 28.8Tb/s。它采用台积电 4N 工艺。并且拥有 1070 亿颗晶体管。其网络内自带 3.6 TFLOPS FP8 SHARP 算力。

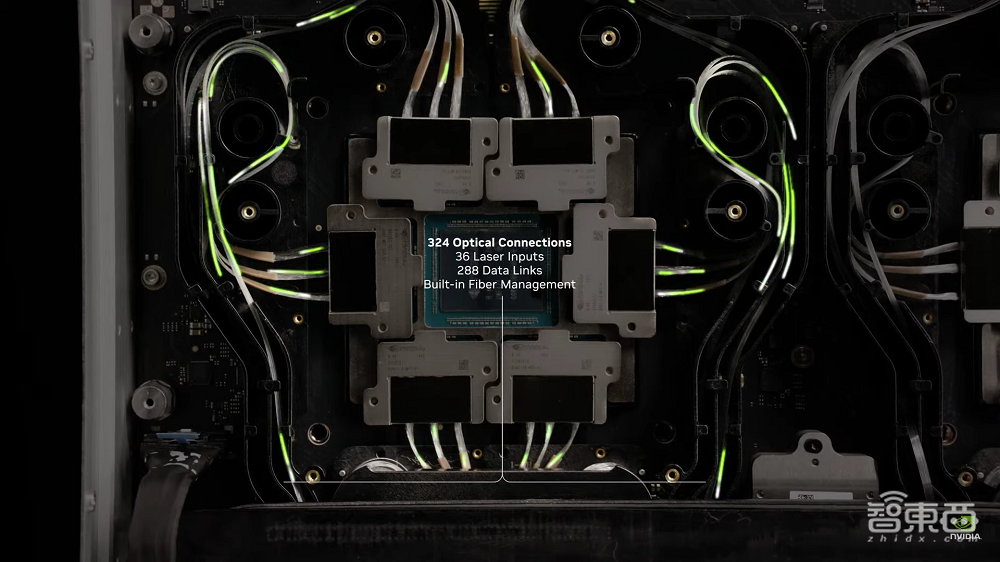

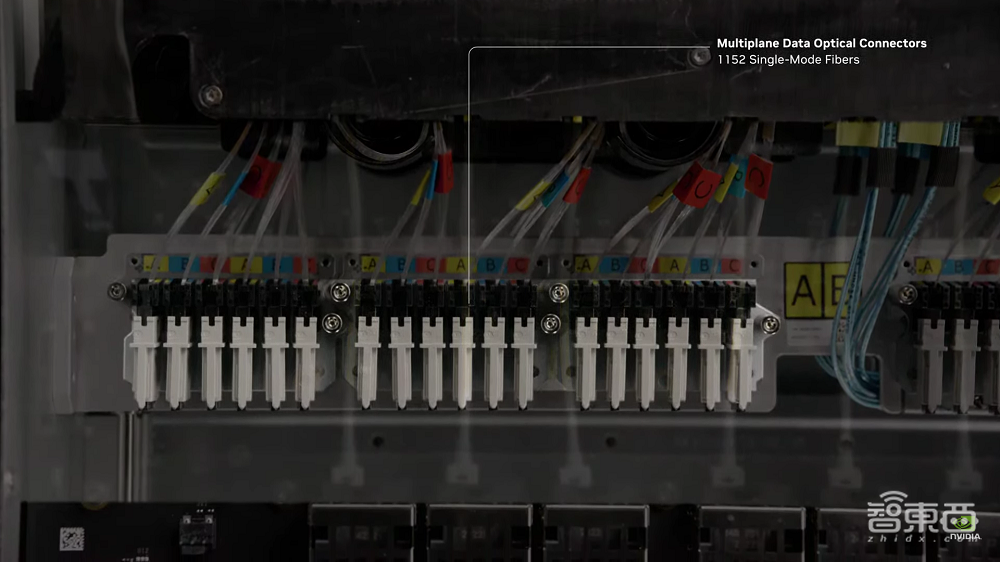

这一系统由 324 个光学连接器串联而成,其中包含 36 个激光输入以及 288 个数据连接,并且还内置了光纤管理功能。

其中,光子组件是可以拆卸的。每个光子组件都具备 3 个硅光引擎。这些硅光引擎的总吞吐量为 4.8Tb/s。

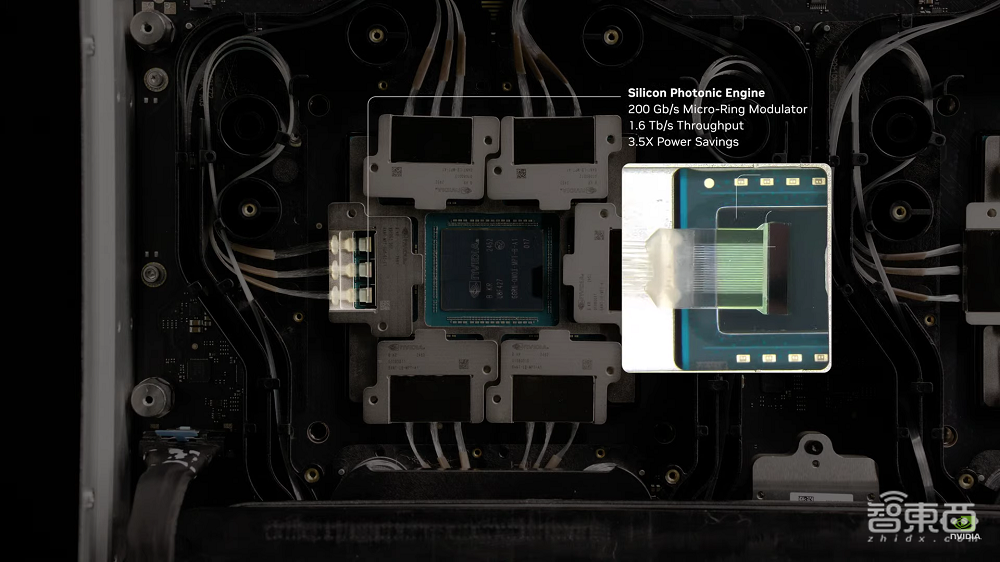

每个硅光芯片引擎具备 200GB/s 的微光调制器,其总吞吐量为 1.6Tb/s,并且能够实现 3.5 倍的节能效果。

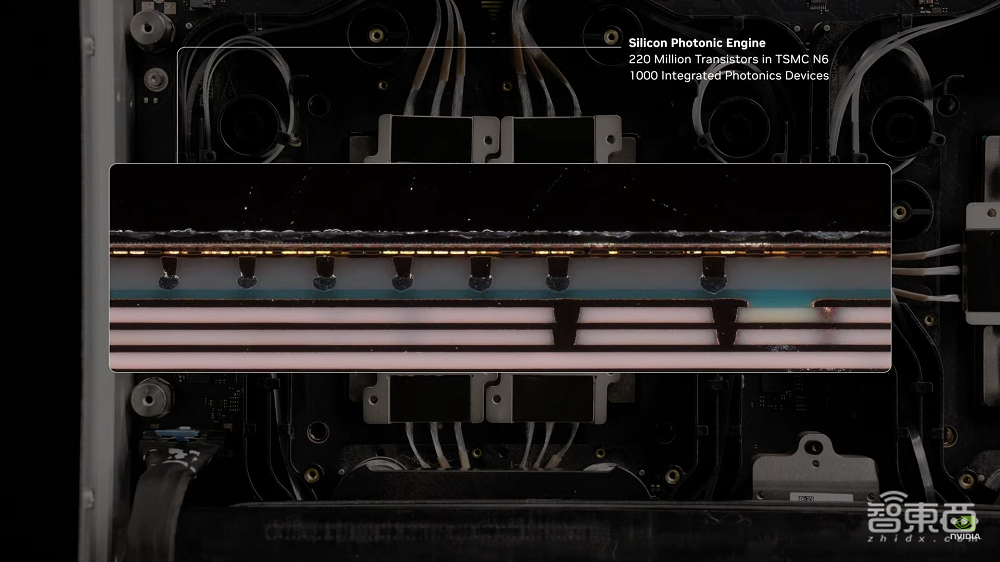

硅光引擎运用台积电的 N6 工艺。它拥有 2.2 亿颗晶体管。并且拥有 1000 个集成的光学器件。

这一系统还拥有多平面数据连接器,拥有1152个单模光纤。

这些激光系统具备能耗稳定功能。

这些部件加起来,就是下面这张图所展示的那个拥有 4460 亿颗晶体管的庞大系统,其吞吐量达到了 115Tb/s。

这些伙伴共同发明与合作,以打造集成硅、光工艺和供应链。

台积电董事长兼 CEO 魏哲家表示,台积电的硅光解决方案具备两方面优势,一是结合了先进的芯片工艺,二是结合了台积电 SoIC3D 芯片封装的优势。通过这一解决方案,英伟达能够充分发挥 AI 工厂的能力,并且有助于 AI 工厂扩展到 100 万块 GPU 甚至更多。

英伟达光技术会推动新一代先进 AI 工厂实现大规模增长。同时,它会与 Coherent、Eoptolink、Fabrinet、Innolight 等业界领先企业的可插拔光模块技术一起推动这一发展。

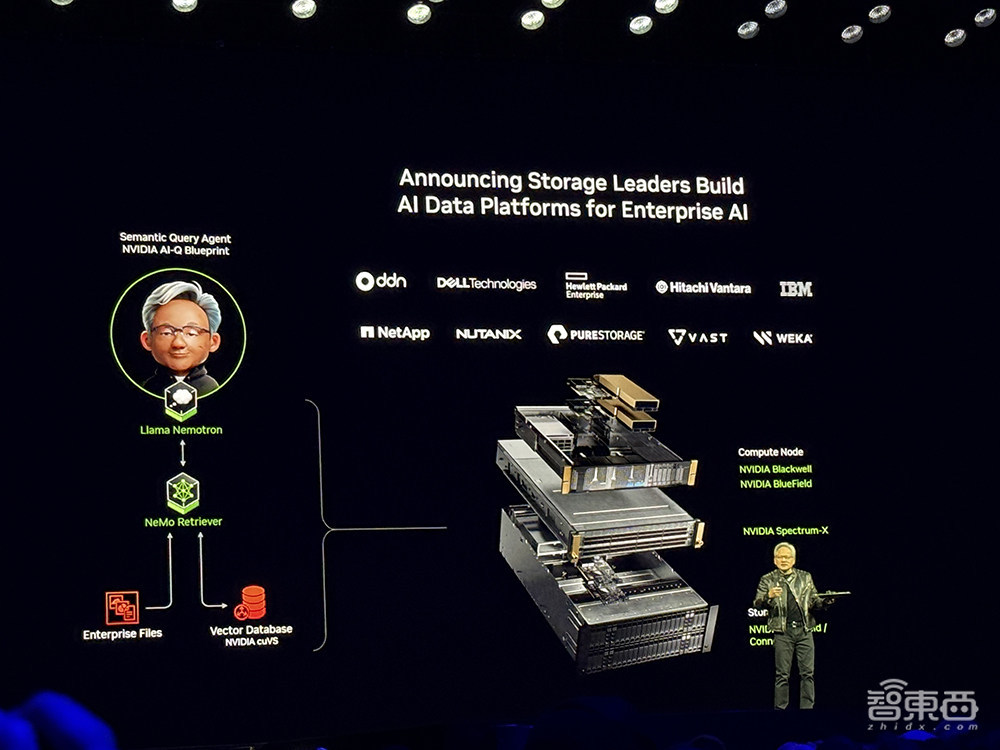

二、助建存储基础设施,让AI智能体提供更准响应

英伟达今日推出了 NVIDIA AI 数据平台。这是一项参考设计,且可自定义。存储提供商可以利用它来构建全新的 AI 基础设施。该基础设施搭载了专用的 AI 查询智能体。能满足 AI 推理工作负载的严苛要求。

这些 AI 智能体借助英伟达的加速计算、网络和软件,针对复杂查询进行推理,并且能够快速生成准确的响应,能够助力企业应用 NVIDIA AI Enterprise 软件平台,其中包括全新英伟达 Llama Nemotron 推理模型的 NVIDIA NIM 微服务,还能助力全新的 NVIDIA AI-Q 蓝图,从而近乎实时地生成数据洞察。

AI 数据平台的存储基础设施依据英伟达 AI-Q 蓝图进行开发,它具备可以进行推理且能连接企业数据的功能,是一个 AI 智能体系统。这个系统能够将专有的企业知识,像内部文档、客户记录以及特定领域的信息等,毫无缝隙地集成到 AI 工作流当中,从而提供更为准确、更贴合实际情景的响应。

它能够快速地访问大量数据,并且能够处理各种类型的数据。这些数据包含来自多个来源的结构化数据、半结构化数据以及非结构化数据,例如文本、PDF 文件、图像和视频。

AI-Q 蓝图借助 NVIDIA NeMo Retriever 微服务,能够使英伟达 GPU 上的数据提取与检索速度提升至最高 15 倍。

AI 数据平台的核心功能相当于一个智能 AI 路由器。它通过高速、低延迟网络来进行负载平衡。它还通过高速、低延迟网络进行交换提示和键值(KV)缓存。这样做是为了提高推理速度和准确性。

存储提供商能够利用英伟达的 Blackwell GPU ,还能利用 BlueField DPU ,同时借助 Spectrum - X 网络以及 NVIDIA Dynamo 开源推理库,以此来对基础设施进行优化,从而为 AI 查询智能体给予强劲的支持。

AI 数据平台对 GPU、节点和大语言模型内存管理之间的 AI 工作负载进行了优化分配。它利用智能路由、负载平衡和高级缓存来加速数据处理,还实现了可扩展的复杂 AI 工作流程。所以,AI 智能体能够更高效、更低延迟地分析和处理大量业务知识。

能够加快 AI 查询智能体访问存储在企业系统中的数据。

BlueField DPU 的性能提升幅度比基于 CPU 的存储性能最高能达到 1.6 倍,并且功耗比其降低最多可达 50%,每瓦的性能提升在 3 倍以上。与传统以太网相比较而言,Spectrum - X 通过运用动态路由以及优化的拥塞控制,能够将 AI 存储流量的提速最高提升到 48%。

WEKA 选择与英伟达合作,打造可定制化的 AI 数据平台,充分运用企业数据进行推理并响应复杂查询。

英伟达认证的存储合作伙伴正在和英伟达一同打造定制化的 AI 数据平台。英伟达认证的存储提供商打算从本月起提供基于 NVIDIA AI 数据平台构建的解决方案。

结语:AI基础设施多点布局,英伟达正不断扩大优势

从面向网络的发布以及面向存储的发布,能够看出英伟达对于 AI 基础设施趋势的布局情况以及卡位情况。英伟达经过多年的打磨,拥有丰富的网络产品组合,凭借这一组合,它在加速 AI 智能体连接数据的生态体系里占据了中心位置。

共封装光学技术的布局是着眼于长远的。从理论上来说,大规模实现硅光通信的融合,在节省能耗和成本方面具有显著的优势。然而,这项前沿技术在实际落地过程中的成熟度还需要进行验证。同时,业界也在不断探索如何以更低的成本和更高的可靠性来制造相应的光学器件。

如今提升 AI 性能和效率的关键因素不再仅仅局限于算力范畴。英伟达进行了前瞻布局,这使得它在 AI 基础设施方面的领先优势不断得以扩大。同时,它与垂直行业龙头企业的合作,进一步加深了它自身的护城河。