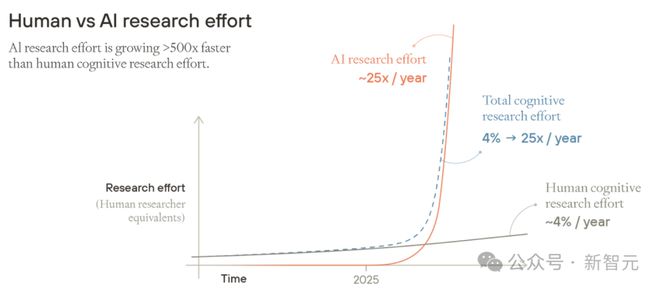

未来,AI 研究的发展速度会非常快,比人类快 500 倍。在 10 年的时间里,就能够促使 100 年的技术取得进步。

牛津教授 Will MacAskill 等撰写的这篇博文,在近期发布。此博文对未来作出了诸多令人惊讶的预测。

他们认为,即使 AI 无法实现“递归自我改进”,即使算力的扩展处于停滞状态,即使算法效率提升的速度变慢,AI 的发展增速依然能够在不到 10 年的时间里,促使达到 100 年的技术进步。

而且根据他的预测,未来AI还将高速发展——

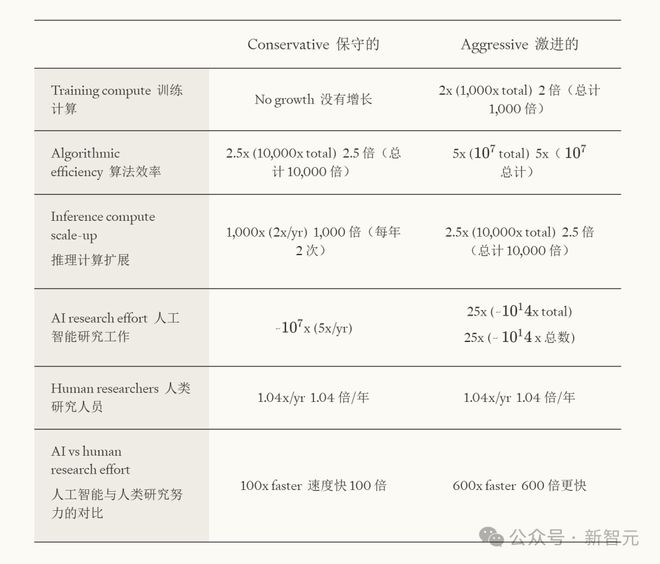

训练算力的增长空间约为 1 万倍;推理算力能够实现 1000 倍的增长;在未来 10 年,AI 训练算力、算法效率以及推理算力的乘积,将会增长 1000 亿倍(10¹¹倍)。

而到了20年后,AI的技术研发实力总体上将和人类相当。

AI 将会持续发展,之后会全面超越人类智能的总和,而人类将会遭遇前所未有的难题。

新型的大规模杀伤性武器以及 AI 赋能的专制政权等情况存在,因此,当下我们必须为 AGI 做好准备,以应对智能爆炸可能引发的各种会让人迷失的方向。

十年内,比人类聪明得多的AI就将出现

在接下来的十年内,我们很有可能会看到比人类聪明得多的AI。

如今的推理模型,已经让我们窥见了这一雏形。

那么,结果是只有两种情况吗?一种情况是我们未能对齐 AI,这样就会导致人类永久失去权力;另一种情况是我们成功对齐 AI,接着就可以利用它来解决所有其他问题。

并非如此。

AI 能够有意义地替代人类研究劳动力,其发展或许会推动极为迅速的技术进步,能够把数十年的科学、技术和智力发展压缩至几年甚至几个月。

医学取得进步,能够大幅度地延长我们的寿命。物质十分丰富,会使每个人都能像如今的亿万富翁那样生活。

一系列危险始终如影随形:要知道,谁能够控制超级智能,谁就有可能将人类接管。

会出现一个新问题:当 AI 能力已经和人类相当之后,人类需要花费多少精力去研究 AI 呢?

假设 AI 能力已经和人类相当。因为存在电力限制,所以进一步扩大训练规模这件事已经无法做到了。同时,也不存在软件反馈循环。

可以假设计算推理的增长速度比现在慢约 30%,并且效率提升的速度也比现在慢约 30%。

在此情景之下,AI 研究的工作量在达到人类水平后的十年时间里,在接下来的每一年中,都将以 5 倍的速度持续扩展。

十年内,AI帮人类实现一个世纪的进步!

在最激进的设想下,可以假设集体 AI 的能力很快就能与人类相当。同时,在扩大训练规模和推理计算方面,仍存在很大的提升空间。并且,AI 自动化进行 AI 研发确实会形成一个软件反馈循环。

牛津教授的简单模型显示,AI 研究有大约 1000 倍的增长,这种增长会在十年内带来超过一个世纪的技术进步。

保守地来看,围绕物理实验和资本的复杂性这一情况,意味着我们在 10 年内需要进一步加大认知研究的努力,且要增加到原来的 10 倍,也就是 10000 倍的增长。

当前的趋势显示,在十年内,倘若 AI 达到人类水平,那么我们将会获得 AI 研究能力的巨大增长。若计算规模停止扩展,甚至算法效率改进有所放缓,增长幅度将达到数千亿倍;若我们得到一个积极的软件反馈循环,增长幅度则将达到百万兆倍。

如果我们持续扩大 AI 规模,且没有达成集体同意来减缓速度,那么在十年内实现一个世纪的技术进步看起来是有可能的。

甚至,更加惊人的加速也极有可能实现。

AI让科技提速10倍

思考过去 100 年的技术进步情况,设想倘若这些进展都在十年内发生,那会是怎样的情形呢?

从第一次跨太平洋飞行到登月,仅仅四个月;

从曼哈顿计划到广岛长崎爆炸原子弹,仅仅三个月。

设想一下,在没有 AI 的情况下,100 年后即 2125 年,你期望能看到的技术方面的所有进步。

然后想象一下,只要10年,有生之年这些都实现了!

牛津大学的哲学家威廉·麦卡斯基尔认为,AI 能够在技术进步方面取得极大的推进作用。

即使不存在软件反馈循环(也就是“递归式自我改进”),即便算力的扩展处于停滞状态,并且算法效率提升的速度有所放缓,AI 的发展增速依然是足够快的,能够在不足 10 年的时间里推动等同于 100 年的技术进步。

趋势看起来很明显。

2019 年的时候,那时最为厉害的语言模型在说话方面都存在困难。然而到了 2023 年初,语言模型不但能够流利地回应各种问题,还掌握了比地球上任何一个人都要多得多的常识。

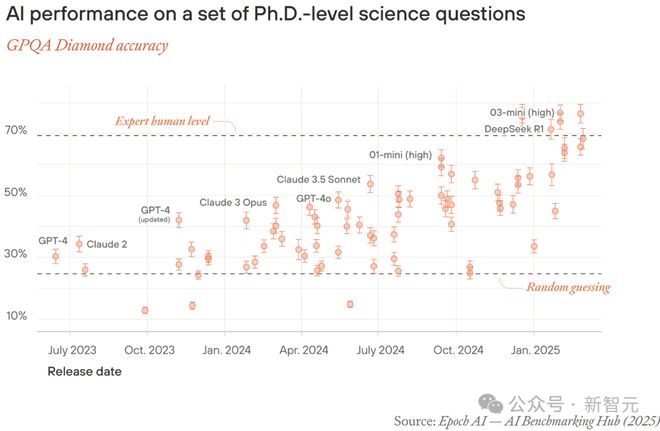

2023 年初时,在解答科学问题方面,顶尖模型的表现连瞎猜都不如。然而如今情况有变,它们的表现已经超越了博士级别的专家。

上千人集体预测:AGI将在2030年来临。

AI的算力每年增加30倍

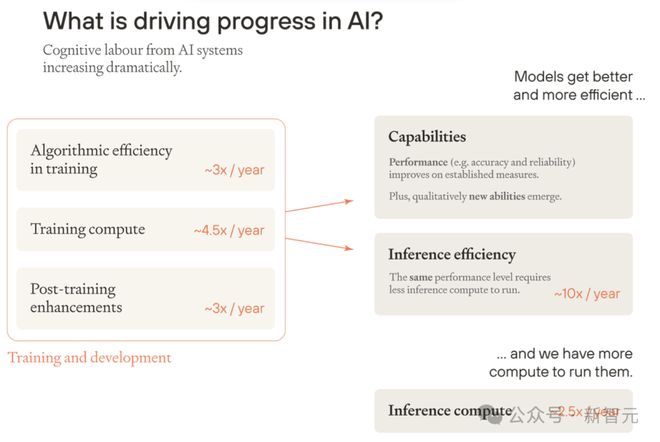

目前,训练的算力和算法主导了AI的进步:

自 2010 年起,训练运行所运用的最大算力呈现出每年约增加 4.5 倍的态势。

训练算法的效率方面,从当前的趋势来看,训练一个模型所需要的物理算力每年会减少大概 3 倍。

把两个因素结合起来了,是衡量「有效训练算力」的标准——

在没有进行任何算法创新的情形下,要达到相同的模型性能,所需要额外增加的那部分原始算力。

预训练的有效训练算力每年增加超过10倍。

此外,在工具的使用方面,研究人员引入了「训练后增强」;在提示方法方面,研究人员引入了「训练后增强」;在合成数据方面,研究人员引入了「训练后增强」;在创造性的生成方式方面,研究人员引入了「训练后增强」;在选择答案的方式方面,研究人员引入了「训练后增强」;在各种其他方面,研究人员引入了「训练后增强」。

Anthropic 进行了非正式的估计,经过训练后,目前每年的效率提升达到了 3 倍。

因此,就最先进的 AI 模型能力来讲,训练算力每年的增长幅度超过 30 倍。

训练规模不断增大且越来越好,AI 模型在质的方面有了不断的进步,其表现形式既微妙又令人惊讶。

为什么AI总体上能比人类聪明?

目前,全球的整体研发投入增长缓慢,年增长率不到5%。

AI 在认知劳动方面的增长速度很快,比人类快了很多,具体快了 500 倍。

这种趋势很可能会持续,直到AI的认知能力超越所有人类。

AI研发效能和人类认知研发效能增长速度比较

所以,当 AI 的认知劳动总量开始和人类的认知劳动总量一样多时,整体认知劳动的增长率会大幅度提升,进而使技术进步加快。

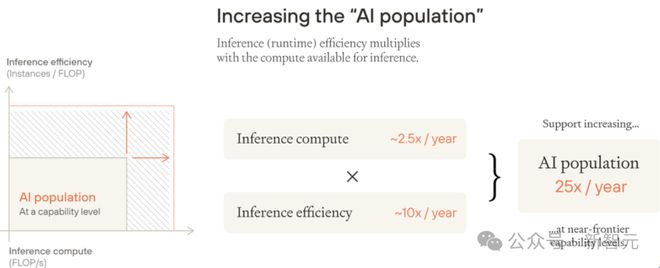

运行效率提升以及可用推理算力增加,这并非白日做梦。这种情况能让“AI 总量”每年增长约 25 倍。

当有效训练算力大约翻倍时,推理效率会提高,相应的推理成本大致会减半。目前有效训练算力每年增加的幅度约为 10 倍。

推理算力:用于推理的算力增长速度大约2.5倍/年。

这些变化意味着,所有的 AI 性能都会得到明显提升,而不只是最先进的 AI。

假设当前趋势继续发展,直到AI与人类科研投入大致持平。

假如 AI 研究员的数量和人类研究员的数量一样多,那么技术研发效能的增长速度会有怎样的变化呢?

假设训练进步完全等同于推理效率的提升,并且更多的推理计算是用于运行更多的 AI。

现在可以看到,推理效率的提升情况大致与有效训练算力的提升情况相同。推理效率每年大约能增长 10 倍,而推理算力每年至少会增加 2.5 倍。

因此,如果当前趋势得以持续,直至 AI 研发效能与人类科研投入达到相当的程度,那么 AI 研发效能估计会继续保持增长态势,且增长速度每年至少为 25 倍。

即便如此,这也低估了AI研发效能的增长率。

并没有考虑到至少在 AI 能力提升超越人类水平时,AI 研发效能会增长得有多快。

为了理解这一点,我们可以看一下人类研究员:他们在大脑体积方面的差异相对较小,在文凭方面的差异也相对较小。

但在某些领域,杰出的研究员的生产力可能是同行的数百倍。

没有考虑到训练后增强所带来的每年提升 3 倍的有效训练算力。这种提升能使年增长率从 25 倍提升到 75 倍。

结合考虑,AI研发效能的增长率可能远超这一数字。

AI究竟还有多大进步空间?

规模化和效率提升的趋势,还能持续多久?

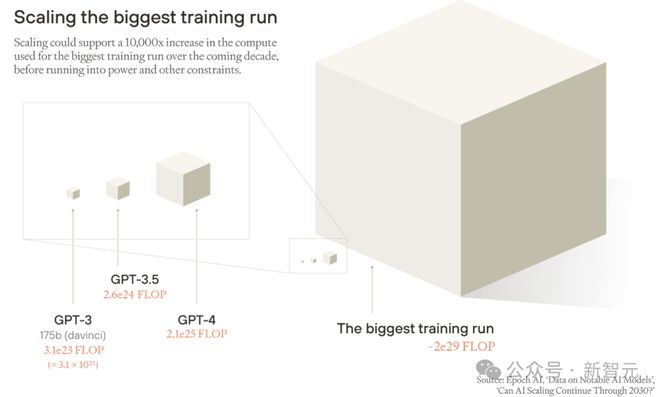

训练算力方面:规模最大的训练任务,其增长空间约为 1 万倍。并且很可能在未来十年内实现这一增长。

之后因为电力等方面的原因,很难再实现增长。即使能够突破电力方面的限制,芯片的产能、数据的稀缺性以及硬件的延迟也会成为新的限制因素。

训练算法效率方面,如果维持算力扩张与效率提升的当前比例,那么训练算法效率还能够提升 1000 倍。

这表明在未来十年,有效训练算力将会比现在增加 1000 万倍。也就是说,每年大约会有 5 倍的有效算力提升。而目前每年的增长速度是≥10 倍,所以未来十年的增长速度低于目前的增长速度。

在推理算力方面,我们可以合理地推测,在同一时期,推理算力将会实现 1 万倍的增长,并且会保持每年 2.5 倍的增速。

保守估计的话,如果 AI 的进步仅仅依赖规模的扩张,而不突破其他的维度,那么通过测算规模的上限,就可以推知 AI 的研发效能。

未来十年,AI 总体研发效能,也就是训练算力、算法效率以及推理算力的乘积,将会增长 1000 亿倍,即 10¹¹。并且年均增速会略微超过 10 倍。

哪怕十年内在物理层面遭遇瓶颈,但算法的进步却可能大幅提速。

AI 模型自身有可能促使软件技术得到显著改进,其中包括 AI 算法的改进、数据处理的提升以及训练后强化等方面。

这会催生出更为强大的 AI,接着会推动算法继续向前发展,从而形成软件的反馈循环,让 AI 的能力能够持续提升,并且不需要额外投入物理资源。

不过,并非必然会出现软件反馈循环。

多数新技术最多只能起到提升研究员生产力的作用,难以推动自我维持式的进步。从理论方面来说,AI 也有可能遭遇类似的情形。

即使“数字机器学习(ML)研究员”可以替代人类研究员,进展或许也会变慢:第一代数字 ML 研究员或许能使下一代 AI 研究员的表现提升一倍,然而第二代可能仅仅提升 1.5 倍,依次类推。

最终,进步只是短暂性的,而且随时间逐渐速度还在下降。

要实现快速且持续的发展,就需要投入翻倍,同时产出也至少要翻倍,并且这种情况需要重复多次。

然而,从软件领域的经验估算来看,认知投入(研发效能)如果翻倍,一般能够让软件的性能或者效率提升超过一倍。所以,有理由去认为,由 AI 驱动的软件反馈循环,是很有可能促使 AI 性能与效率加快提升的。

当然,反馈循环无法无限加速,软件反馈循环最终必然趋于饱和。

但当前算法效率,远未达到理论上限。

大语言模型(LLM)的学习效率经计算约为人类的十万分之一,这里是以成年人大脑的计算能力作为参照的,并且这一上限很有可能远远超过人类大脑的效率。

所以,若成功构建软件反馈循环,在十年内,AI 能力或许能让有效训练算力增长到 100 万倍。能实现约一万亿倍(10¹²)的有效训练算力增长,也能使推理计算与有效训练计算的乘积增长至 10¹⁶,即每年大约增长 40 倍。

并且它仍具有极大的提升潜力。

20年后,AI与人类平起平坐

在未来二十年内,AI研发投入量将等于人力研发投入。

这意味着AI系统可以共同执行几乎所有与研究相关的认知工作。

而这些工作,以前只有人类能完成。

规模化驱动了很大的进步。甚至在未来十年,AI 有可能接近人类认知。这种情况会在规模扩展遇到电力和其他实际限制之前发生。

即使规模化的速度显著放缓了,算法的进展依然有可能促使 AI 继续向前发展。

无论如何,AI与人类在认知上平等,可能只是几年之遥。

为了验证这一点,可以直接看看AI能力的提升情况。

GPT-4 在博士级科学问题的基准测试 GPQA 中的表现只是稍微比随机猜测好一些。18 个月过后,最为优秀的推理模型已经超过了博士级的专家。

不同模型在博士级GPQA Diamond基准测试上的准确率

这种发展十分迅猛,极有可能催生出一种 AI,其能力超越人类的顶尖研究者,并且这种 AI 几乎能覆盖所有关键的认知领域。

未来五年内,训练算力扩展若不能达成目标,预训练算法效率会提升,后训练增强技术会进步,推理效率会提高,推理算力会增长,这些仍将推动 AI 研究不断向前,突破物理扩展受限和训练数据不足的阻碍。

所以,难以确切预估时间。然而,在未来几年,AI 很有可能达到人类顶尖研究水平,甚至超越它。

AI研究总量指数级增长

AI 的总体研究能力会呈指数级增长,前提是超越了人类顶尖研究水平。

可以想象,起初或许会有大概十万名与人类专家级别相当的 AI 研究员出现。

其中,多数可能会将精力集中于对下一代 AI 的优化,或者投身到其他能带来丰厚回报的科技领域之中。

随着有效计算能力得以提升,同时推理算力也在增加,认知投入有很大可能会呈倍数增长,并且会迅速超过大约一千万在职的人类研究员。

超过了全球八十亿人口的认知总和。之后,总体能力会持续不断地翻倍增长。

实际上,特定领域的 AI 应用早就展现出了推动作用,且这种推动作用超越了新增的人类研究员。

谷歌 DeepMind 的 AlphaFold 已经成功预测出数量超过 2 亿种的新蛋白质结构。

人类的话,即便有 100 万的研究员,也需要耗时多年去做实验才能完成。

通用型 AI 不会被人类研究员的技能所局限,并且会持续不断地进行开拓与创新。

AI能比人类强多少?

这取决于两个关键的方面:一是当前 AI 能力与人类水平之间的差距;二是持续且快速提升所具有的整体潜力空间。

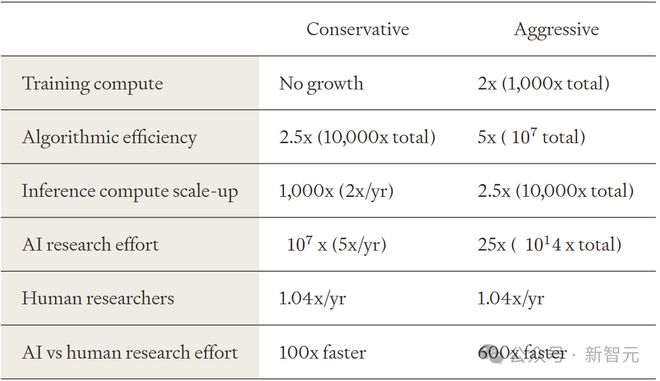

保守的预测是,在达到人类水平之后的十年时间里,AI 研发效能将会保持每年平均 5 倍的增长速度。

假设 AI 能力达到了人类水平,然而训练算力却因能源限制而无法继续扩张,并且不存在软件自我迭代的正反馈循环。与此同时,推断算力的增长以及算法效率的提升速度相较于当前而言,大约放缓了 30%。

激进的预测是,AI 的集体能力在短期内能够达到人类水平,不过这需要满足两个假设条件:

扩展空间充足:训练算力与推理算力仍存在巨大提升空间

正反馈循环形成:AI自动化研发切实产生软件自我迭代效应

人类岔路口

一般来说,技术进步使生活变得更好、更轻松。

但它常常会带来一些重大的挑战,例如:存在核武器这种威胁;有监控技术方面的问题;面临着气候变化的状况;还有工厂化养殖所带来的恐怖之处。

而且错失了很多弥补的机会,就像当初对待核能那样。

也就是说,技术带来了诸多“重大挑战”,这些挑战就如同人类进步道路上的岔路口。

由AI驱动的技术变革将带来许多新的重大挑战。

首先,部分人可能会指挥AI帮助他们获取并巩固特权。

AI还可能赋能或扭曲集体推理。

AI 很有说服力,它有可能找到并传播像病毒一样的观念,也有可能给提问者提供那种“为了达到目的,什么手段都可以用”的类似马基雅维利式的建议。

更有可能的是,AI将增强人类的推理能力:

超级智能ASI,可以指导人做出最重要的决策;

AI超级预言家,则能让人对未来有更清晰的预见。

确保能够真正借助 AI 来帮助人类,进而做出更好的决策,这在加速技术变革的时期将会是做出正确决策的关键所在。

还将面临一个问题,那就是如何与 AI 系统共同存在。同时,AI 系统将会迅速超越全球的总人口数量。

同时,会存在关于外太空治理的问题,包括如何管理在太阳系内对资源的争夺竞争,以及甚至如何去开拓新的恒星。

在AGI出现后,这一切变得更加容易。

AI 进步可能带来的收益十分惊人。它能带来物质上的丰盈,甚至连今天的亿万富翁都会心生嫉妒。

这提供了能够当下达成的协议,让每个人的生活都比当下更好。

这样每个人都能分得这块巨大的未来蛋糕。

AI 若抓住这个机会,能够在民主方面为人类提供有意义的帮助。

AI 能够实现自动化的政策分析以及做出良好的判断,并且可以帮助我们更好地对其他挑战进行思考。

但是,如果可以让超级智能与人类保持一致,那么难道不可以借助它来处理其他问题吗?难道我们能够拖延准备工作吗?

在许多情况下,这是正确的。

但并不总是如此,原因有三:

在拥有对齐的超级智能来帮助人类之前,许多挑战就已经出现了。

一些机会窗口会提前关闭。

需要确保超级智能能在正确的时间,给正确的人提供帮助。

参考资料: