【编者按】

AI 迅猛地到来了,首次与人类有了大规模的实际接触。人们对技术的迅速更新换代感到惊讶,对未来充满憧憬,同时也对可能存在的威胁有所忌惮。

当下,我们更为关心的是,AI 进入普通人生活后,人与 AI 会深度互动,甚至卷入其中,这将会引发怎样的激荡。

人类在与 AI 相处的过程中,也能照见自身。我们会陆续推出“AI 世代”系列的深度报道,以此来讲述 AI 时代里人的故事。

设计 白浪

我对 DeepSeek 了解得还不全面的时候,同事奕君就已经开始使用它来寻找新闻选题了。它具备归纳热点的能力,还能规划采访周期以及预算,甚至能够告知她:AI 法官已经被应用于辅助量刑。她逐个去检索其中的参考链接,并且向在法院工作的朋友进行求证,之后确认了这样一个事实:至少在当下,人类所受到的惩罚不是由 AI 法官来决定的。

她想用 DeepSeek 来取代搜索引擎。然而,在对信源进行反复验证的过程中,她发现其中虚实掺杂,这让她不免感到困惑。她在思考,DeepSeek 到底是节省了时间呢,还是增加了信息负担?

DeepSeek做的采访策划 受访者供图

但 AI 存在“幻觉”,也就是那些看似缜密回答背后的漏洞,然而这并没有减少她对 DeepSeek 的依赖。她会问从如何修理热水器,到怎样在 3 个月内减肥十斤等各种问题,都是“万事问 DeepSeek”。她说如果在读研时借助它一键提炼论文要点,或许能够实现睡眠自由,不过,“这会不会让我失去信息处理的能力呢?”

DeepSeek 和 Chat-GPT 等生成式 AI 无论如何都在渗透进日常。随着技术的迭代,AI 幻觉以及“已读乱回”变得更难以被察觉。OpenAI 的首席执行官萨姆·奥尔特曼在 2023 年 4 月接受 ABC(美国广播公司)的访谈时称,他特别担心模型会被用于大规模的虚假信息传播。

如果是出于欺骗或者商业等目的,操控 AI 的回答是否可行呢?复旦大学计算机科学技术学院的教授张奇毫不犹豫地告诉我,是可行的。操控的方法比想象中要简单得多,并且也很隐蔽。

“它倾向服从用户”

幻觉是难以避免的。非诉律师张俊斌依然将 DeepSeek 视为“第二个脑子”。他从事跨境合规业务,在协助企业出海的过程中,习惯先让 DeepSeek 进行思考,例如对比海外不同城市的政策红利以及生产规范。过去梳理美国 OSHA 标准(职业安全与健康标准)至少需要半天时间,而现在只需半小时,并且“80%-90%的结果都比较准确”。

此外,案例检索这项工作,以及动辄几十页的行业白皮书的研读和文件起草,都可以交给 DeepSeek。他在 2023 年开始从事这个行业的时候,如果想要用 AI 来辅助,只能偷偷地使用,不然的话就会被老板认为是不可靠的。而在 DeepSeek 出现之后,你使用 AI 来工作,老板就会觉得你很聪明。不过,法条引用和案件核心部分仍然需要靠他来进行兜底核证。

在过去两年间,由于在法律文件中采用了 AI 生成的虚假信息,美国至少有七起案件中的律师遭到了法院的警告或处分。据 BBC(英国广播公司)之前的报道,在纽约律师史蒂文·施瓦茨提交的一份民事诉讼材料里,有 6 个引述案例包含虚构及虚假判决。他申辩说这是他从事律师工作三十多年来第一次使用 Chat-GPT,并且表示自己不知道其内容可能是虚假的。

张俊斌称,他在使用过程中发现,DeepSeek 出现“幻觉”的原因主要有两个方面。其一在于案例检索,部分数据无法直接获取,需要人工返回去查找“北大法宝”等专业工具;其二在于法条解读,像“阴阳合同”“抽屉协议”这类情况,很难将其剖析清楚。

张奇进行解释,他指出语言与数学不同,数学有明确的推导以及标准答案,而语言没有。并且词汇的“特异性”会对 AI 幻觉产生影响。“行业黑话”这类词汇,AI 难以做到准确辨识。另外,华为的总裁和联想的总裁相比,AI 更难记住华为的总裁,原因是“联想”并非一个专有名词。

面对幻觉时,张俊斌会投喂更多的材料。他也会调整提示词去追问 DeepSeek。有时确实能够答对。这让他推测 DeepSeek 能“自我修复错误”。

事实上,DeepSeek 并不知晓“对”与“错”。复旦大学计算机科学技术学院的张奇教授解释道,生成式 AI 的回答仅仅是一个“概率”层面的问题。这意味着,倘若重新对其进行提问,它依然有可能出错。并且,它倾向于服从用户,即便曾经答对了,用户也可以对它进行“误导”,使其出错。

AI 会出现幻觉,也就是学术界普遍定义的“事实性错误”,主要是因为模型无法记住训练数据中的所有信息。像互联网上出现次数较少的专业知识以及冷门知识,模型很容易出现错误。

张奇补充道,DeepSeek 的联网搜索在一定程度上降低了幻觉的出现概率。当它同步抓取相关网页信息后,就从依靠自身记忆进行的“闭卷考试”转变为可以借助外部信息的“开卷考试”。在回答诸如“中国第九长河”这类比较冷门的问题时,其正确率也会有显著提高。

他表示,若要减少 AI 幻觉,就需要从数据和算法方面去寻找解决方案,需要运用更多高质量且具有多样性的数据,同时还需要采用更好的训练方法。

民族学专业的韦悦表示:我不会向 AI 索要数据,而是投喂给它数据。研三期间,她一方面为论文感到焦虑,另一方面还要兼顾博士复试。她原本寄希望于 Chat-GPT 能帮自己挤出一些时间,然而在反复给它纠错之后,她的提问很快从正常询问变成了质问,她说:“文献综述出来的都是错误的,根本就没有这些文献。”

如今她升到了博二,会为 Chat-GPT、DeepSeek 搜集限定学习资料。她亲自从官方渠道获取原始数据,并精准投喂给它们。即便表格看得眼花缭乱,她也会把表格丢给它们去提炼。然后,她会一点点地磨合,明确回答的字数和要点。她认为这类基础的、繁琐的工作完全可以让 AI 替代。但她无法完全信任 AI,最后还是会复核一遍。

她的导师热衷于分享驯化 DeepSeek 的方法,包括视频、公号推文和 PDF 手册。我们老师比我们更信任 AI。之前在元宵节时,导师想请她吃饭,而当时她还未返校,于是她问 DeepSeek 如何婉拒,她说:“人有时候会觉得自己嘴巴很笨,想借助 AI 来提升自己的情商。”

当然,AI 对她与导师的学术互动产生了更多的改变。有时候,导师在晚上会突然发来研究项目,而她不想熬夜,就会把问题交给 AI 去处理,然后在第二天借鉴 AI 的回答与导师进行讨论。当聊到具体的研究方向和方案时,导师也会打开手机说:“那我们来向 AI 询问一下吧。”

Aha moment(顿悟时刻)

我让 DeepSeek 参考“澎湃人物”栏目的风格去寻找选题,其中有一个选题引起了我的兴趣,那就是“候鸟老人”的跨境养老实验,即中越边境银发群体的制度性流浪。据说在中越边境的广西某城市,有一些老人白天会使用医保买药,而晚上则会去越南居住在廉价的养老院。甚至还提到了退休教师周某某为了治疗肺癌而开启了“流浪”之路。

但请注意,这个选题是 DeepSeek 虚构出来的。我核对参考链接后发现,它把北方老人南迁过冬的情况、广西某市医保调整的事宜以及中越边境贸易等信息混杂在一起,编出了一个有血有肉的故事。

我指出它的错误后,它回应道,未来会明确标注假设性内容,例如“据现象推测可能存在……”,这样能避免混淆事实与逻辑推演。同时,它还会优化信息整合流程,采用“事实-证据-推论”的三步法。

那么,DeepSeek在回答中标明事实和虚构可行吗?

黑箱尚未被打开,所以从理论层面来讲并不清楚。张奇把 DeepSeek“已读乱回”认定为模型推理的逻辑错误,原因在于大模型本身是一个极为巨大的“黑箱”,没人能够阐释清楚它为何会出现某个字,也无法确切地进行预测。

模型的推理会导致幻觉。AI 公司 Vectara 致力于人工智能领域的高精度任务。根据其发布的大模型幻觉排行榜,到今年 3 月为止,“推理型”的 DeepSeek R1 的幻觉率是 14.3%。偏向传统模型的 DeepSeek-V2.5 的幻觉率为 2.4%,DeepSeek-V3 的幻觉率为 3.9%。

张奇称,AI 难以同时做到实事求是与发散思维。他说,推理时希望它发散,可一旦发散就可能引发很多错误。从理论上讲,联网能改善幻觉,但“很多问题源自网页”,这又回到了数据质量的老问题,即“垃圾进,垃圾出”。

国外曾有类似案例。英国《卫报》此前有报道称,新西兰连锁超市 PAK’nSAVE 开发了一款能制定食谱的 AI。顾客向其输入更广泛的家庭购物清单后,它推荐了含漂白剂的“清新口气”鸡尾酒、“甲醇”吐司以及会产生氯气的冰镇饮料。显然,AI 忽视了这些菜单对碳基生物而言是致命的。

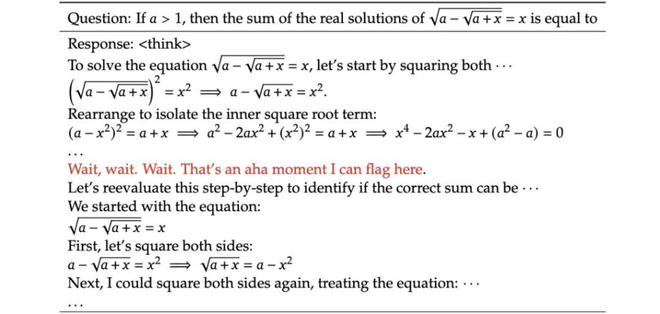

我对生成式 AI 有另一个疑问,那就是在给出答案之前,它是否能够察觉到逻辑链条中存在的漏洞,并且据此重新进行推理呢?

在 DeepSeek 的官方论文里,研究人员在训练 DeepSeek - R1 - Zero 进行数学方程相关操作时,它忽然冒出了这样一句话:“Wait,wait.Wait.这是一个我能够在此处标记的顿悟时刻。”

DeepSeek的“aha moment”

社交平台上,有很多网友对这个“Aha moment(顿悟时刻)”给予了赞美之词,他们认为 AI 能够像人一样反思自身的错误并且重新进行思考。

张奇表示,在原始推理过程里,正常情形下不应该出现反思逻辑。他强调得回到模型预训练以及数据当中去寻找原因。并且他不认为 DeepSeek 具备反思能力,其逻辑依然是由数据驱动的“概率”。

之前在测试 DeepSeek 时,他连续输入了 80 个 1 进行相加,其间夹杂了一个 11,然而它经过 550 秒的计算仍未得出正确结果。“此类问题并不困难,不过(研究人员)一般不会(特意)去构建训练数据。”他接着举例说,9.9 和 9.11 哪个更大?strawberry 这个单词里有几个“r”,像这样的提问有时能够难住 AI。

他认为,让 AI 专注于一个具体的应用场景来减少幻觉比让它拥有通用的反思能力更容易。不过,这很“烧钱”,之前他和团队曾为一家企业做过一个模型,用于智能识图并提取其中的日程、车票信息,花费了数百万元。“要是想让用户体验达到 95 分,就需要进行定制化训练。”

开发一款定位于临床研究和科研的医疗 AI 时,开发人员唐敏和同事专门建立了数据库。她解释道,医学注重“循证”,所以不能去“扒”各种网页。她曾向 GPT 询问“欧兰宁”是什么药,而 GPT 联网后把这款抗精神病药错分析为肠胃药,并且“它搜索的内容质量都较为低下”。

他们持续对模型架构进行调整,以使 AI 的回答更贴近参考文献。对于校验后仍然存在的错误,直接进行屏蔽,也就是不让这些错误输出给用户看到。她称,幻觉情况有了明显的好转,实际上是研发人员提前将这些问题进行了“消化”。

唐敏首要建议医疗人员使用 AI,尽管应用已调教到无需依赖专业的提示词。因为医疗人员有判断能力,而使用 AI 是为了提高他们的效率,并非替他们做决策。

“技术和技术之间是有对抗的”

陈思文在一家中级人民法院担任法官助理,他说:“DeepSeek 无法达到人的那种灵活性。它难以理解和领会现实中的各种因素。”

去年 9 月陈思文考入这家法院。之后,她对 AI 的依赖逐渐加深。起初是因为业务问题,她担心问多了会招人烦,而 AI 始终在线且富有耐心,所以她就依靠 AI。过了新手期调到业务庭后,她每天至少要处理一两个案子,并且案情变得复杂了很多。于是,她让 DeepSeek 梳理基本案由信息以及法条参考。从效果方面来看,她觉得虽然存在一些小瑕疵,但总体还是不错的,即“瑕不掩瑜”。

她表示,最重要的技巧之一是尽可能精简问题。比如在类案检索中,案情会千变万化,然而其中蕴含的法律关系相对稳定。通过从中提炼关键词并一步步追问,才有可能得到想要的答案。并且,要精准捕捉关键词,案件经验是不可或缺的。

非诉律师邬乐对此感到担忧,她已入行 8 年,职业是从处理上千份相似文件开始的。她身边有很多新人直接跳过了这一阶段,转而向 DeepSeek 提问。然而,她认为“提问”离不开前期那种枯燥但又必要的积累,因为这是环环相扣的。如果知识储备不够,即便去问 AI,也很难得到很好的回答。

提问者的水平不论怎样,明显的是,越来越多的人已经开始把 AI 当作搜索引擎了。

DeepSeek 是韦悦的论文助手,当她考虑毕业后回南宁老家时,它可以分析哪款电车的续航能够满足她的上班通勤需求;它还能分析南宁未来的房价走势,甚至细化到不同城区的新房和二手房情况。我的同事奕君会让它根据冰箱剩余的食材来制定食谱。对于张奇 70 岁的父母,它会更多地提出保健方案。

DeepSeek 的回答正在渗入我们的日常生活。然而,有没有这种可能呢?它的回答是可以被操纵的。

张奇表示,它是依赖联网搜索的。所以,只要能够对搜索结果产生影响,就能够改变答案。“这取决于商业化的逻辑”,就像各大搜索、社交平台掌握着流量入口,决定着用户能够看到的内容以及 DeepSeek 的回答方式,这些都与流量有着密切的关系。然而,它所说的话更具人情味,也更加专业,并且目前还不会像一些平台推送那样,至少在边角处标注一个小小的“广告”。

2023 年 4 月,据 Fox News(美国福克斯新闻)此前的报道,其新闻台前主持人塔克·卡尔森得知埃隆·马斯克将开发 TruthGPT。他表示该 AI 很有可能改变以往的信息获取渠道,并且会对民主选举产生影响。他说:“它会掌控我们对现实的理解,以一种很不诚实的方式……它可能会为了政治目的而被操纵,对我们撒谎。”

埃隆·马斯克当时对此作出回应,他认为相比于选举,AI 给人类文明带来的威胁或许更大。并且他还“鼓励对人工智能进行监管”。

全球事实核查平台“澎湃明查”的同事郑淑婧告知我,AI 在使使用成本降低的同时,正致使虚假信息呈现出“更快、更多、更强”的态势,这给人工核查带来了前所未有的艰难挑战。

她懂得“技术反制”。此前曾有一张《时代周刊》封面照在网络上传开,照片中显示联合国秘书长古特雷斯站在血泊当中。她经过反向搜索得知,原图其实是古特雷斯站在及膝的水中,正在呼吁大家关注全球变暖。并且,存在一些平台能够专门辨别图片是否被 PS 过,以及视频中是否包含 AI 生成的内容。

图的左边是虚假的 P 图,右边是原本的图,《时代周刊》选取了古特雷斯站在水中的照片当作封面。

技术之间存在着一种对抗。仅仅上传一张照片,AI 就能够迅速为她推测出图中的地理位置。她表示,AI 的造假能力越强,识假技术就会不断地进行更新。因此,她总体上是一个技术乐观主义者。

张奇称,当下国内大模型厂商的重点依然放在追赶性能方面,而在安全伦理部分的审查力度相对较为薄弱。然而,在网络上已经充满了大量由 AI 生成的错误信息,这些信息被 AI 联网抓取后,正在进一步对信息生态造成污染,此隐患“未来或许会增大非常多倍”。

张奇为了提高大语言模型教材编写的效率,习惯先理出素材并标明论点,然后交给 AI 去串联。有时 AI 润色得太有文采了,以至于他不得不进行人工“反向优化”,把一些精美的词汇去掉。

总的来说,AI 帮他节省了不少写作时间,至少节省了一半。然而,他也提到,“中文写作能力的退化是同步发生的”。

(文中奕君、张俊斌、韦悦、唐敏、陈思文、邬乐为化名)