就在刚刚,每年都备受瞩目的斯坦福AI指数报告,重磅发布了!

斯坦福大学以人为本 AI 研究员发布了这份报告,这份报告代表着对每年 AI 领域最核心和前沿动向的总结。

今年,这份报告长达456页,抛出不少惊人观点。

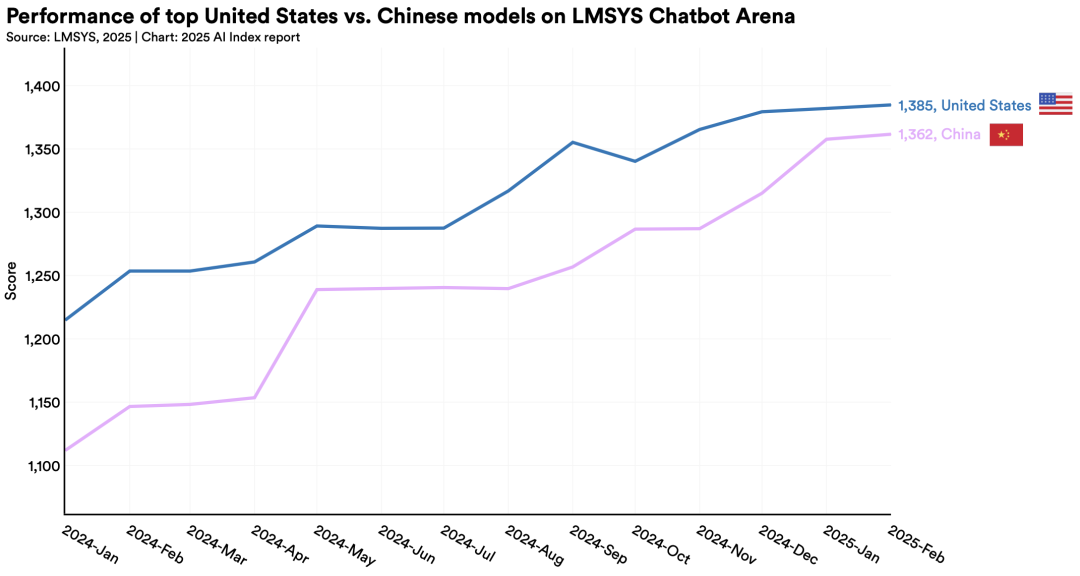

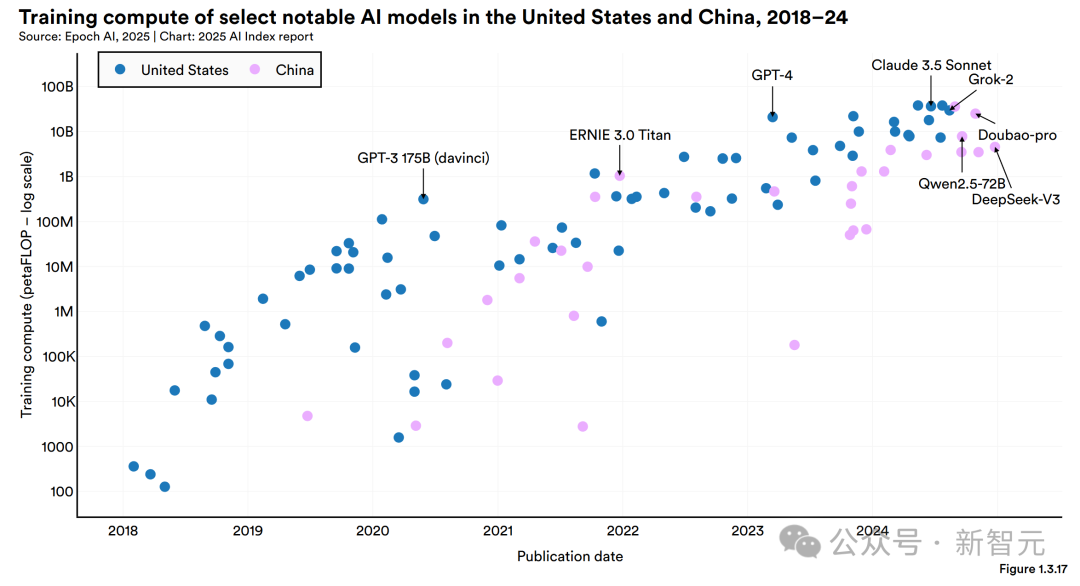

如今是 2025 年,中美顶级 AI 模型的性能差距已缩小至 0.3%。而在 2023 年,这一数字还是 20%。中国模型正快速追赶美国的领先地位。

DeepSeek 领衔的开放权重模型,以 1.7%的差距对各大闭源巨头形成压力。前者与后者的差距,从 2024 年的 8%缩小到了 2025 年的 1.7%。

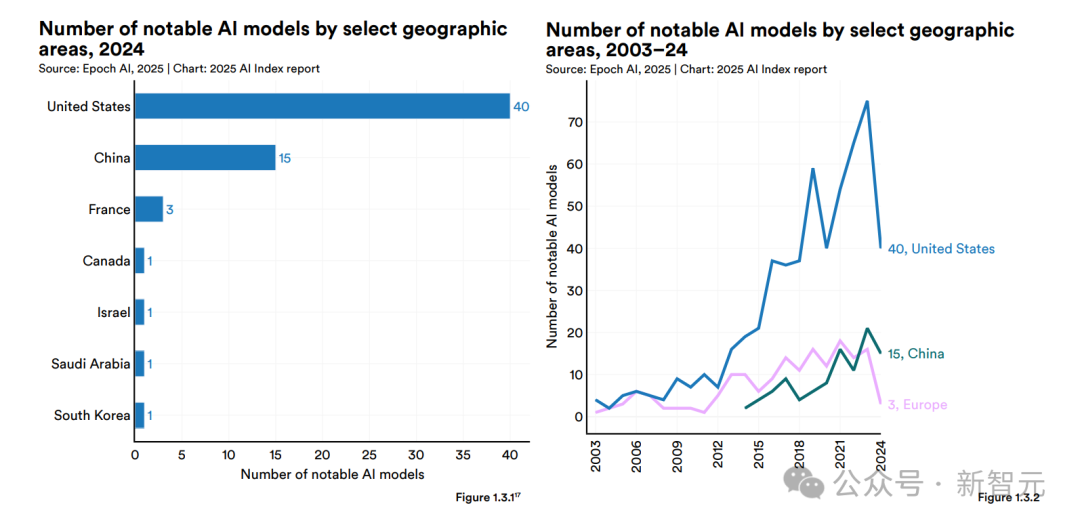

目前从行业主导企业的角度来看,美国在这方面是领先于中国的。在 2024 年,有 90%的知名 AI 模型是由企业所拥有的。其中,美国拥有 40 个这样的模型,而中国则有 15 个。

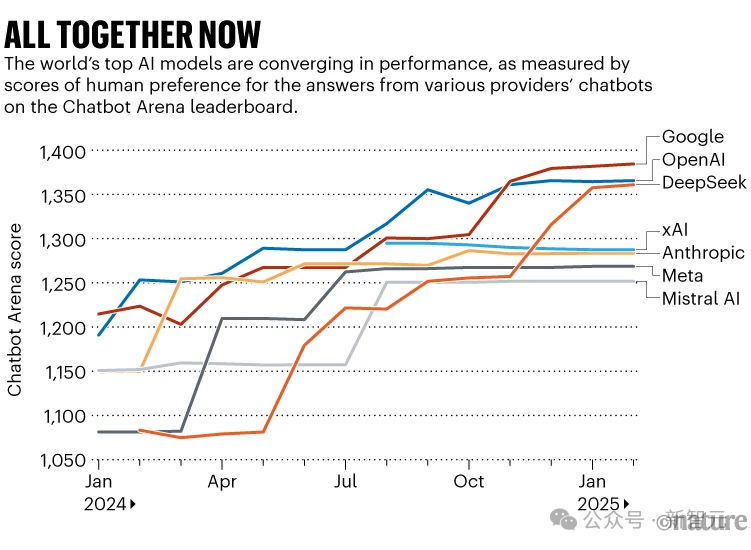

如今一个更明显的趋势是大模型的性能已趋同。2024 年时,TOP1 和 TOP10 模型的差距可达 12%,然而如今,它们的差距在不断缩小,已锐减至 5%。

十二大亮点

斯坦福 HAI 的两篇最新博文中,将 2025 年 AI 指数报告的十二大亮点进行了浓缩。

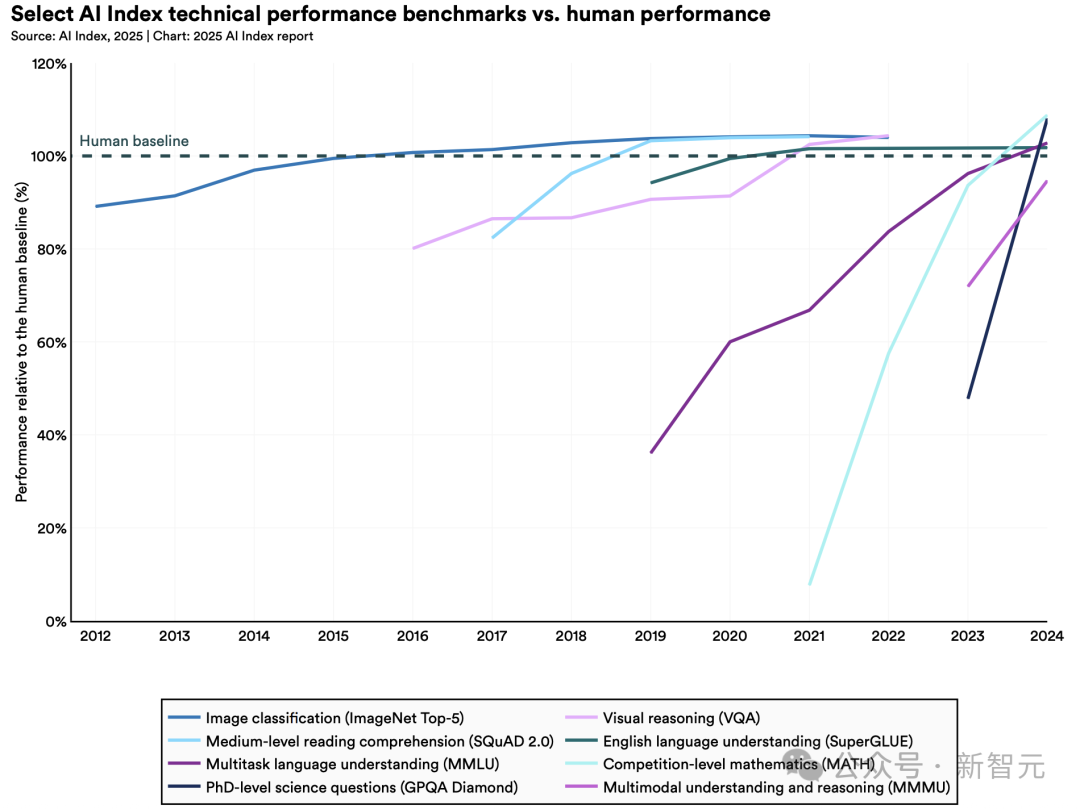

1. AI性能再攀高峰,从基准测试到视频生成全面突破

2023 年,研究人员推出了新基准。这些新基准包括 MMMU、GPQA 和 SWE-bench 等。它们被用于测试先进 AI 系统的极限。

一年后,性能有了大幅提升。AI 在三项基准上的得分分别有显著变化,其中一项得分飙升了 18.8%,另一项得分飙升了 48.9%,还有一项得分飙升了 67.3%。

AI 在生成高质量视频方面取得了重大突破。并且,在某些场景下,AI 智能体的表现超越了人类。

·更有用智能体崛起

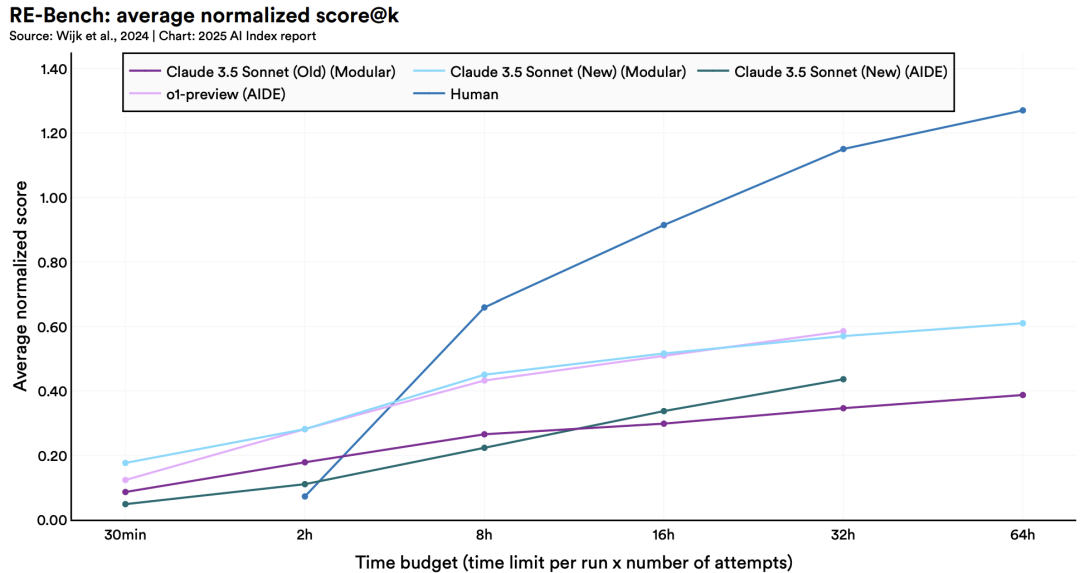

2024 年发布了 RE-Bench 基准测试,这个基准测试为评估 AI 智能体的复杂任务能力设定了严格的标准。

数据表明,在短期任务(2 小时内)的这种场景当中,顶级 AI 系统的表现能够达到人类专家的 4 倍。然而,要是把任务的时限延长到 32 小时,人类就以 2 比 1 的优势实现了反超。

值得注意的是,AI 在特定领域展现出专业水平,比如编写特定类型的代码。它与人类的专业水平相当,并且执行效率更优。

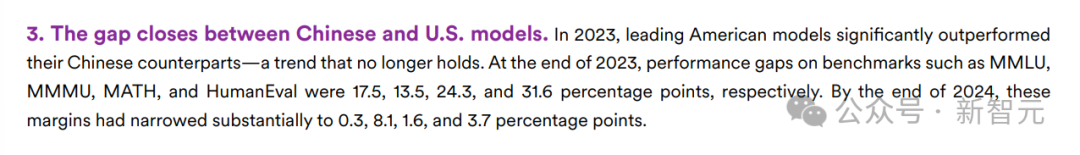

2. 美国领跑顶尖模型研发,但中国与之差距逐渐缩小

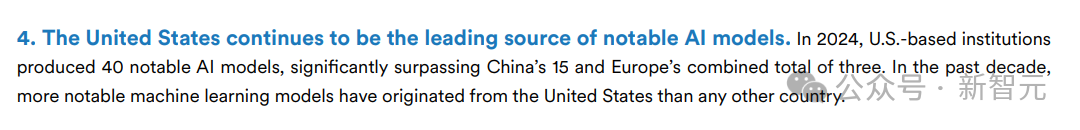

2024 年,美国产出的重要 AI 模型数量为 40 个。这个数量远超中国产出的 15 个重要 AI 模型,也远超欧洲产出的 3 个重要 AI 模型。

然而,中国模型在性能方面的差距正在逐渐缩小。在 MMLU 等基准测试中,中美 AI 的差异从两位数减少到几乎持平。

中国在 AI 学术论文方面的数量持续处于领先地位,在专利申请量上也一直领跑。中东地区、拉美地区以及东南亚地区都有具有竞争力的模型涌现出来。

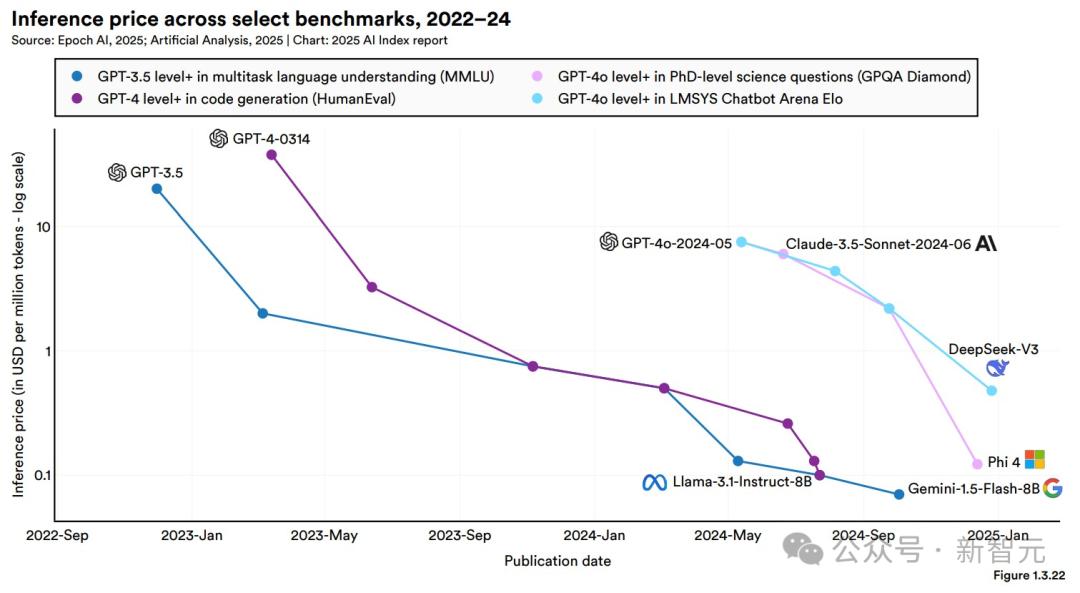

3. AI正变得高效且普惠,推理成本暴降280倍

小模型性能提升后,两年间达到 GPT - 3.5 水平的推理成本下降了 280 倍。硬件成本每年以 30%的速度在递减。能效年提升率达到 40%。

令人振奋的是,开源模型的性能有了很大提升。在部分基准测试中,它与闭源模型的差距从 8%缩小到了 1.7%。

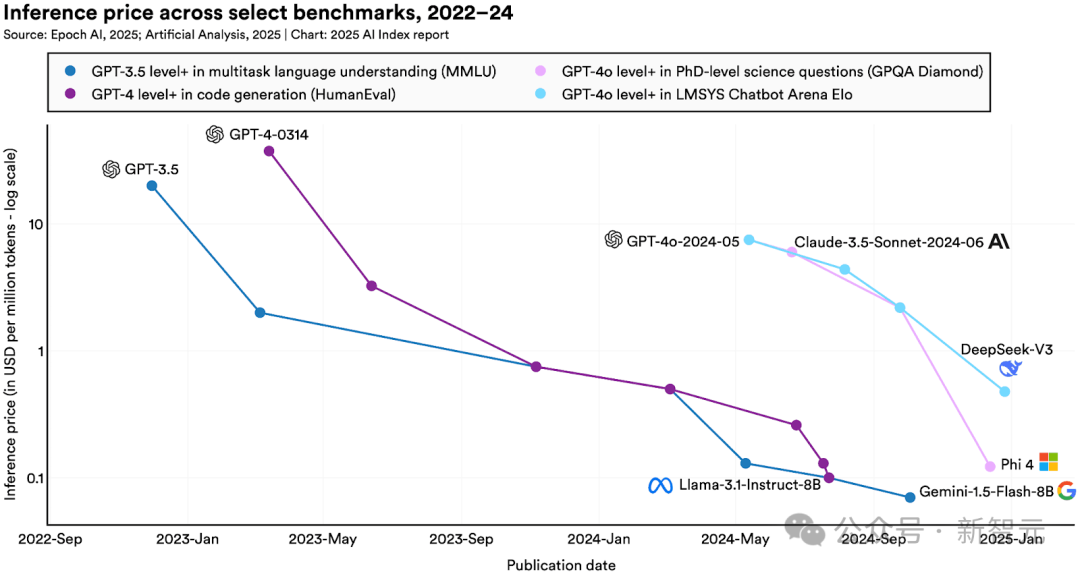

· 大模型使用成本持续走低,年降幅最高900倍

在 MMLU 基准测试中能达到 GPT-3.5 水平,其准确率为 64.8%。该 AI 模型的调用成本,在 2022 年 11 月是 20 美元每百万 token,到 2024 年 10 月已骤降至 0.07 美元每百万 token,这里指的是谷歌 DeepMind 的 Gemini-1.5-Flash-8B 模型。在 18 个月内,AI 成本下降了 280 倍。

根据具体的任务需求,LLM 推理服务价格在一年时间里的降幅能够达到 9 倍到 900 倍这样不同的程度。

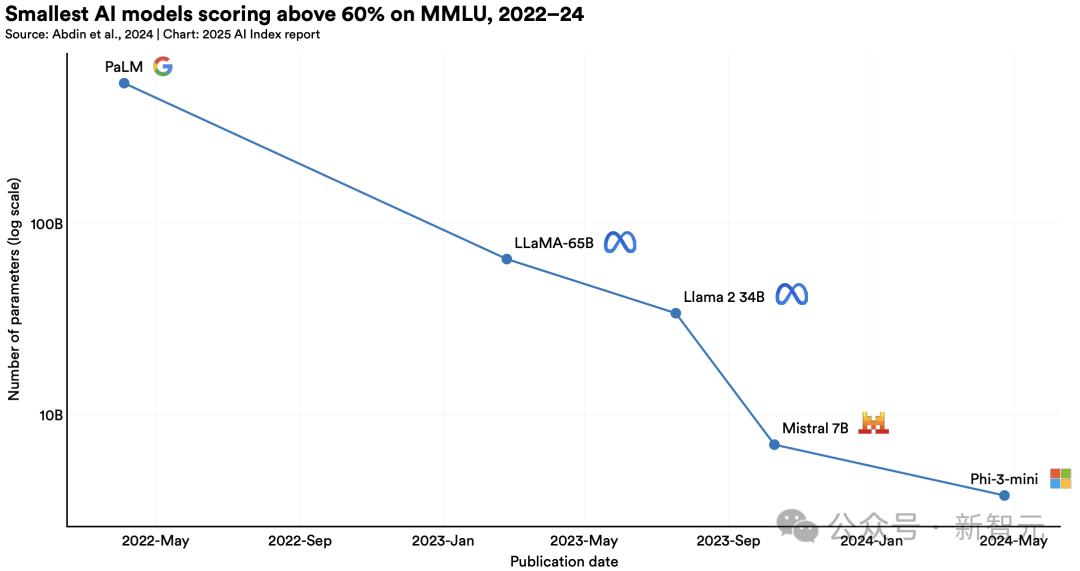

·小模型性能显著提升,参数暴减142倍

2022 年,在大规模多任务语言理解(MMLU)基准测试方面。得分超过 60%的最小模型是 PaLM,其参数量为 5400 亿。

2024 年时,微软 Phi-3-mini 仅凭借 38 亿参数,便达到了同样的实力。

这代表,两年多的时间里模型参数减少了142倍。

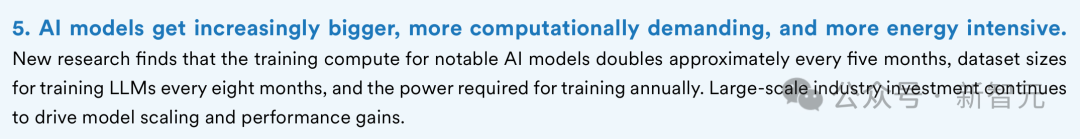

4. 科技巨头称霸AI前沿,但竞争白热化

2024 年,重要模型中近 90%源自企业。同时,学术界保持着基础研究的优势。

模型规模呈指数式上升。训练所需的算力每隔 5 个月就会翻倍。数据集每隔 8 个月就会扩充一倍。

值得注意的是,头部模型的性能差距明显缩小了。榜首与第十名的得分差,已经从 11.9%降低到了 5.4%。

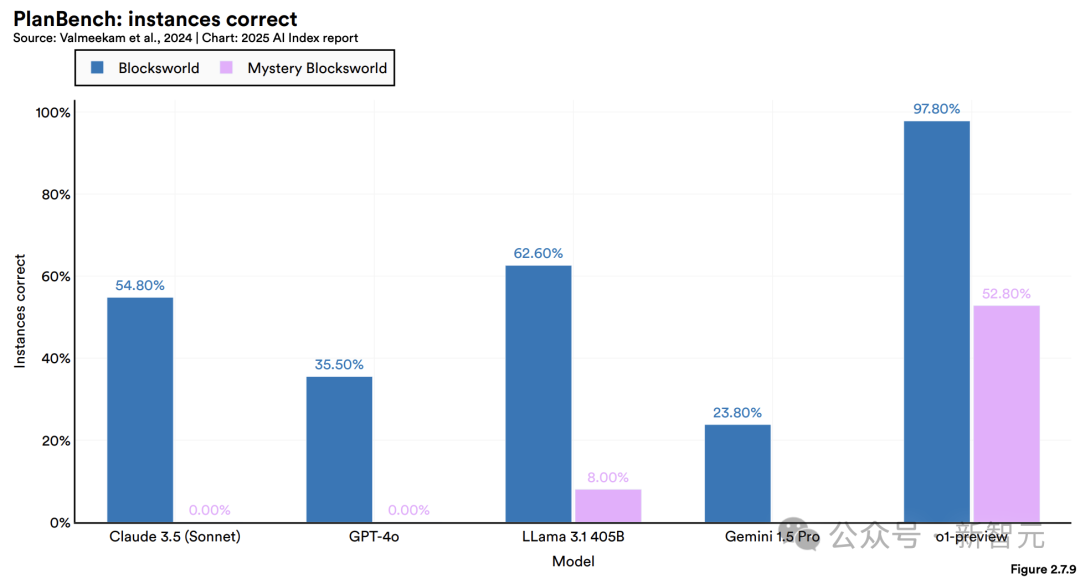

5. AI逻辑短板,推理能力仍是瓶颈

AI 系统采用符号推理方法,能够较好地解决 IMO 问题,尽管尚未达到人类的顶尖水平。然而,LLM 在 MMMU 等复杂推理任务中表现不佳,尤其在算术推导和规划类强逻辑性任务方面不擅长。

这一局限影响了其在医疗诊断等高风险场景的应用可靠性。

6. 大厂ALL in AI,投资与采用率创双纪录

科技大厂们,正全力押注AI。

2024 年,美国私营 AI 的投资达到了 1091 亿美元。这个数字大约是中国(93 亿)的 12 倍,同时也是英国(45 亿)的 24 倍。

生成式 AI 的发展势头非常迅猛。在全球范围内,私募投资达到了 339 亿美元。这一投资金额同比增长了 18.7%。

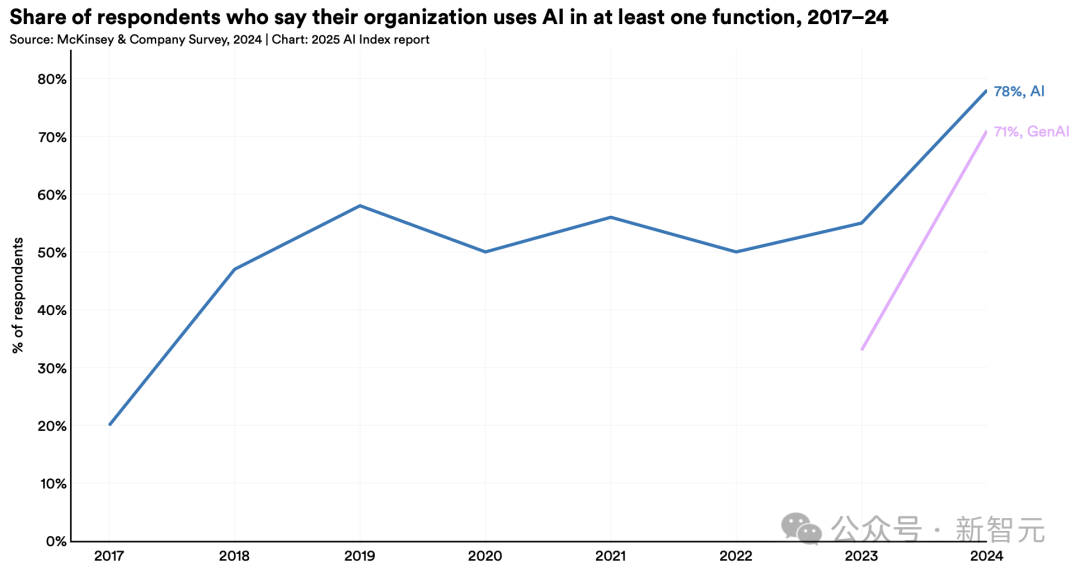

企业 AI 采用率有了提升,从 55%上升到了 78%。研究表明,AI 具备提升生产力的能力,并且在多数情况下能够缩小劳动力技能方面的差距。

引人注目的是,企业将生成式 AI 应用于至少一项业务职能的数量有了大幅增长。2023 年这一比例为 33%,去年跃升至 71%,增幅超过一倍。

7. AI荣膺科学界最高荣誉,摘诺奖桂冠

2024 年,图灵奖授予了强化学习领域。

8. AI教育普及加速,但资源差距仍存

全球有 2/3 的国家已经或者计划开展 K-12 计算机科学教育。然而,非洲地区由于受到电力等基础设施的限制,其推进的速度较为缓慢。

美国的计算机教师中,有 81%的人认为 AI 应该被纳入基础课程,然而,在这些教师当中,只有 47%的人具备相应的教学能力。

9. AI正深度融入日常生活

从医疗到交通,AI正快速从实验室走向现实。

1995年,FDA批准了第一款AI赋能的医疗器械。

到 2024 年 8 月的时候,FDA 已经批准了 950 款 AI 医疗设备。与 2015 年的 6 款相比,与 2023 年的 221 款相比,增长速度非常迅猛。

在自动驾驶领域,汽车已经不再处于实验阶段。美国的头部运营商 Waymo 每周能够提供超过 15 万次的无人驾驶服务。

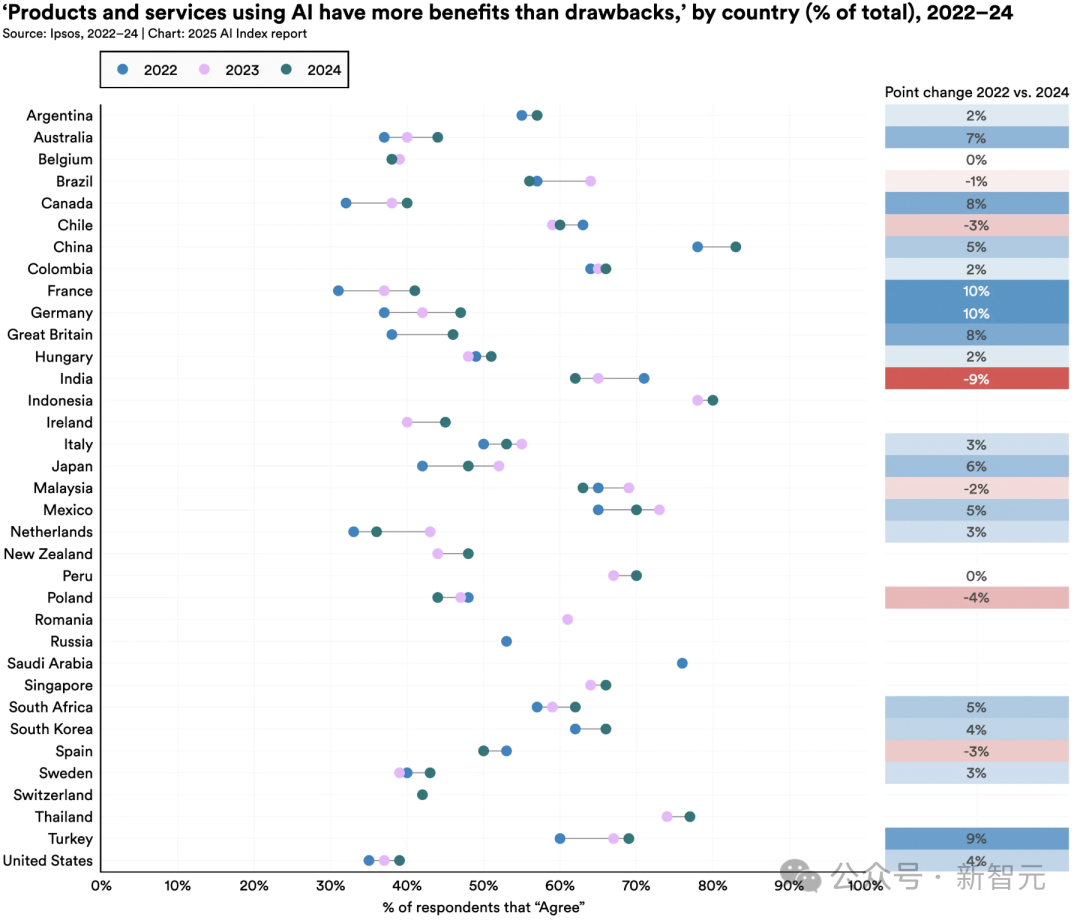

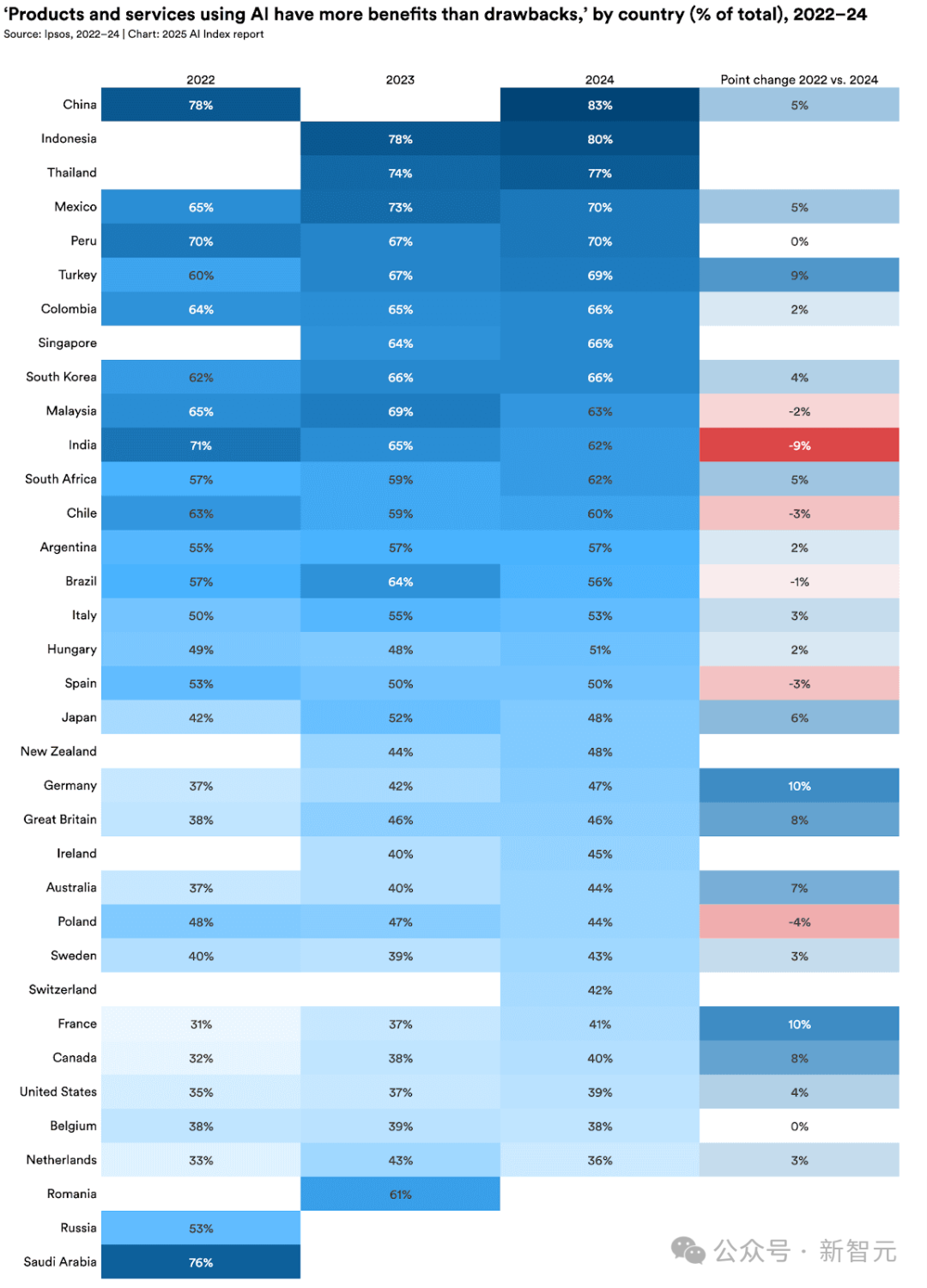

10. 全球AI乐观情绪上升,但地区差异显著

中国民众对 AI 持积极态度,占比 83%;印尼民众对 AI 持积极态度,占比 80%;泰国民众对 AI 持积极态度,占比 77%。同时,加拿大民众对 AI 相对保守,占比 40%;美国民众对 AI 相对保守,占比 39%。这些发达国家民众对 AI 的态度相对较为保守。

值得关注的是,德国的态度有明显转变,增长了 10%。同时,法国的态度也有明显转变,同样增长了 10%。这些原属于怀疑论的国家态度发生了改变。

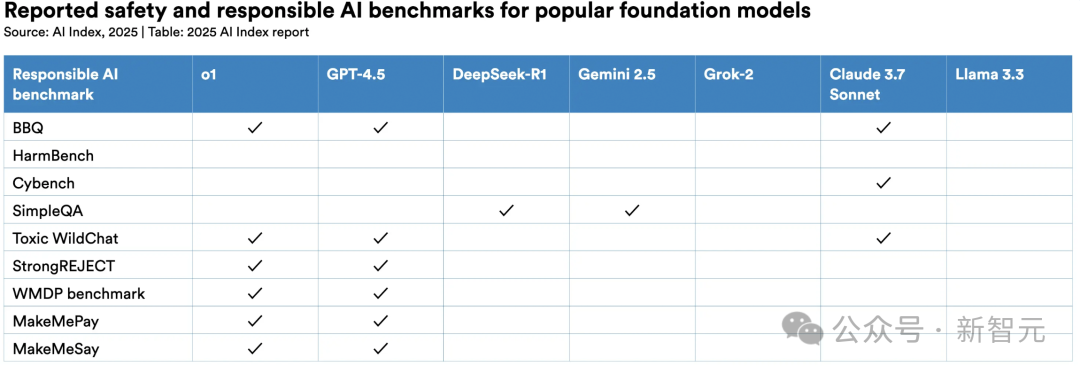

11. 负责任AI生态发展不均

AI 安全事件呈现出激增的态势,然而主流模型开发商在这方面却缺乏标准化的评估体系。

FACTS 为事实性与安全性评估提供工具。

企业普遍存在“认知与行动脱节”的情况,与此同时各国政府在加速协作。在 2024 年,经合组织、欧盟等国际机构陆续发布了聚焦于透明度和可信度的治理框架。

· 问题AI数量跃升

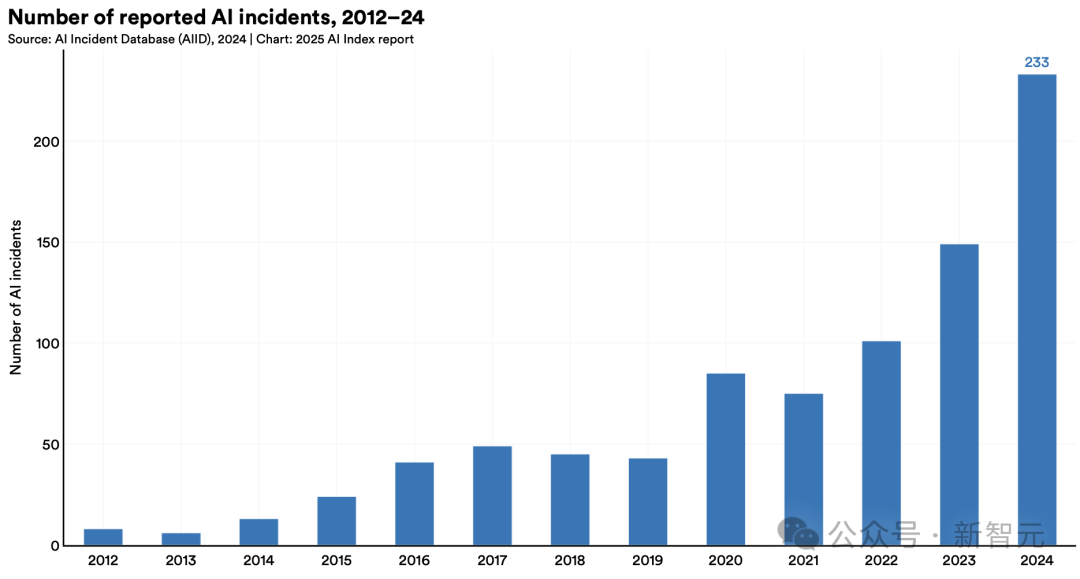

权威 AI 危害追踪数据库「AI 事件库」(AI Incidents Database)的统计显示,2024 年全球 AI 相关危害事件数量大幅增加到 233 起。这一数字创下了历史新高,与 2023 年相比,暴涨了 56.4%。

其中包含深度伪造私密图像的案件,同时还涉及聊天机器人似乎导致青少年自杀等不良事件。

该统计虽未涵盖全部案例,却已清晰地揭示出 AI 技术滥用正呈现出惊人的增长态势。

12. 全球监管力度持续加强

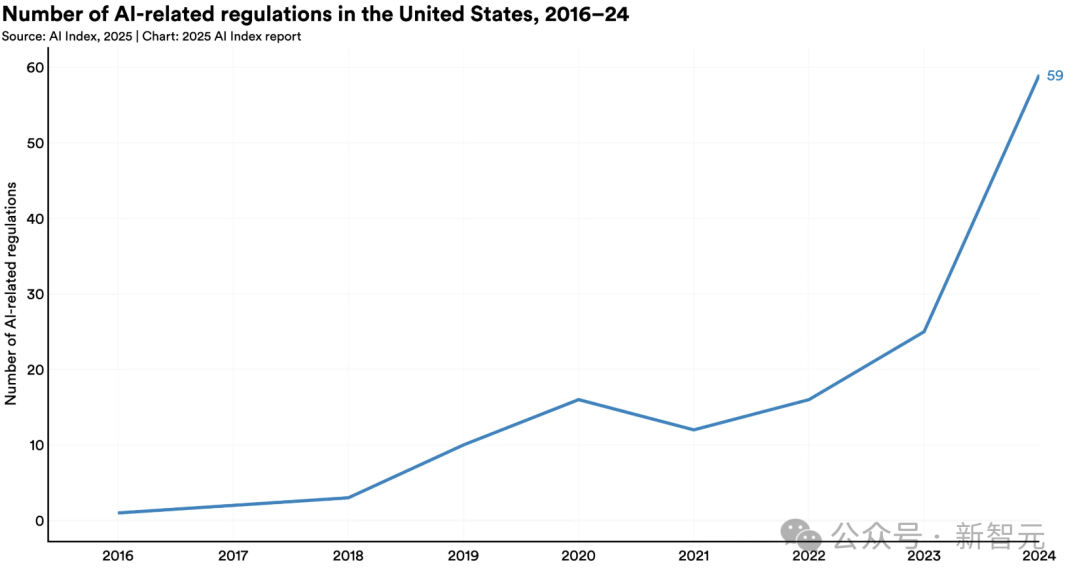

2024 年美国联邦机构颁布了 59 项关于 AI 的法规。这些法规所涉及的部门数量相较于之前翻倍了。

75 个国家的立法机构提及 AI 的频次呈现出同比增长的态势,增长幅度为 21.3%。并且与 2016 年相比,增长了九倍之多。

投资方面:加拿大做出 24 亿美元的承诺;中国设立了 475 亿美元的半导体基金;法国投入了 1090 亿欧元;印度拨出 12.5 亿美元;沙特启动了千亿美元级的“超越计划”。

详细亮点解读

下面,我们将摘出报告中的亮点内容,提供更详细的解读。

中美差距仅剩0.3%

打开 502 页的报告,其中最引人注目的部分,就是中美 AI 差异这部分啦。

报告强调,2024 年时,美国在顶尖 AI 模型的研发方面处于领先地位。然而,中美模型之间的性能差距正在快速地缩小。

HAI 为了衡量 AI 领域过去一年演变的全球格局,特意使用 AI 指数,将具有代表性的模型所属国家列了出来,其中美国依然处于首位。

数据表明,2024 年时,美国机构拥有 40 个知名模型处于领先地位,其数量远远多于中国的 15 个以及欧洲的 3 个。

模型发布总量总体上呈现下降趋势,这可能是由多个因素共同作用造成的。一方面,训练规模在不断增大;另一方面,AI 技术日益变得复杂;此外,开发新模型的方法难度也在持续提升。

AI模型已成为算力巨兽

· 参数趋势

简单来讲,参数是 AI 模型在训练过程中所学到的一些数字。这些数字对模型理解输入以及输出的方式起到了决定作用。

AI的参数越多需要的训练数据也越多,但同时性能也更厉害。

从 2010 年代初开始,模型的参数量呈现出不断上涨的趋势。这背后有着多方面的原因,一方面是模型设计变得越来越复杂,另一方面是数据更容易被获取,还有一方面是硬件算力变得更强了。

更重要的是,大模型确实效果好。

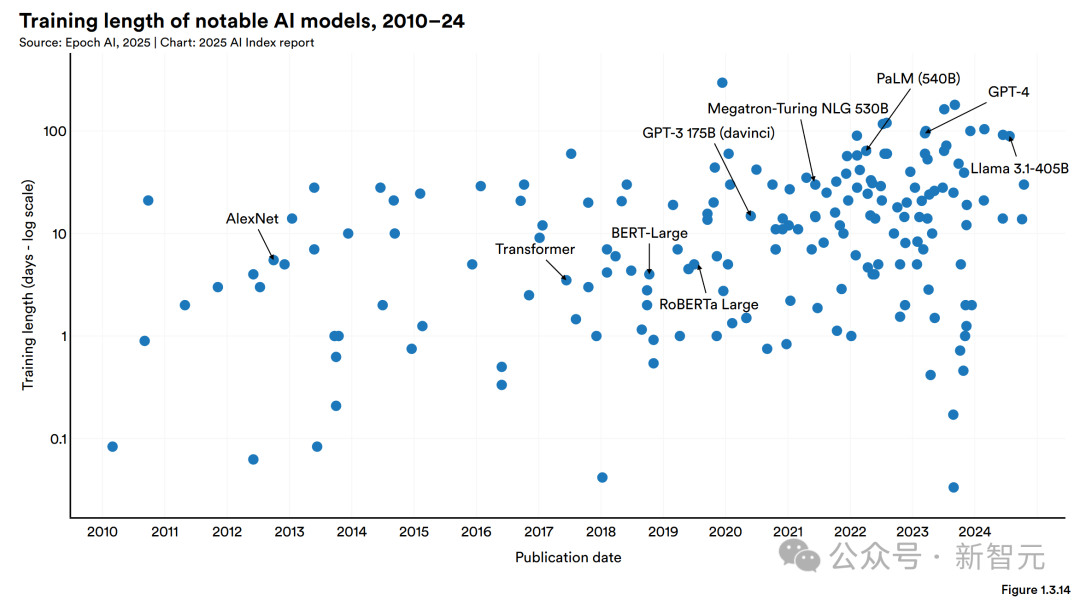

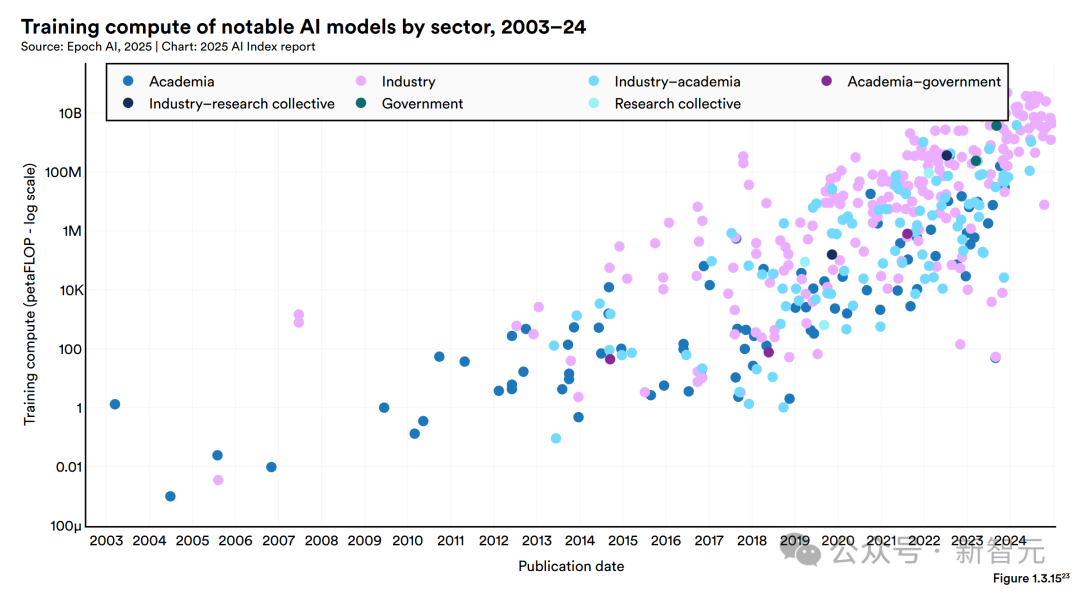

下图采用了对数刻度,这样能让大家清晰地看到 AI 模型参数以及算力在近年来呈现出的爆炸式增长态势。

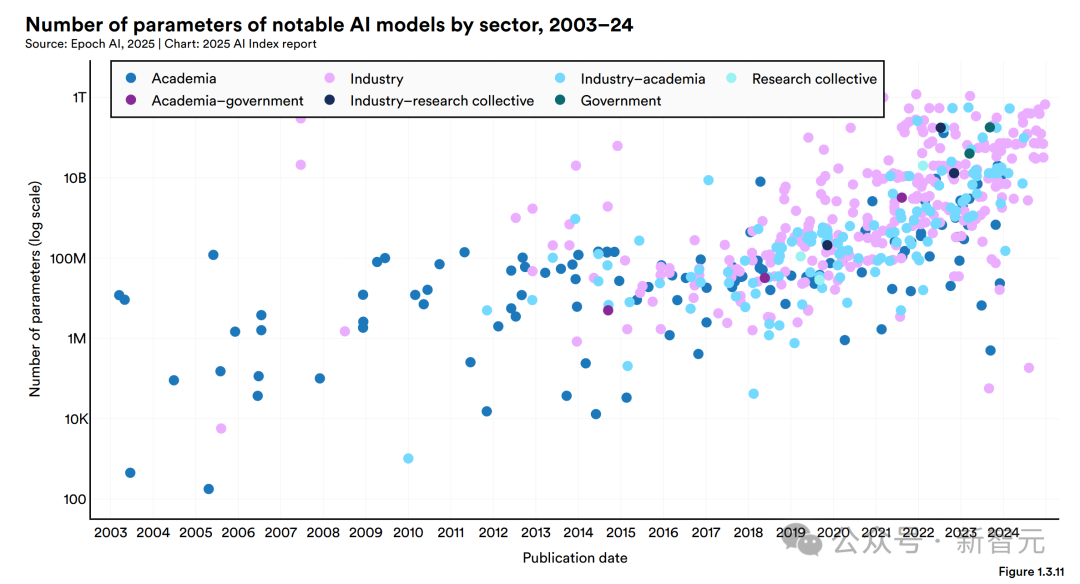

随着模型参数数量的增加,训练所需的数据量也在暴涨。

Transformer 模型于 2017 年发布,它掀起了大型语言模型的热潮,当时是用大约 20 亿个 token 来进行训练的。

2020 年的时候,GPT-3 的 175B 模型其训练数据增长迅猛,已经达到了约 3740 亿个 token。

meta 在 2024 年夏天发布的模型是 Llama 3.3。它用了大约 15 万亿个 token 来进行训练。

Epoch AI 的数据表明,大型语言模型的训练数据集规模呈现出一种变化趋势,即大约每八个月就会翻倍一次。

训练数据集越来越大,导致的训练时间也变得越来越长。

像 Llama 3.1 - 405B 这样的模型,其训练大概需要 90 天的时间,在如今这种情况已经算是“正常”的了。

谷歌在 2023 年底发布了 Gemini 1.0 Ultra。它的训练时间大约是 100 天。

2012 年的 AlexNet 与之相比显得快很多。它训练只花费了五六天的时间。并且当时 AlexNet 使用的硬件远远没有现在的先进。

· 算力趋势

「算力」指的是训练和运行AI模型所需的计算资源。

最近,知名 AI 模型的算力消耗呈现出指数式的增长态势。Epoch AI 估计,知名 AI 模型的训练算力大概每过五个月就会翻倍一次。

这种趋势在过去五年尤为明显。

去年 12 月,DeepSeek V3 推出后引发了广泛关注。其主要原因是它在性能方面表现极其出色,然而它所使用的计算资源却比许多顶尖大型语言模型少很多。

下图 1.3.17 对中国和美国知名 AI 模型的训练算力进行了比较,这揭示出一个重要趋势:美国的顶级 AI 模型在训练算力方面通常比中国模型需要多得多的计算资源。

· 推理成本

推理成本指的是对一个已训练模型进行查询所需要的费用,并且通常是以“每百万 tokens 的美元价格”来进行衡量的。

这份报告中的 AI token 价格数据,是从 Artificial Analysis 和 Epoch AI 的 API 定价专有数据库得来的。价格是依据输入 token 与输出 token 的价格,以 3:1 的权重进行平均计算而得出的。

可以看出,单位性能的AI成本正在显著下降。

Epoch AI 估计,不同任务类型下,大型语言模型的推理成本每年下降幅度有所不同,有的可达 9 倍,有的可达 900 倍,且在 9 倍至 900 倍之间不等。

虽然如此,但要获得来自 OpenAI 的模型,需支付不小的溢价;要获得来自 meta 的模型,需支付不小的溢价;要获得来自 Anthropic 的模型,也需支付不小的溢价。

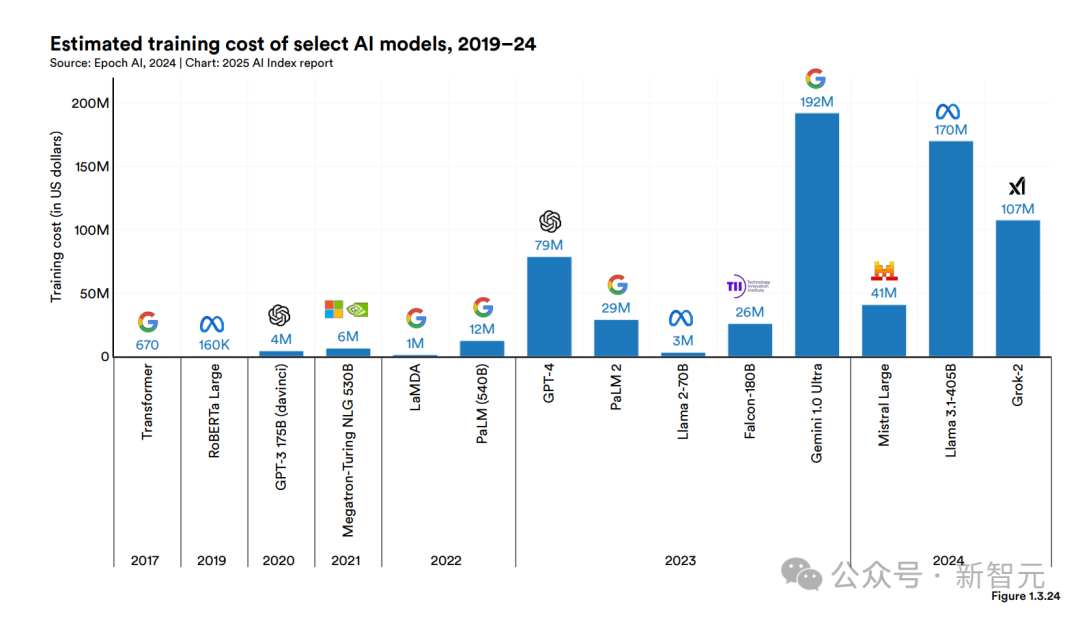

· 训练成本

AI 公司很少披露具体的训练成本,然而这个数字普遍已经达到了数百位美元。

OpenAI 的 CEO 奥特曼表明过,对 GPT-4 进行训练所耗费的成本超过了 1 亿美元。

Anthropic 的 CEO Dario Amodei 表明,当下正在进行训练的那个模型,其成本大概是 10 亿美元。

DeepSeek-V3的600万美元,则打破了新低。

图 1.3.24 展示了部分 AI 模型的训练成本估算,这些估算基于云计算的租赁价格。

图 1.3.25 展示了一些情况。它展示了 AI 指数所估算出来的内容。这些内容是所有 AI 模型的训练成本。

2024 年,Epoch 能够估算的模型数量较少,其中之一就是 Llama 3.1 - 405B,它的训练成本约为 1.7 亿美元。

另外,AI 模型的训练成本和它的计算需求有直接的关联。从图 1.3.26 可以看出,计算需求比较大的模型,其训练成本明显更高。