本文整理自赫力昂中国首席信息安全官顾伟在“CIAPH 第 13 届医药健康行业数字化高峰论坛”上的分享

顾伟赫力昂中国首席信息安全官

各位同仁上午好。今天我要分享的内容是人工智能在甲方企业的落地情况。对于药企而言,如何运用负责任的人工智能治理模型呢?这是一个值得我们一起去探索的课题。

01 什么是人工智能?

首先让我们来重新认识一下 AI。人工智能依据不同的领域,能够分为狭义 AI、通用 AI、人工超智能这三类。像图像识别、语音识别、语义分析等这些场景属于狭义的弱 AI。而自动驾驶、智能机器人、手术机器人等属于通用 AI,也就是强 AI。人工超智能更多地应用于创新与创造性以及主动感知环境等场景。

如今 AI 正飞速发展。在游戏领域,AI 不但学会了游戏规则,还在策略以及反应速度方面超越了人类玩家,就像在围棋比赛中李世石与人工智能的那场对决一样。这是一个极具突破性的飞跃,然而当时人工智能并未受到重视,如今 AI 真正迈入了一个爆发性的阶段。

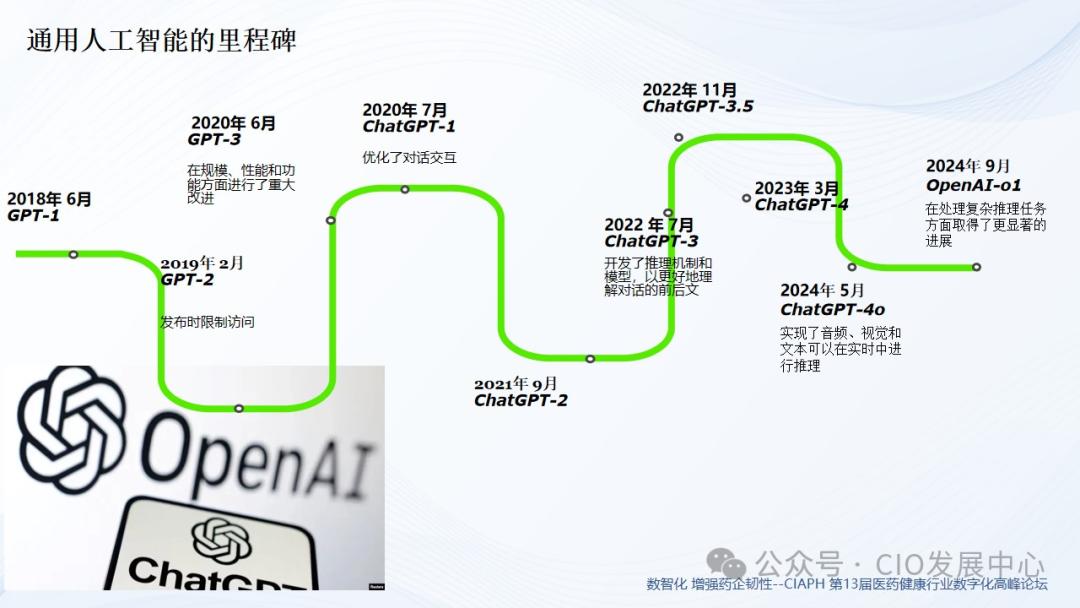

从通用人工智能的发展历程方面来看,2018 年 GPT 诞生了第一个版本。随着持续的迭代与优化,到 2024 年 9 月,OpenAI - o1 在处理复杂推理任务方面取得了更为显著的进展。就我个人而言,在进行研究和撰写文章时,发现借助 AI 来梳理文献以及检索文献,能够让工作变得非常高效。人工智能有诸多应用场景,许多企业也开展了一些出色的应用。我们是一家英国公司,总部在伦敦。基于欧盟的人工智能法案,我们进行了相应的人工智能治理模型的构建。

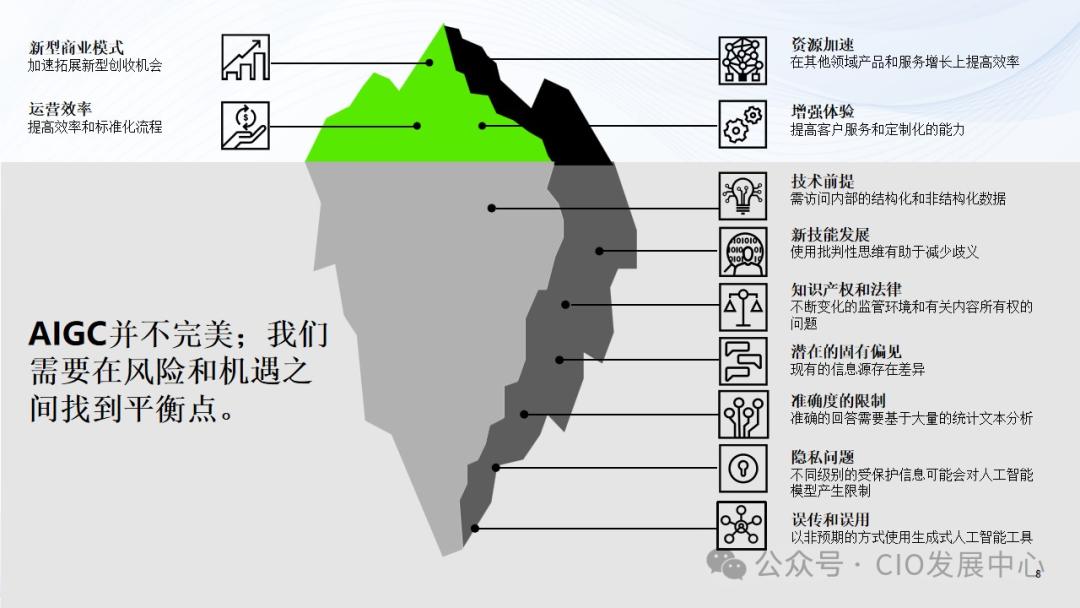

人工智能能够提升我们的效能,然而不可忽视的是必须要平衡风险和收益。我们需要一分为二地看待人工智能,它就像冰山那样,水面之上露出的上层部分可能具有一些优势和闪光点,比如能够帮助我们提升用户体验,加快商业模式的推进。但与此同时,在水下也存在着一些底层的风险,像技术壁垒、伦理歧视、固有偏见、隐私问题等等。在人工智能的应用过程中,需要关注如何去保护用户的权益以及隐私,同时也要思考怎样避免 AI 被错误地使用,这些问题都值得广大同仁进行深入的研究。

02 何为负责任的人工智能?

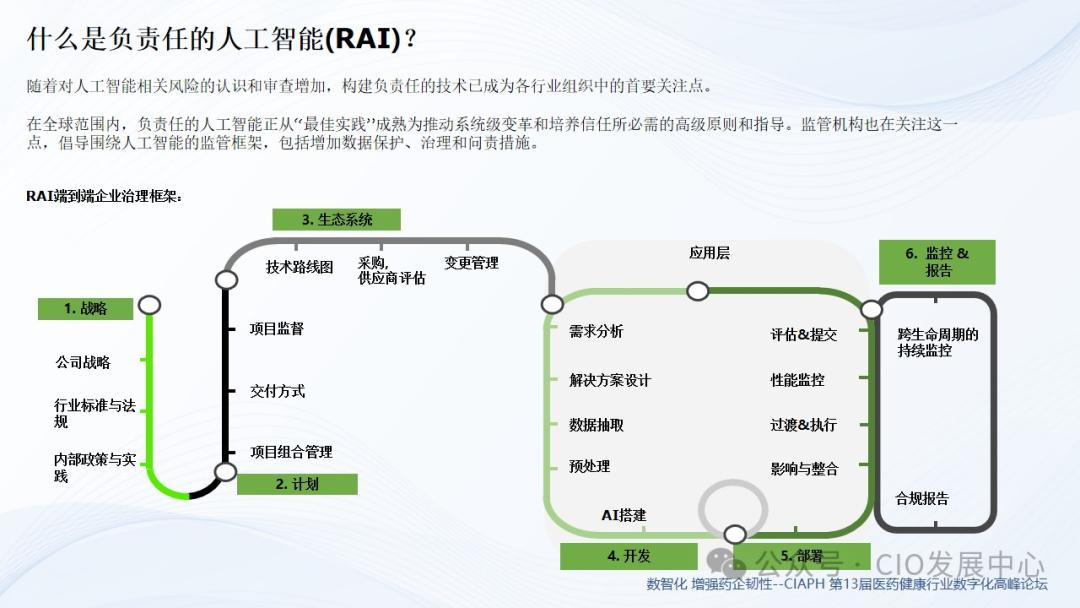

大家对人工智能相关风险的认识在增加,对其进行的审查也在增加。构建负责任的技术成为各行业组织的首要关注点。在全球范围内,负责任的人工智能正从“最佳实践”逐渐成熟,成为推动系统级变革以及培养信任所必需的高级原则和指导。监管机构也在关注这一情况,倡导围绕人工智能建立监管框架,其中包括加强数据保护、完善治理以及增加问责措施。

我认为在 RAI 端到端的企业治理框架里,首先要去定义战略,同时也要明确相应的行业标准与法规;接着要做好相关的规划,并且建立起生态系统,把供应商融入到技术路线当中;之后就是进行相应的应用、开发以及部署工作;最后还需要进行持续性的监控。只有这样,才能够构建出一个完整且负责任的人工智能。

03 为什么要选择负责任的人工智能?

各行各业有越来越多的组织和行业在使用人工智能来提供产品和服务。有的企业里,AI 会替代人力,这给员工带来了一定的恐慌。同时,数据越来越多,需要有责任感的 AI 来合理运用这些数据。而且,用户对于负责任且透明的人工智能的呼声变得更高了。当然不能忽视外部风险。很多模型基础架构较为脆弱,它们没有防火墙,没有数据防护,也没有访问权限管理。基本上只要遭受攻击,就能够轻易被攻破,其安全性令人担忧。因此,构建安全可靠的人工智能是极为重要的。

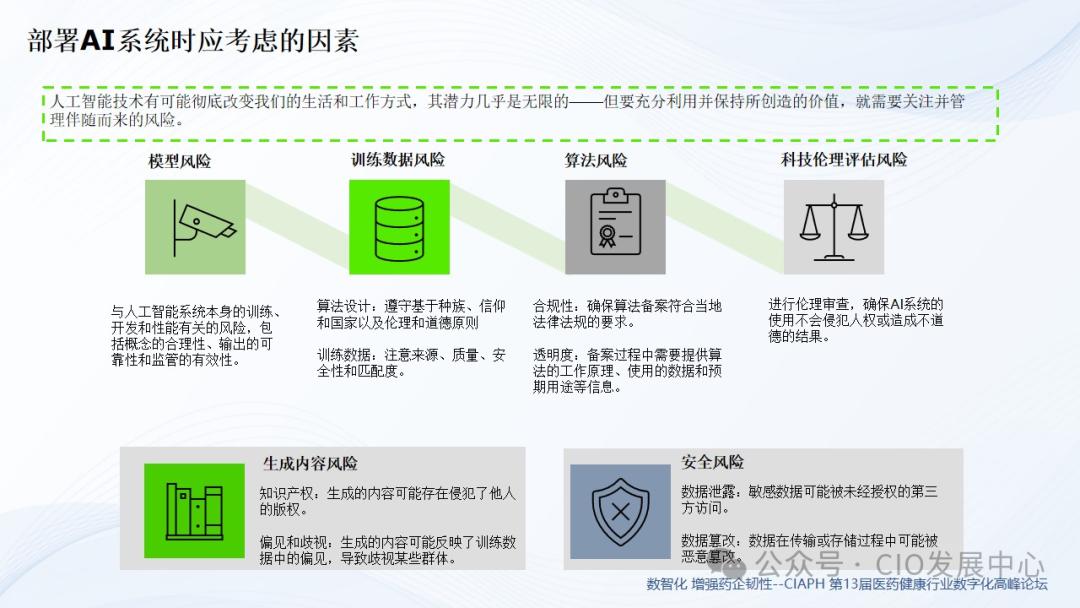

企业也是如此,在建设人工智能时一定会考虑风险和成本。特别是一些大型厂商在进行人工智能的应用和开发时,如果没有相应的安全考量,就可能会带来许多额外的风险。以下这四个维度的考量能够帮助我们构建合理且负责任的架构。

第一是在战略层面,必须要与 AI 的伦理道德保持一致,不能仅仅是为了提升生产力而去建设 AI 。

第二是关于控制方面。管理工作、遵循合规要求以及进行风险管理,这是每个企业都必须要去做的事情,并且这需要企业给予重视。

第三是实践。比如网络安全极为重要,原因在于所有的基础架构或许都得在互联网上呈现。倘若没有把网络安全工作做好,那么基础架构就很容易遭受攻破。

第四是核心实践。需要对 AI 能够解决的问题进行评估,要验证其是否可以持续迭代,还要打造能够遵循行业标准并持续监控的能力。

构建负责任 AI 的共同使命在于,组织内各个部门的不同利益相关者需要相互协作,以便一致且有效地应用负责任的人工智能实践。具体而言,有三道防线:其一,在模型开发阶段,要做好风险评估工作,并对基础设施部署相应的监控与安全防护措施;其二,领导层需要对法律法规、合规以及隐私防护有深刻的理解,同时做好权限的管控工作。企业内部要有一些审计的职能,还要有伦理科学家。同时,在企业层面,需要有外部的监管机构以及审计师来协助进行审计和监管。

2021 年至 2022 年期间,中国成为首个对人工智能的某些最常见应用实施详细且具有约束力规定的国家。这些规定构成了中国新兴人工智能治理制度的基础。在 2023 年以及 2024 年初,更多的法规和标准得以出台,进一步对中国的人工智能监管格局进行了塑造。

我国的 AI 法律体系有助于规避风险。其一,《生成式人工智能服务管理暂行办法》有助于明确是否需进行相应备案和登记。其二,《互联网信息服务深度合成管理规定》有助于辨析一些标识和机制,以实施健全的内容审查。此外,《互联网信息服务算法推荐管理规定》能让算法服务商合规进行备案。通过这些法律,能够进一步满足安全的基本要求。

在部署 AI 时,人工智能技术有改变我们生活和工作方式的可能,其潜力近乎无限。然而,要充分利用并保持所创造的价值,就需关注并管理随之而来的风险。其一为模型风险,即模型自身训练的数据是否合规;其二是训练数据风险,要留意数据的来源、质量、安全性以及匹配度;其三是算法风险,需确定其是否符合当地的法规要求。第六是安全方面的风险,重点在于数据架构是否安全,是否具备一些访问限制。

在我国的生成式人工智能服务双备案制体系当中,算法需要备案,大模型也需要备案,这是必须要做的事情。许多主流大模型服务商已经完成了备案以及相应的登记工作。然而,在市场上也存在一些违规的案例,这些案例主要集中在没有进行备案以及没有做安全评估所引发的一些风险方面,另外还有违规传播内容的情况,涉及到侵犯数字版权以及图片版权等。

04 如何搭建一个负责任的人工智能治理模型?

对于外企而言,我认为需分为三个板块来做。其一,国内本身的评估流程以及评估问卷的必要性极高。因为国内对人工智能合规的要求更为严格,所以我们会单独进行评估。中国大陆和全球总部位于第二。会依据全球化 RAI 搭建评估问卷。亚太地区的国家可按照全球总部的评估流程进行评估。在中国部署 RAI 应用时,需在中国的合规模式下做评估问卷。除中国大陆外,会按照全球总部的 RAI 评估流程和问卷进行。

接下来看评估问卷的流程。首先是预评估,此环节主要涉及技术风险以及业务部门提出的一些采购需求。因此,我们会要求通过统一接口进行评估,同时制作相应的问卷。治理委员会会按需定义风险,最后按照风险等级做出决策。业务负责人需对 AI 的应用作出最终决策。若他决定承担风险,就需签字确认。只有在他签字确认后,我们才会批准他使用相应的人工智能技术,同时将其登记在案。这样的流程是较为负责任的人工智能评估流程。

我们与律所及一些咨询公司展开合作,制作了一些问卷。这些问卷涵盖了中国现行法律法规中关于人工智能应用评估的要求,以及一些重点内容,像是否签订了三方服务协议、人工智能承诺书,还有过去提供人工智能服务时是否有侵权行为等。同时,问卷中也包含了大量的人工智能服务的安全责任。最后是一些关于信息公开的内容,包括是否进行备案,是否进行登记,以及是否具备相应的科技能力审查等情况。

我想补充的一点是,中国 RAI 补充文档是依据全球 RAI 政策/标准与中国本地法规要求的差距分析而制定的,它是仅适用于中国市场的补充内容。原因在于中国存在一些特定的流程化登记和备案要求。其中包括查看不同的标注数据需求,有算法备案的需求,也有生成内容评估的需求,同时还有安全评估以及科技能力检查的需求等。正因如此,补充文档便随之产生了。