谷歌发布了第七代 TPU Ironwood,这是一个重磅消息。它是专门为推理而设计的。其性能相比初代有了巨大提升,飙升了 3600 倍。它能够与英伟达 B200 相抗衡。不仅如此,谷歌还带来了 Veo 2 等多款模型,并且这些模型都进行了全新升级。同时,“谷歌版”MCP 协议也被公布了出来。

推理时代的首款TPU诞生了!

昨晚在一年一度的谷歌云大会上,谷歌第七代 TPU——Ironwood 首次亮相了,它直接向英伟达 Blackwell B200 发起了挑战。

它是谷歌到目前为止性能最为强劲的定制 AI 加速器,并且可扩展性处于最高水平。同时,它还是第一款专门为推理而设计的加速器。

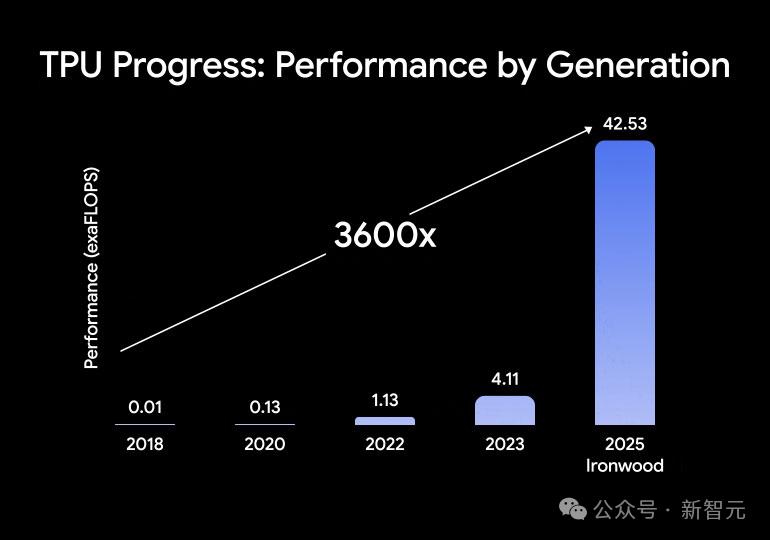

2018 年的第一代 TPU 与之相比,Ironwood 的推理性能有了极大提升,达到了 3600 倍之多,同时效率也提升了 29 倍。

第七代全新 TPU 的性能极为突出,其性能是世界第一大超算的 24 倍。谷歌计划在今年晚些时候正式推出 TPU v7。

谷歌大会上首次亮相 Agent2Agent(A2A)开放协议,此协议在 MPC 之后出现,它为智能体提供了一个通用语言,能让智能体在不同生态系统中进行沟通协作。

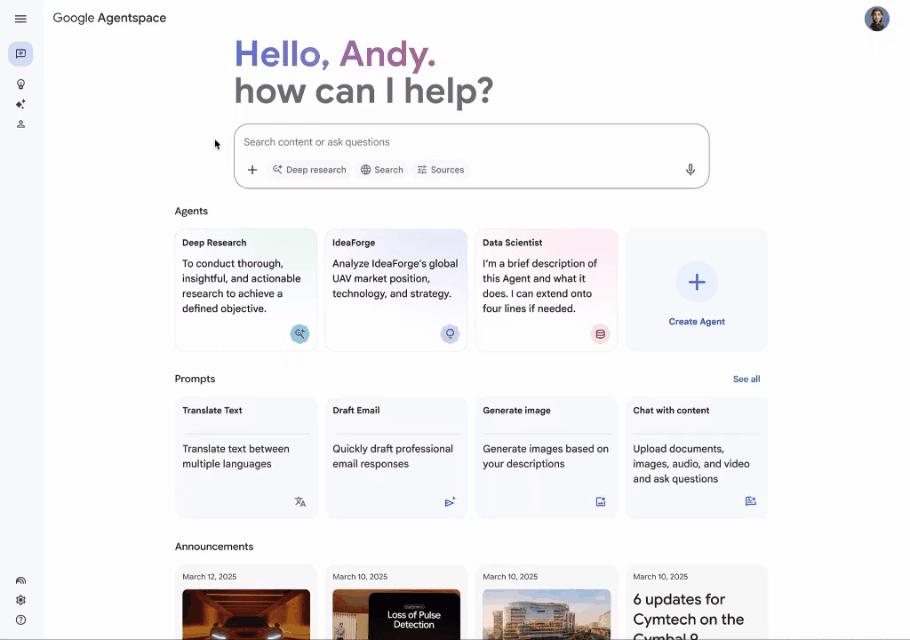

ADK 以及 Agentspace 为开发者提供了全面构建 AI 智能体的能力,同时也为开发者提供了全面操作 AI 智能体的能力,还为开发者提供了全面管理 AI 智能体的能力。

谷歌云大会很精彩。Veo 2 进行了迭代升级,Imagen 3 也进行了迭代升级,Chirp 3 同样进行了迭代升级。文本转音乐模型 Lyria 得以推出。Vertex AI 成为了唯一覆盖视频、图像、语音和音乐的全新生成式 AI 平台。

下一步,Gemini 2.5 Flash 具有极高的性价比,它也将登陆 Vertex AI。

推理时代首款TPU出世,媲美B200

Ironwood 诞生了,这标志着谷歌在 AI 硬件方面有了一大突破。同时,它也代表着 AI 基础设施发生了重大转变。

谷歌认为,当下的被动“响应式”模型正在朝着主动“生成式”智能体的方向转变。

这种转变的核心在于,AI 不再仅仅只是提供原始数据。它能够主动去检索信息,并且还能够生成见解。

在这个“推理时代”,谷歌对未来 AI 基础设施的定义为:它会更加智能;它会更加主动;它会更具协作性。

主要特性

性能有了显著的提升,并且在注重功耗效率这方面也做得很好,这样一来,AI 工作负载就能够以更具成本效益的方式运行。

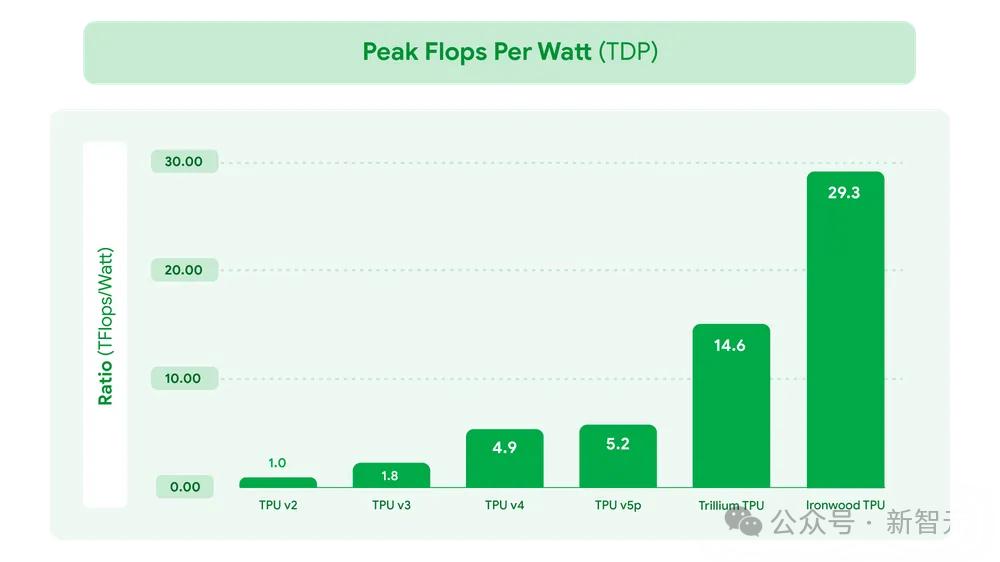

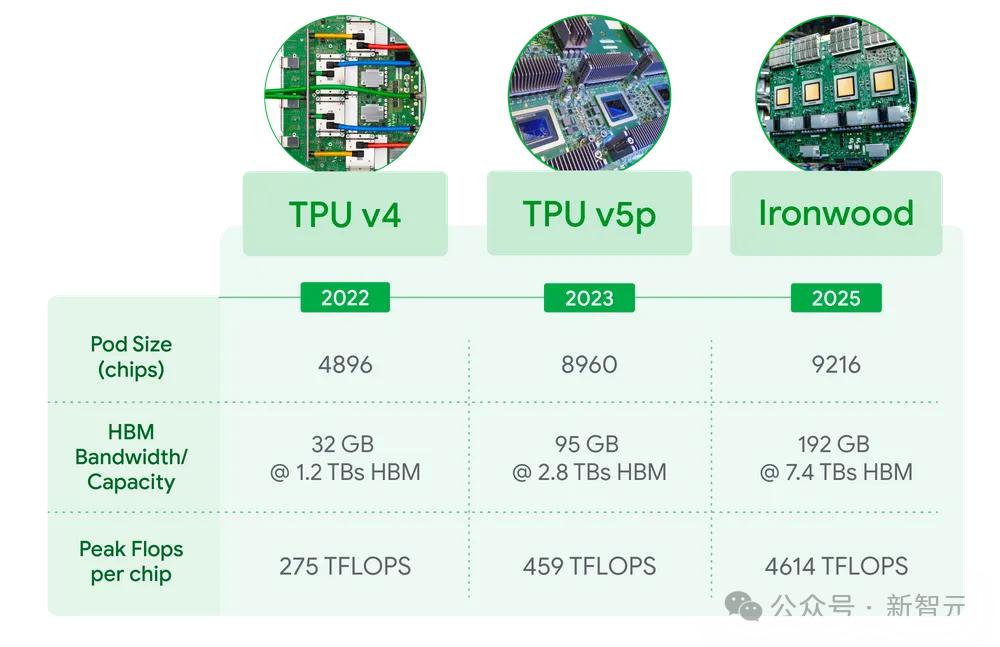

Ironwood 在功耗效率(perf/watt)方面比第六代 TPU Trillium 提升了 2 倍;与 2018 年推出的首款 Cloud TPU 相比,高出了将近 30 倍。

谷歌拥有先进的液冷解决方案,并且其芯片设计经过了优化。即便处于持续且繁重的 AI 工作负载状态下,这种液冷解决方案和优化的芯片设计依然能够可靠地保持性能。其性能能够高达标准风冷性能的两倍。

图 3. 功耗效率相较于TPU v2提升了29.3倍

· 高带宽内存(HBM)容量大幅增加

Ironwood 芯片的显存高达 192GB,Trillium 的显存为 192GB 除以 6,所以 Ironwood 芯片的显存是 Trillium 的 6 倍。

这样做能够处理规模更大的模型以及更庞大的数据集,并且降低了频繁进行数据传输的需求,从而提升了性能。

· HBM带宽显著提高

Ironwood 芯片的带宽提升到了 7.2 Tbps,这个数值是很惊人的。Trillium 的带宽是一定的,而 Ironwood 芯片的带宽是 Trillium 的 4.5 倍。

极高的带宽能够保证数据快速被访问,这对现代 AI 中经常出现的内存密集型工作负载有着重要意义。

· 芯片间互连(ICI)带宽增强

Ironwood 的双向带宽提升至 1.2 Tbps,而这个数值是 Trillium 的 1.5 倍。此类芯片间更快速的通信,对大规模高效的分布式训练和推理有所助益。

用Ironwood驱动推理时代

Ironwood 为要求极为严苛的 AI 工作负载提供了所需要的大规模并行处理能力。比如用于训练的、具有思考能力的超大规模稠密 LLM 模型,以及用于推理的超大规模稠密 LLM 或 MoE 模型。

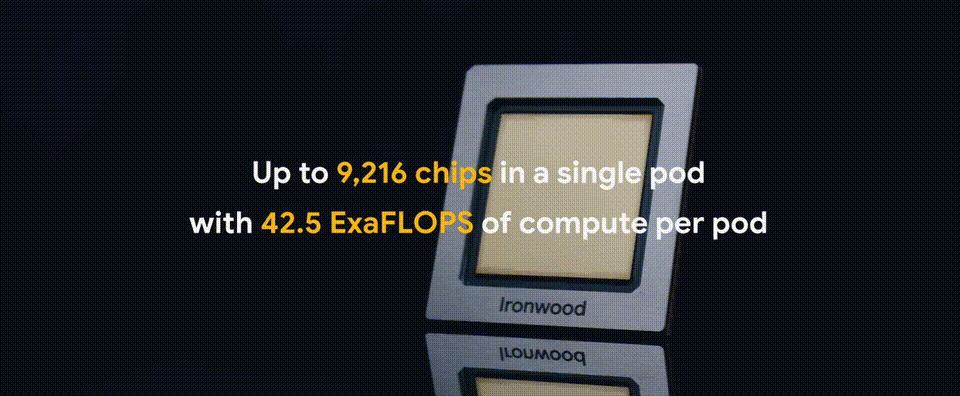

谷歌 Cloud 客户可享受 Ironwood 提供的两种规格服务,一种规格是根据 AI 工作负载需求提供 256 芯片,另一种规格是提供 9216 芯片。

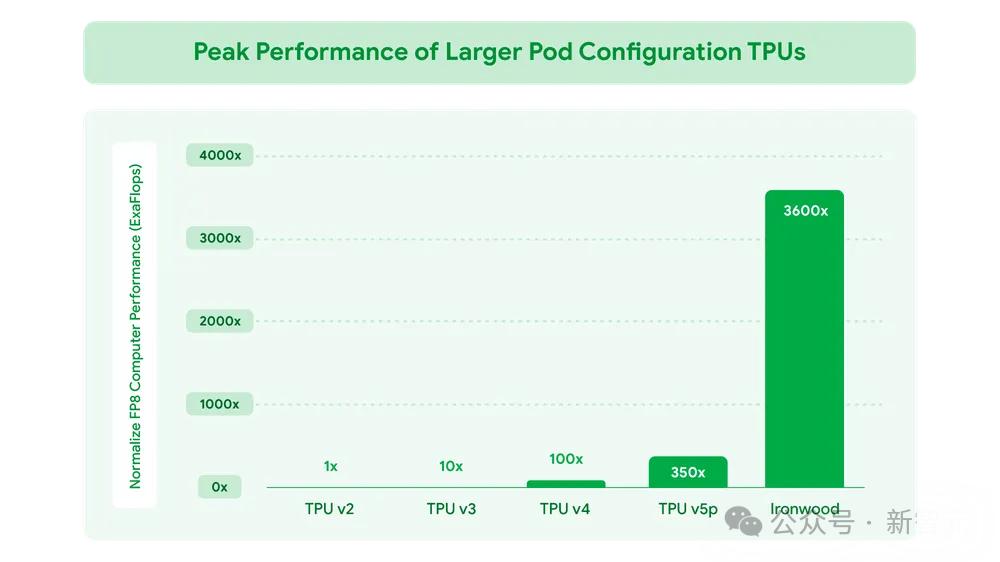

图 1 表明,FP8 浮点运算的峰值性能与 TPU v2 相比,提升了 3600 倍。FP8 浮点运算的峰值性能比 TPU v2 要高很多,高了 3600 倍。TPU v2 的浮点运算峰值性能与 FP8 相比,差距为 3600 倍。

其中,每个单独的芯片峰值算力达4,614 TFLOPs。

Ironwood 的算力扩展到每个 pod 有 9216 个芯片,总计能达到 42.5 Exaflop。此时,它是世界上最大的超级计算机 El Capitan 的 24 倍以上。而 El Capitan 每个 pod 仅能提供 1.7 Exaflops。

Ironwood 配备了增强版的加速器 SparseCore,此加速器专门用于处理高级排序和推荐任务。这样一来,它能为更广泛的工作负载提供加速,既可以在传统 AI 领域发挥作用,又能进入金融和科学领域。

Pathways 是一种 ML 运行时,它由谷歌 DeepMind 开发,能够在多个 TPU 芯片上实现高效的分布式计算。

谷歌 Cloud 上的 Pathways 让超越单个 Ironwood Pod 这件事变得简单且直接。它能够把数十万个 Ironwood 芯片组合到一起,进而快速推动生成式 AI 计算的前沿发展。

图 2 显示,Ironwood 本身就支持 FP8 这种数据格式。同时,v4 和 v5p 的峰值 TFlops 是模拟出来的值。

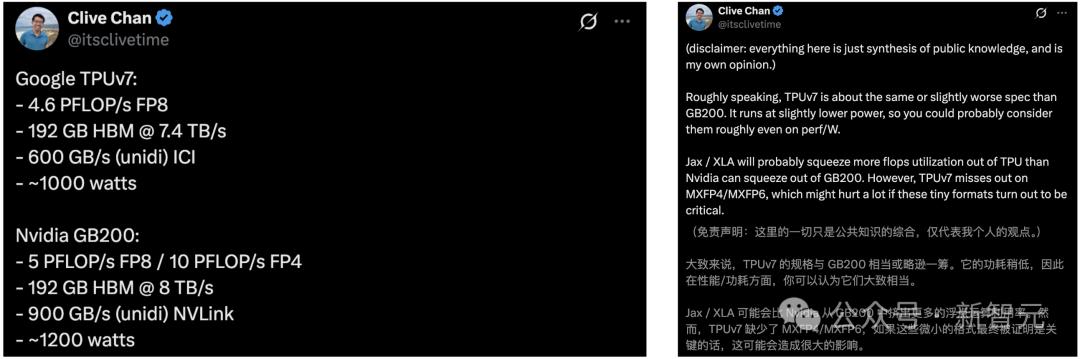

OpenAI 研究员对 Ironwood 和英伟达 GB 200 进行了性能对比。他们表示,TPU v7 的性能与 GB 200 相当,并且在某些方面还略胜一筹。

全模态AI平台来了,Veo 2再升级

Vertex AI 现在拥有生成式媒体模型,且该模型涵盖所有模态,包括视频、图像、语音和音乐,这是因为加入了音乐功能,它也是唯一一个具备此特点的平台。

这次放出的重大更新共有四项:

文本转音乐模型 Lyria 能够让客户从文本提示词着手,进而生成完整的且处于生产就绪状态的素材。

Veo 2 具有新的编辑功能以及摄像机控制功能,这些功能能够帮助企业客户对视频内容进行精确的优化和再利用。

Chirp 3 目前包含了 Instant Custom Voice 。这种方式是一种新的方法,只需 10 秒的音频输入,就能够创建定制语音。

Imagen 3 提升了图像生成的能力,也提升了图像修复的能力。它可以用来重建图像中缺失的部分,还可以用来重建图像中损坏的部分。并且,它能让物体移除编辑的质量变得更高。

Lyria:文生音乐模型

Lyria 可以生成高保真的音频,能够细致地捕捉到那些精妙的地方,并且在多种不同的音乐流派里都能够提供丰富且细节详尽的乐曲。

· 企业可以提升品牌体验

依据品牌独特的调性,能够快速为营销活动定制配乐,能够快速为产品发布定制配乐,也能够快速为沉浸式店内体验定制配乐。

企业借助 Lyria 能够创建出一种声音,这种声音可以与目标受众产生深度的共鸣。同时,还能培养起情感上的联系,并且增强品牌的记忆度。

· 创作者可以简化内容创作流程

视频制作需要音乐,播客也需要音乐,数字内容创作同样需要音乐。对于这些领域来说,寻找完美的免版税音乐是一件事情,这件事情可能会耗费时间,并且是一个比较昂贵的过程。

Lyria 能够在几分钟的时间内生成定制化的音乐曲目,能够直接与您内容的情绪、节奏以及叙事相契合,这样一来,就有助于加快制作工作的流程,同时也能够降低授权的成本。例如:

基调是令人振奋且激烈的。捕捉深夜时爵士俱乐部烟雾缭绕的那种感觉,展示出精湛的技艺以及即兴的创作。要让听众无法安静地坐着。

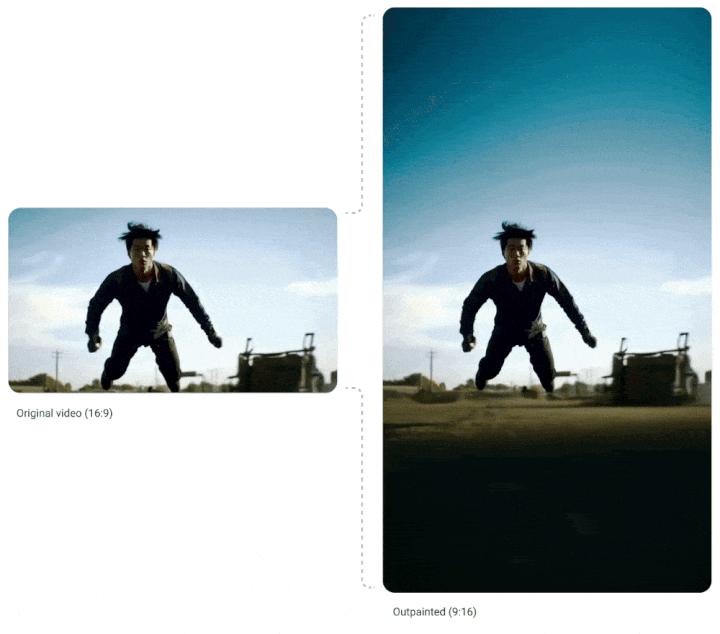

Veo 2:扩展编辑功能

Veo 2 为视频的创建添加了一套强大的功能集,使其能进行视频创建;Veo 2 为视频的编辑添加了一套强大的功能集,使其能进行视频编辑;Veo 2 为视频的视觉效果添加了一套强大的功能集,使其从一个生成工具转变为一个全面的视频创作和编辑平台。

视频修复具有无需手动修饰就能获得干净且专业的编辑效果这一特点。

你能够移除视频里那些不需要的背景图像、徽标或者干扰物,让它们在每一个帧当中都能平滑且完美地消失,看上去就仿佛从未存在过似的。

画面进行扩展,即 Outpainting,它可以将现有视频素材的画面进行扩展,还能把传统视频转化为针对网页和移动平台进行优化的格式。

你能够轻松地对内容进行调整,以适应各种不同的屏幕尺寸以及宽高比。比如,可以把横向的视频转变为用于社交媒体短视频的纵向视频。

新功能包含指导镜头构图,新功能包含指导摄像机角度,新功能包含指导节奏等,这些都应用了复杂的电影拍摄技术。

团队能够轻而易举地运用繁杂的电影拍摄技术,并且不需要繁杂的提示词以及专业知识。

使用摄像机预设来让摄像机向不同方向移动,创建延时摄影的效果,或者生成具有无人机风格的镜头。

· 通过连接两个现有素材创建连贯的视频。

借助插值功能,你能够定义视频序列的起始点和结束点,从而使 Veo 能够无缝地生成连接帧。

这保证了能够平稳地过渡,并且能让视觉保持连续性,进而打造出精致且专业的最终成品。

Chirp 3:即时定制语音和转录功能更新

同时还有 8 种说话人选项。

除此之外,谷歌还新增了两个功能:

即时可定制语音。 可以定制语音。 能够定制语音。 对语音进行即时定制。 为语音进行即时定制。 定制即时的语音。 定制当下的语音。 定制此刻的语音。 定制现在的语音。 把语音进行即时定制。 把语音进行即刻定制。 把语音进行立即定制。 以即时的方式定制语音。 以即刻的方式定制语音。 以立即的方式定制语音。 按照即时的要求定制语音。 按照即刻的要求定制语音。 按照立即的要求定制语音。 依据即时来定制语音。 依据即刻来定制语音。 依据立即来定制语音。 凭借即时去定制语音。 凭借即刻去定制语音。 凭借立即去定制语音。

音频输入只需 10 秒,就能生成逼真的定制语音。这样一来,企业能够对呼叫中心进行个性化设置,还能开发无障碍内容,并且可以建立独特的品牌声音,同时还能保持一致的品牌形象。

带有说话人日志功能的转录,即进行了分说话人标注的转录。

这项功能很强大,能够精确地将多人录音中的单个说话人分离出来并进行识别,还能显著提升转录内容的清晰度以及可用性,并且适用于会议纪要、播客分析和多方通话录音等这些应用场景。

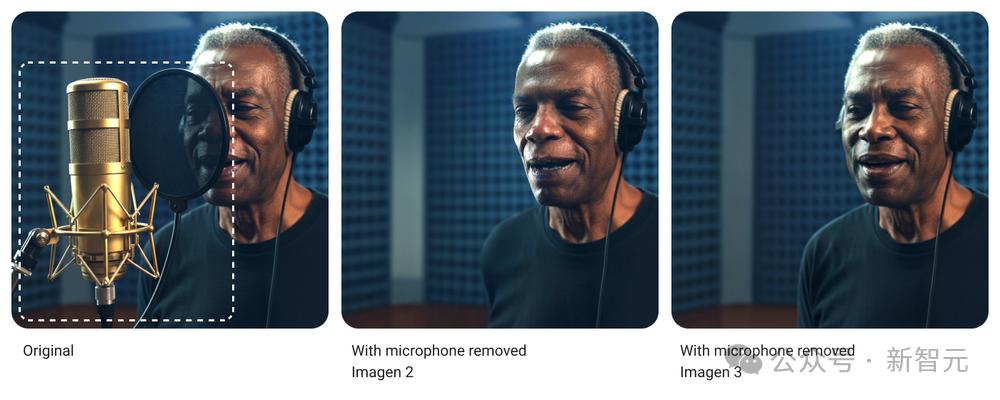

Imagen 3:改进质量和编辑功能

Imagen 3 是谷歌最高质量的文本转图像模型,它能够生成图像,这些图像具有比之前更好的细节,有着更丰富的光照,并且干扰性伪影更少。

这次,谷歌对 Imagen 3 的图像修复(inpainting)能力进行了显著改进,其目的是重建图像中缺失或损坏的部分。

在物体移除方面,质量更高。在物体移除方面,效果更自然。

MCP之后,谷歌再造A2A协议

智能体能够帮助人们完成诸多工作,其中包括订购新电脑;它还能协助客服人员;同时也可以支持供应链规划。

智能体越来越实用,关键在于能在动态的多智能体生态系统里相互协作,并且能够跨越孤立的数据系统以及应用程序。

谷歌为此推出了全新的开放协议,即 Agent2Agent(A2A),并且获得了 50 多家合作伙伴的支持与贡献。

A2A 协议能让 AI 智能体相互进行通信,能够安全地把信息进行交换,还可以在各类企业平台或应用程序上协调行动。

它是一个开放协议,并且与Anthropic 的模型上下文协议(MCP)相互配合、相互补充。

A2A设计原则

A2A遵循了五大核心原则:

A2A致力于让智能体以自然且非结构化的方式进行协作,这体现了对智能体能力的拥抱。

A2A 构建在已有的、广泛使用的标准之上,其中包括 HTTP、SSE、JSON-RPC 等,这是基于现有标准的情况。

A2A 在设计之初就支持企业级别的认证和授权,并且其认证机制与 OpenAPI 保持一致,以此来确保安全性,这体现了默认的安全性。

设计 A2A 考虑了灵活性,能够支持长时间运行的任务。它可以胜任从快速任务到需要数小时甚至数天的深入研究等多种场景,尤其在有人参与的情况下。

智能体的世界并非仅仅只有文本,基于此,我们在设计 A2A 时对多种模态提供了支持,其中包括音频和视频流,以此使它变得更加多样化。

A2A如何工作

A2A 使得“客户端”智能体与“远程”智能体之间的沟通更为顺畅。

客户端智能体承担着制定任务以及传达任务的职责,而远程智能体则负责对这些任务进行执行,并且会尽力提供正确的信息或者采取正确的行动。这个互动包含着以下几个关键功能:

智能体能够借助 JSON 格式的“Agent Card”展示自身能力。客户端智能体依据此“名片”,能够找出最适宜执行某项任务的智能体,并且可以通过 A2A 与远程智能体进行沟通。

任务管理方面,客户端智能体与远程智能体之间的交流是以完成任务为重点的,其目的在于满足用户的需求。

智能体之间能够相互发送消息,同时可以分享上下文,也能够分享回复、产物或者用户指令。

用户体验协商方面,每条消息都包含“parts,”,它是一个完整的内容单元,例如一张生成的图片。

实例:寻找候选人

用户能够让自己的智能体去寻觅符合职位描述的候选人,例如招聘经理就可以这样做。

这个智能体能够与其他专业智能体进行互动,从而帮你去挖掘潜在的候选人。用户在收到推荐名单之后,能够指示智能体安排后续的面试,这样能让找人的过程更加顺畅。在面试结束之后,还可以让另一个智能体来帮忙进行背景调查。

A2A 有希望开启一个智能体相互进行操作的新的时代,并且能够推动创新,构建出更加强大且更加灵活的 AI 智能体系统。我们坚信,这个协议将会为未来开辟道路,使得智能体可以毫无阻碍地进行协作,去解决复杂的问题,进而提升我们的生活。

我们致力于和合作伙伴以及社区一同去公开构建这个协议。我们会将协议进行开源处理,同时为贡献者设置清晰的参与途径。

谷歌AI代码助手,变身超强智能体

此次大会还有一个更新,那就是谷歌的 AI 编码助手——Gemini Code Assist,它已经处于预览状态并且获得了「智能体」能力。

谷歌在 Cloud Next 大会上宣布,Code Assist 如今能够部署新的 AI 智能体,这些智能体能够执行多个步骤,从而完成复杂的编程任务。

这些智能体能够依据 Google Docs 里的产品规格来创建应用程序,也可以把代码从一种语言转换成另一种语言。

Code Assist 现在不仅能在其他编码环境中使用,还可以在 Android Studio 中使用。

这次进行了升级。谷歌被 GitHub Copilot、Cursor 和 Devin 这些竞争者逼得很厉害,所以才有了这次升级。

现在肉眼可以看到,AI 编程蕴含着巨大的掘金市场,并且各家之间的竞争正日益变得白热化。

不过,目前还不清楚 Code Assist 能达到何种程度。研究显示,即便在今天,最好的代码生成 AI 也常常会引入安全漏洞和错误,这是因为其在编程逻辑理解能力方面存在弱点。

一项针对 Devin 的评估显示,它仅完成了 20 项任务里的 3 项。

接下来,我们对 Gemini Code Assist 在实际编程环境中的表现充满期待。

参考资料:

本文源自微信公众号“新智元”,其作者是新智元,36 氪获得了发布的授权。