整理|褚杏娟

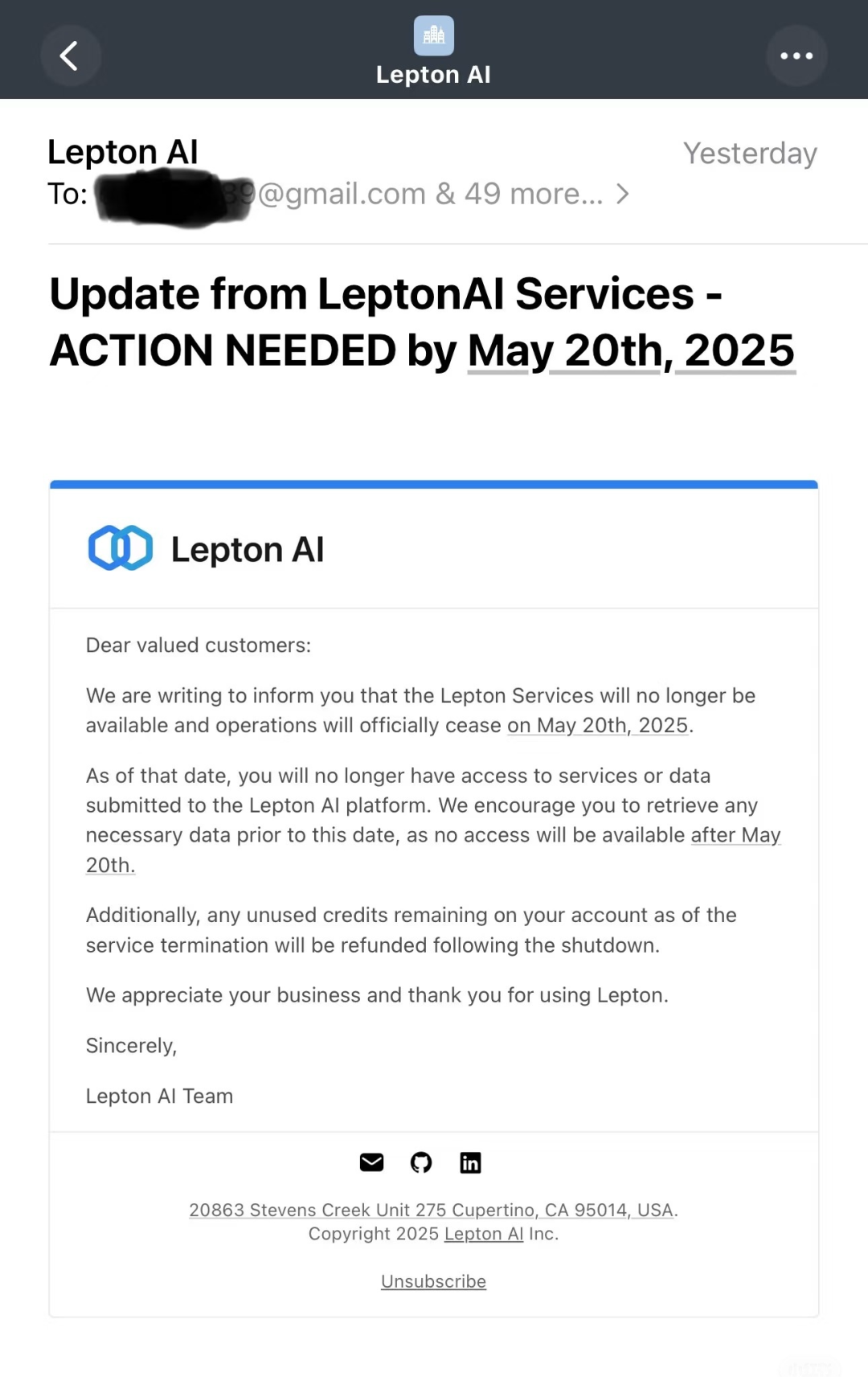

近日,网上有消息称 Lepton AI 已告知用户,Lepton 将于 2025 年 5 月 20 日正式停止其运营。从那时起,用户将无法再对 Lepton AI 平台上的服务进行访问,也无法提交数据。Lepton AI 建议用户在该日期之前,尽快将所需数据进行下载或备份。在服务终止的时候,如果用户账户中还有未使用的积分,官方将会在关停之后对这些积分进行退款处理。

不仅如此,官方网站已经禁止新账户注册,显示正在维护。

Lepton AI 的官方推特显示也已经被注销。

大约两周前,The Information 有报道称,英伟达已经完成了对 Lepton AI 的收购,这笔交易的价值达到数亿美元。据知情人士透露,创始人贾扬清以及联合创始人白俊杰都已经加入了英伟达,不过目前还不清楚他们具体担任的职位是什么。

值得注意的是,黄仁勋始终宣称英伟达是一家软件公司。Lepton Al 的创始团队皆为软件领域的顶尖人才。或许这正是双方相互契合的一个方面。

收购消息刚被曝出来的时候,很多人在猜测英伟达收购之后,是会只留下机器学习人才并且大幅削减业务呢,还是会继续运营 Lepton AI 的云平台。从目前的情况来看,英伟达似乎更注重人才,而不是其相关的具体业务,因为现在已经决定关闭服务了。

交易完成时,Lepton AI 大概有 20 名员工。目前,没有消息表明这些员工的去留情况。英伟达进行的这次收购,价值可能达到数亿美元,使得 LeptonAI 的投资方红杉中国、CRV 和 Fusion Fund 获得了较为可观的退出。大约在两年前,他们参与了该公司 1100 万美元的种子轮融资。

起于“百模大战”

Lepton AI 成立的时间还不足两年。两位创始人在业界颇具声名:贾扬清在攻读博士期间创建并将深度学习框架 Caffe 开源;白俊杰是开放式神经网络交换标准 onNX 的共同创始人以及 Caffe2 的核心开发者。贾扬清曾在谷歌、meta 任职多年,从 2019 年 3 月开始在阿里担任技术副总裁。白俊杰曾在 meta 任职过,也在阿里云任过职。他们两人在担任 AI 研究员期间,一同开发了 PyTorch 框架。

2023 年 3 月,贾扬清从阿里云离职。四个月之后,他宣布联合创立了 Lepton AI。在他们创业之际,国内正处于“百模大战”时期。贾扬清等人没有立刻参与大模型的竞争,而是选择充当大模型的基础设施提供商。然而,他们自身并未购买 GPU,而是通过租用的方式,接着对外提供算力租赁等相关服务。这种模式被称作典型的“人工智能即服务 (AIaaS)”。它是通过云计算平台来预配人工智能 (AI) 服务和工具的。

Lepton AI 的团队主要在海外,因此其目标客户主要是海外企业以及国内有拓展海外市场需求的企业。官网表明,Lepton 的服务主要涵盖以下方面:

全托管的 AI 云平台 Lepton 具备以下功能:它支持模型的开发,也支持模型的训练,还支持模型的部署。其中包括开箱即用的 Serverless 接口,并且兼容 OpenAI API。它还有完全自定义的专属推理接口。同时,它支持运行分布式训练或者批处理作业等。

企业版 Lepton 可以管理节点组,并且能够允许用户利用自有服务器来创建自托管的节点组。

Python SDK,帮助用户构建 AI 应用。

有一个云平台与 Lepton AI 同名,它是专门为 AI 工作负载进行优化的。用户能够在这个平台上开展模型训练和推理工作。该公司提供了一个可视化的界面,以此来帮助用户在其云平台上对训练集群进行配置。并且,这个平台支持多款 Nvidia 显卡可供选择。对于那些需要并行训练多个模型的团队来说,该平台还提供了一种工具,这种工具可以集中管理每个项目所分配的硬件资源。

在模型训练期间,有时会出现致使输出质量下降的错误。Lepton AI 的平台具有能够检测这类错误的功能,并且还可以发现更隐蔽的技术问题,例如神经网络在训练过程中使用了超出预先设想的内存等情况。

Lepton AI 用户在模型开发完成后,可以把模型部署到平台所提供的推理优化实例上。平台承诺在推理过程中能达到每秒超过 600 个 token 的处理速度,并且能将延迟控制在 10 毫秒以内。平台还有自动扩展的功能,一旦推理需求上升,就可以自动为客户增添计算资源。

Lepton AI 采用开源工具 vLLM 以加速推理。这种技术可以把相似的大模型提示合并成一次请求,如此一来就能减少模型需要处理的计算量。并且,开发者能够借助 vLLM 降低模型的内存占用。

贾扬清此前在接受 InfoQ 《大模型领航者》栏目采访时讲道,团队在技术实现方面并未使用什么“黑科技”,而是把许多大家都熟悉的单点技术进行了结合,借此实现了成本的显著降低。例如,当大模型处理服务收到大量请求时会采用动态批处理(Dynamic Batch),以及用小模型来预测数个 token 的预测解码等。具体如何实现单点技术的有机结合,就是他们工作的重点和难点。

团队在这期间基于 Lepton 制作了一些产品 demo。例如,贾扬清在他的社交平台上分享了自己基于 Lepton Al 所实现的 AI 搜索引擎(类似 Perplexity),并且仅仅使用了不足 500 行的代码。此项目当时引发了大家的热烈讨论,如今已经开源,获得了 8.1k 颗星。

Lepton Al 开源了 GPUd ,其目的是通过主动监控 GPU 以及有效管理 AI/ML 工作负载,从而确保 GPU 的效率和可靠性。据悉,GPUd 是基于团队历经多年在 meta、阿里云、Uber 以及 Lepton AI 等平台上运营大规模 GPU 集群所积累的经验而构建的。它能够与 Docker 实现无缝集成,也能够与 containerd 实现无缝集成,还能够与 Kubernetes 实现无缝集成,同时也能够与 Nvidia 生态系统实现无缝集成。

贾扬清曾表示,通过这些产品,我们能够展示自身在开源模型方面所能做的事情,同时也能展现 Lepton 平台帮助用户构建应用的能力。团队期望通过这些产品或 demo,在用户当中形成良好的口碑,当有人需要部署大模型时,就会想到 Lepton AI。

贾扬清对最新的大模型进展思考积极进行对外分享。例如,DeepSeek 爆火之后,贾扬清分析指出,它的成功更多地体现了纯粹的智慧以及务实的态度:在计算资源和人力有限的情况下,凭借聪明的研究方法,产出了最好的成果。这与当年 Alex Krizhevsky 在仅拥有两块 GPU 的情形下构建出 AlexNet 模型的情况相同,凭借的并非超大规模的集群,而是扎实的能力。

目前,贾扬清的 x 分享停留在了 3 月中旬。

止步于算力巨头的野望

AI 爆发之后,面临的主要问题是缺少算力。许多企业为了减少投入,采取了“由买转租”的方式,这种方式促使了算力租赁的诞生,并且算力租赁的价格在一年时间内就能够实现翻倍。

欧洲地区仍是算力租赁市场的主导者。CoreWeave 是以挖矿为开端的。英伟达通过投资支持以及供货保障等方式对 CoreWeave 进行了扶持。CoreWeave 运用“GPU 即服务”(GAAS)的模式,它拥有 32 个数据中心,这些数据中心运行着超过 25 万 + 的 GPU 。它主要为微软、英伟达、OpenAI、meta、Google 等北美大型客户提供服务。而欧洲本地的云服务商 Nebius 在芬兰拥有一个数据中心,这个数据中心部署了约 2 万个 GPU 。Nebius 得益于欧洲扶持政策,凭借短期租赁的性价比而取胜。同时值得注意的是,Nebius 还获得了英伟达的投资。

值得注意的是,Lepton AI 与英伟达的若干主要客户存在服务竞争关系,这些客户中包含 AI 云服务商 CoreWeave。去年 6 月,贾扬清曾透露,Lepton AI 的客户数量在增长,整体营收也在增长,且处于非常健康的状态,他对此感到满意,这验证了团队之前的想法以及产品在用户中的接受度。

英伟达此次收购 Lepton Al 的目的,业内有猜测。其目的是想完全掌控供应链,并非仅仅负责制造部分。英伟达没有选择只出售显卡或 AI 芯片,而是选择提供完整的解决方案,即自己开发芯片、组装服务器,然后提供租赁服务。这就是人们常说的“垂直整合”,也就是一家公司掌控从上游到下游的整个流程。

这种垂直整合策略使得英伟达可以从芯片设计这一环节,一直到算力租赁的全产业链中获取利益。并且,它还能够更好地对其 GPU 芯片的使用方式以及价格策略进行掌控,从而进一步强化了它在 AI 计算领域的主导地位。

这一策略使英伟达成功避开了行业中常见的库存积压问题。在市场降温、销量下滑时,许多公司常因大量滞销设备而受拖累。然而,如果英伟达能够自己出租服务器,就能够让设备一直处于运转状态,并且还能继续从中获得盈利。

SemiAnalysis 指出,英伟达收购 Lepton 后,一方面获得了额外的收入来源;另一方面,可能会挤压其他云服务提供商的生存空间。同时,英伟达打造这套自有体系后,更有能力与亚马逊、谷歌和微软等巨头竞争。这些巨头也在 AI 领域进行布局,并且采用定制芯片(即常说的 ASIC)来提供服务。

黄仁勋在今年 3 月的 GTC 大会上有这样的表示,他认为英伟达不再仅仅是一家芯片公司,也不再仅仅是一家 AI 公司,而是一家算法和基础设施公司,这也与他的想法相契合。

英伟达目前正在投入精力构建 AI 基础设施,其规划周期需要在上游和下游都延伸多年。黄仁勋期望把英伟达打造成一个 AI 工厂,使其能够直接成为客户的收入来源。他表示每个行业、每个国家、每家公司都会来到这里,因为英伟达已经成为一个基础平台,其他公司可以依托这个平台构建自己的业务。